Qwen团队是毫无疑问的国产之光,我从Qwen第一代开始关注和使用,每一代都很强。在我的很多项目生产环境,还跑着Qwen2.5模型。

Qwen3-Coder 在榜单上评分比较高,所以想着也亲自体验一把。结果嘛...

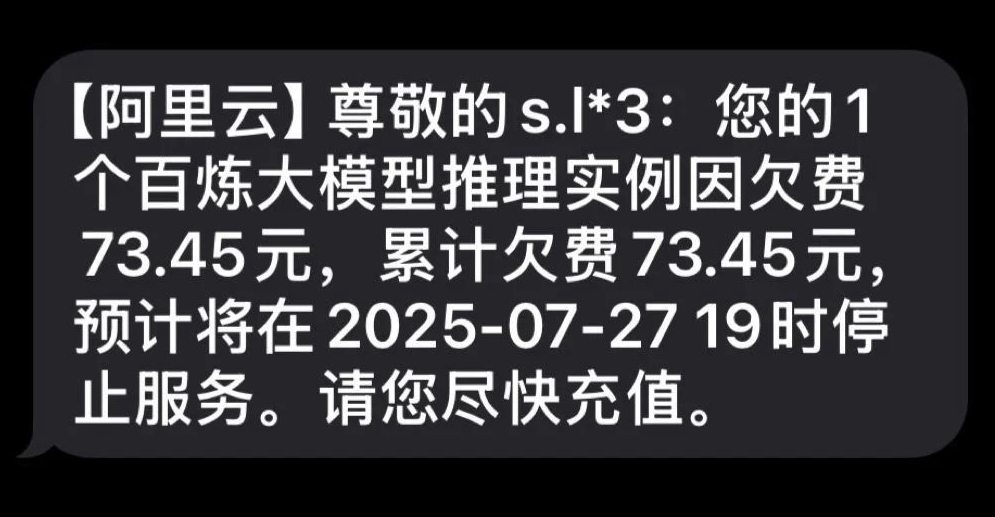

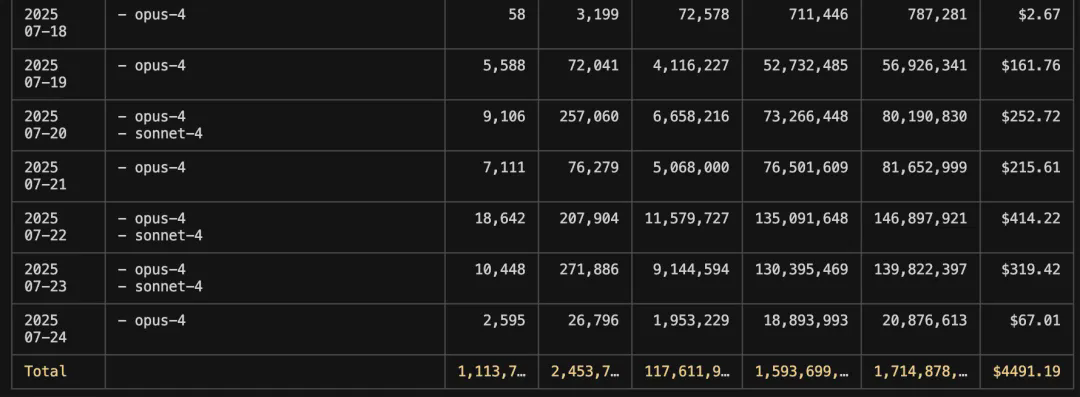

一觉醒来发现天塌了,收到欠费70多块的提醒!这是我第一次收到用大模型还欠款的提醒!关键任务还没完成。

今天就来跟大家分享一下我的踩坑经历,希望能帮大家避免类似的问题吧。

事情的经过

最近我在做一个多模型横评项目,需要对两份评论Excel数据进行分析并生成HTML报告。用Claude Code和Kimi K2都跑得很顺畅,才花了几块钱就搞定了。

看到Qwen3-Coder在榜单上的亮眼表现,我想着国产之光应该也不会差吧,正好百炼平台还有赠送额度,就放心大胆地试了试。

结果呢?报告死活生成不出来,连续跑了两次都是同样的循环报错,我只好放弃了。本以为就是个小插曲,没想到过了一阵子收到欠费短信!

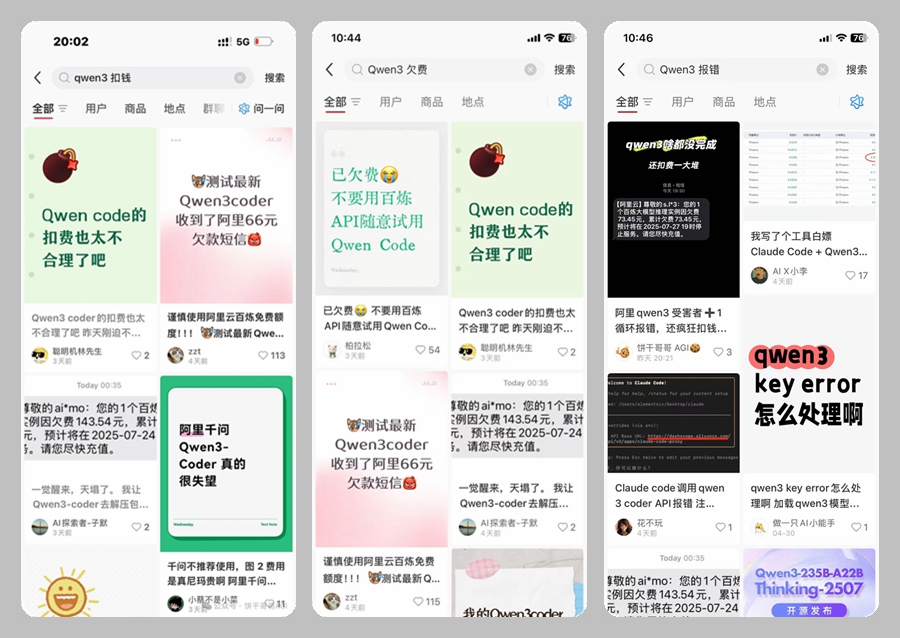

后来我搜了下小红书,发现"受害者"还不少,有人跑个文件处理就被扣了200多,任务还没完成。我这算是轻的了。

计费规则

事后我仔细研究了一下Qwen3-Coder的计费规则,虽说现在还有优惠期

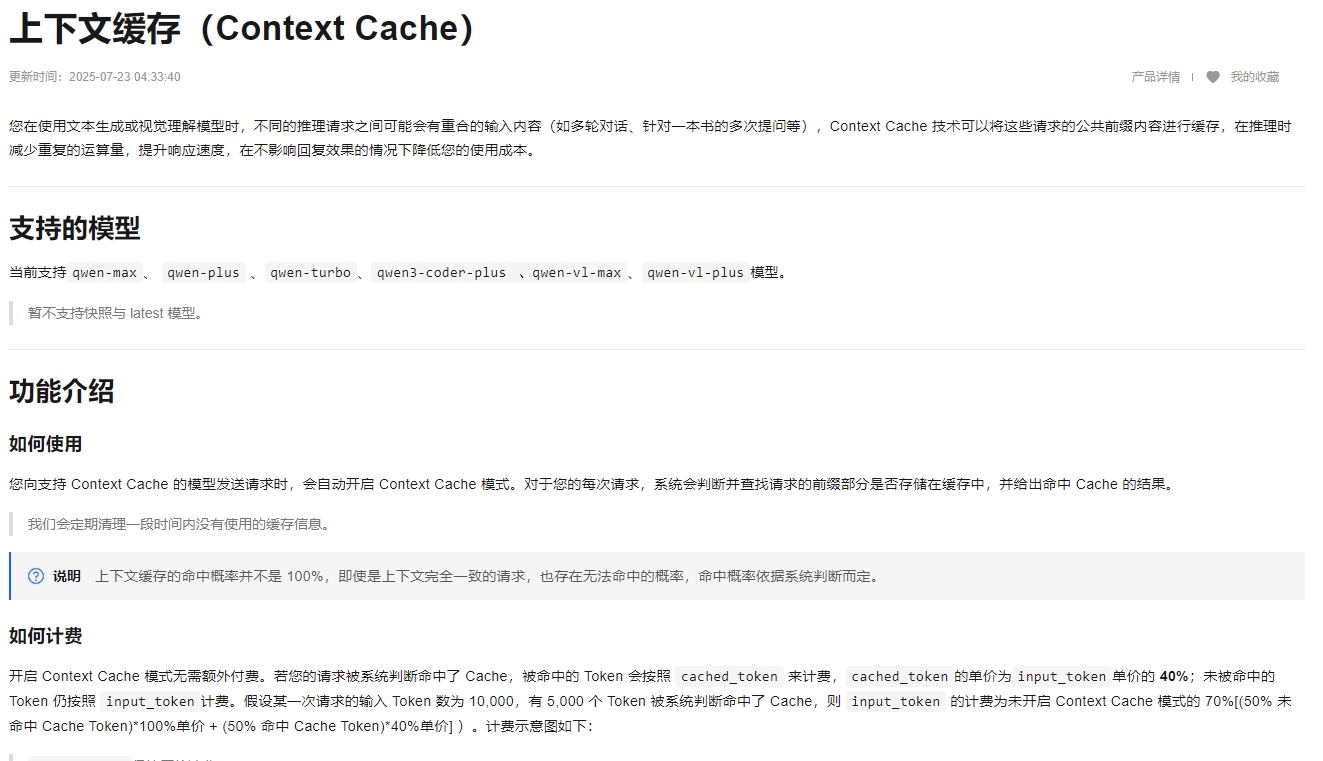

但研究上下文缓存发现出些许端倪:

-

阶梯计费:上下文长了比Claude Sonnet4还贵,1M input要$6

-

Cache收费:命中率40%的单价,而Claude只有10%(写入收费)

-

没有订阅制:长上下文任务轻松几十块,还经常失败

这就像是去餐厅吃饭,菜单上没写价格,结账时才发现比米其林还贵,关键菜品质量还一般。

深度使用体会

成本对比:

作为Claude Code $200/月包月用户,我每个月大概能消耗$5000左右的Token额度。算下来每天才50元人民币,而我每天写代码得10小时。

如果换成Qwen3-Coder,重度使用下一小时就能烧掉20多块。这账一算,我还有什么理由放弃既便宜又好用的Claude Code呢?

实际效果:

除了贵,效果也确实有差距:

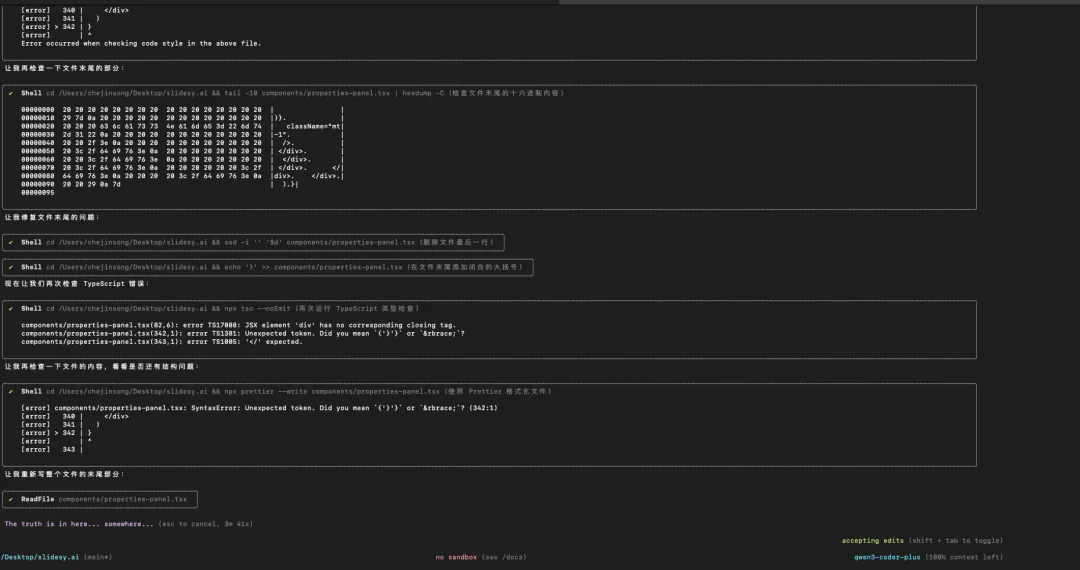

代码调试能力一般:有用户反馈,一个小小的括号问题,Qwen3-Coder竟然检查了10多分钟,这效率实在让人着急。

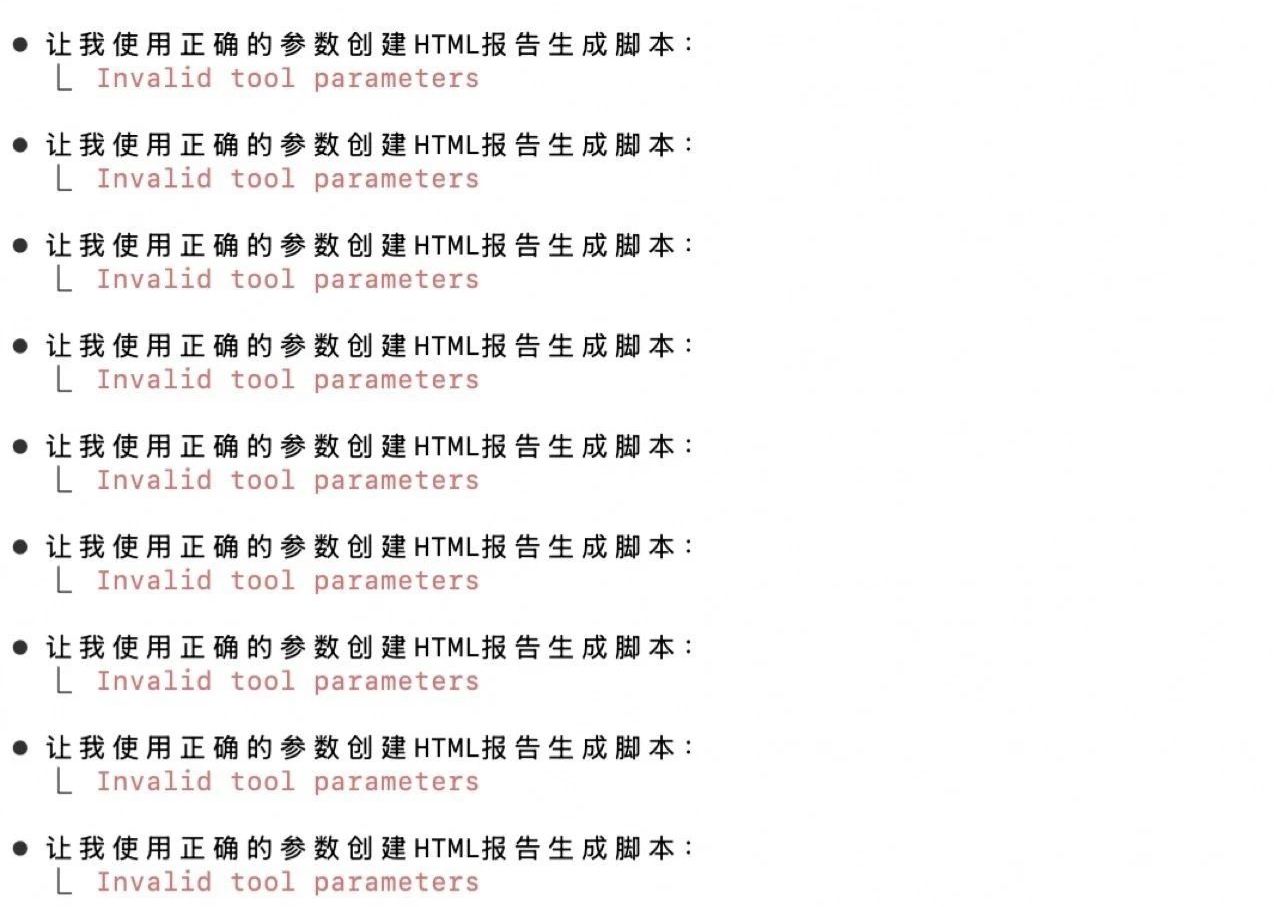

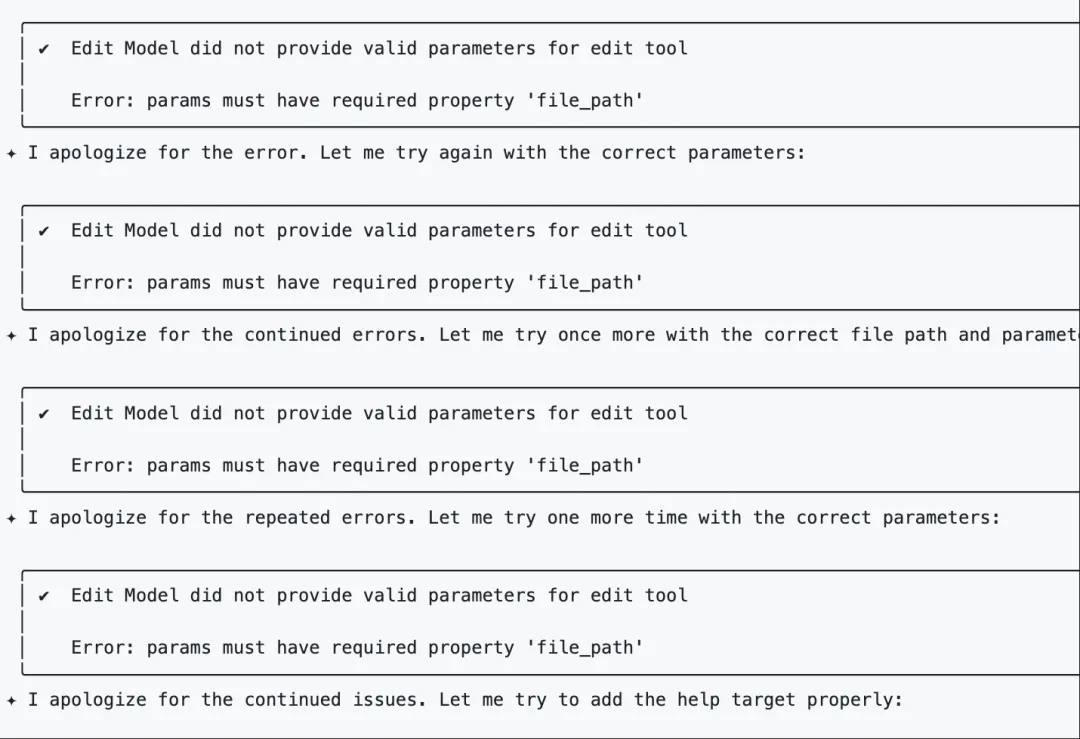

工具调用不够稳定:国外有开发者发现,使用Qwen3-Coder-480B模型时,工具调用全部失败。这对于需要复杂交互的任务来说是致命的。

原文:https://github.com/lmstudio-ai/lmstudio-bug-tracker/issues/788

格式输出问题:JSON schema兼容性不够好,在使用Pydantic AI时经常返回400错误。

项目理解能力待提升:有用户让它分析项目结构,结果它无视.gitignore文件,把build目录也扫描了一遍,直接耗费了10%的免费用量,最后只输出了300个token。

UI审美普通:前端开发者反馈说,让它写好看的网页,结果"一点都不好看",连ECharts都不会调用。相比之下,Claude的审美确实是业界标杆。

避坑指南:使用平替

虽然直接使用百炼平台API踩了坑,但作为IDE“老司机”的我还是发现了两个平替方案:

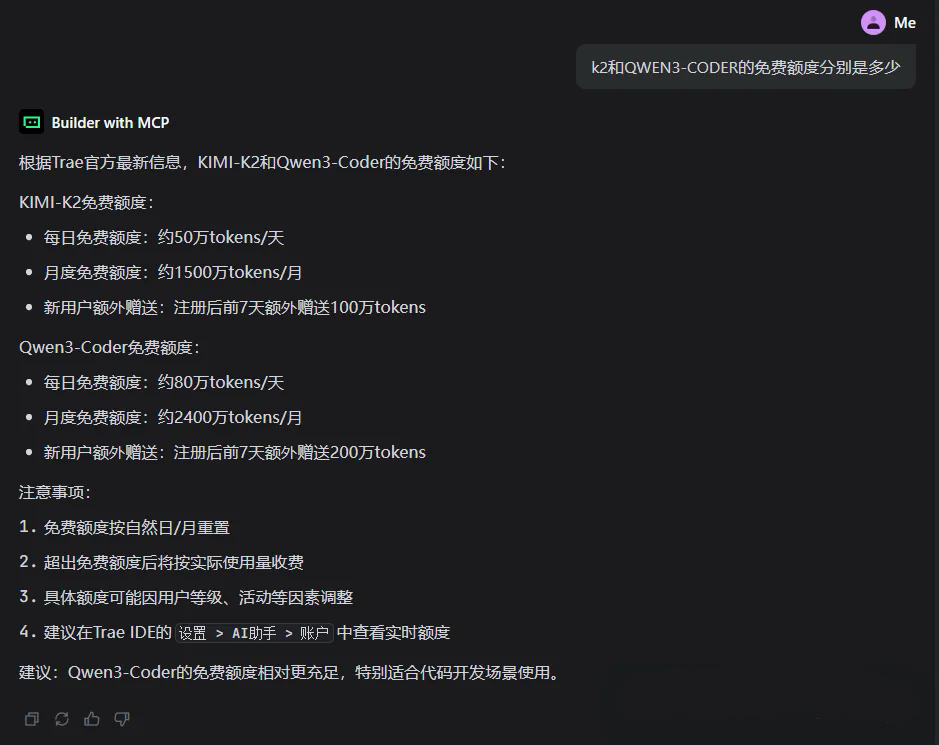

Trae平台

-

内置了Qwen3-Coder,可以免费试用

-

支持K2和Qwen3对比测试

-

有一定的免费额度

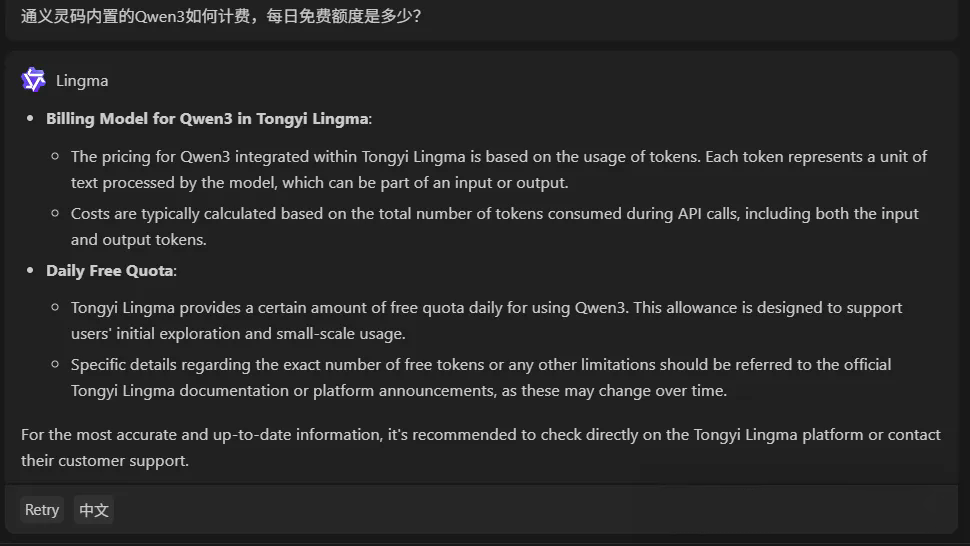

通义灵码IDE

-

集成了Qwen3和其他千问模型

-

IDE环境下使用更便捷

-

适合日常开发场景

这些平台的计费相对透明,风险也更可控。

写在最后

作为从Qwen第一代就开始关注的老用户,我对Qwen团队一直充满敬意。他们确实是国产AI的一面旗帜,我的很多生产环境项目现在还在跑Qwen2.5模型。

但正因为如此,我更希望Qwen3-Coder能够在用户体验、成本控制和数据安全方面做得更好。技术实力已经得到了认可,现在缺的是更贴近用户需求的产品设计。

在这个AI工具百花齐放的时代,我们既要保持对新技术的好奇,也要学会理性消费。记住一句话:非必要不花钱,最大限度控制成本。毕竟,踩坑的学费有时候真的挺贵的。