,而且还有每日白嫖额度,那不得赶紧的来一手~

发现美团的 LongCat 系列更新速度真是惊人。三周前才发了 LongCat-Flash,没多久生活 Agent 小美也在内测,如今又直接放出了 LongCat-Flash-Thinking。这更新节奏也太快了吧。

测试接口的同时苏米也去了解了一下 LongCat-Flash-Thinking模型

LongCat-Flash-Thinking模型

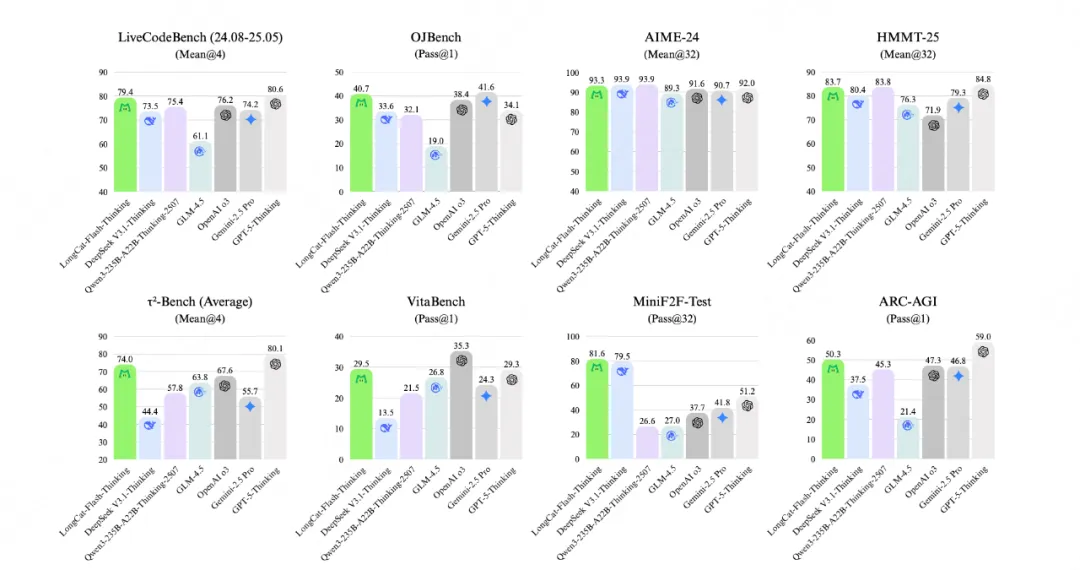

美团 LongCat 团队正式发布全新高效推理模型 LongCat-Flash-Thinking,综合评估显示,LongCat-Flash-Thinking 在逻辑、数学、代码、智能体等多个领域的推理任务中,达到了全球开源模型的最先进水平(SOTA)。

同时,LongCat-Flash-Thinking 不仅增强了智能体自主调用工具的能力,还扩展了形式化定理证明能力,成为国内首个同时具备「深度思考+工具调用」与「非形式化+形式化」推理能力相结合的大语言模型。

它不仅延续了 LongCat-Flash-Chat 的极速响应,还在数学、逻辑、代码、智能体任务上做了显著增强。官方宣称它在多个权威基准测试上已经超越了 OpenAI 的 o3 模型。

-

ARC-AGI(通用推理):提升 6.34%

-

AIME-24(数学推理):提升 16.4%

-

LiveCodeBench(代码能力):提升 4.20%

-

τ2-Bench-Airline(智能体能力):提升 9.47%

这些数据一眼看上去挺硬核,但对我这种日常要写点代码、验证逻辑链路、或者测试智能体场景的人来说,推理链条可以走得更顺。

为什么美团要自己做大模型?

大厂做模型的理由很多,但美团的护城河很清晰:本地生活数据,昨天还在聊,美团这边也在紧锣密鼓更新自己的大模型。

想象一下,你常点的外卖、常去的店铺、看过的电影、甚至什么时间段最喜欢点单,这些行为数据都是独一份。对比起其他大模型只能泛泛回答,美团的模型就有可能在推荐、理解用户需求上更“懂你”。

-

点单的时候不需要等五六分钟,响应一定要快

-

推荐的时候不是随便来个结果,而是真正贴合你的习惯

LongCat-Flash-Chat API

我还顺手试了下 LongCat-Flash-Chat 的 API。

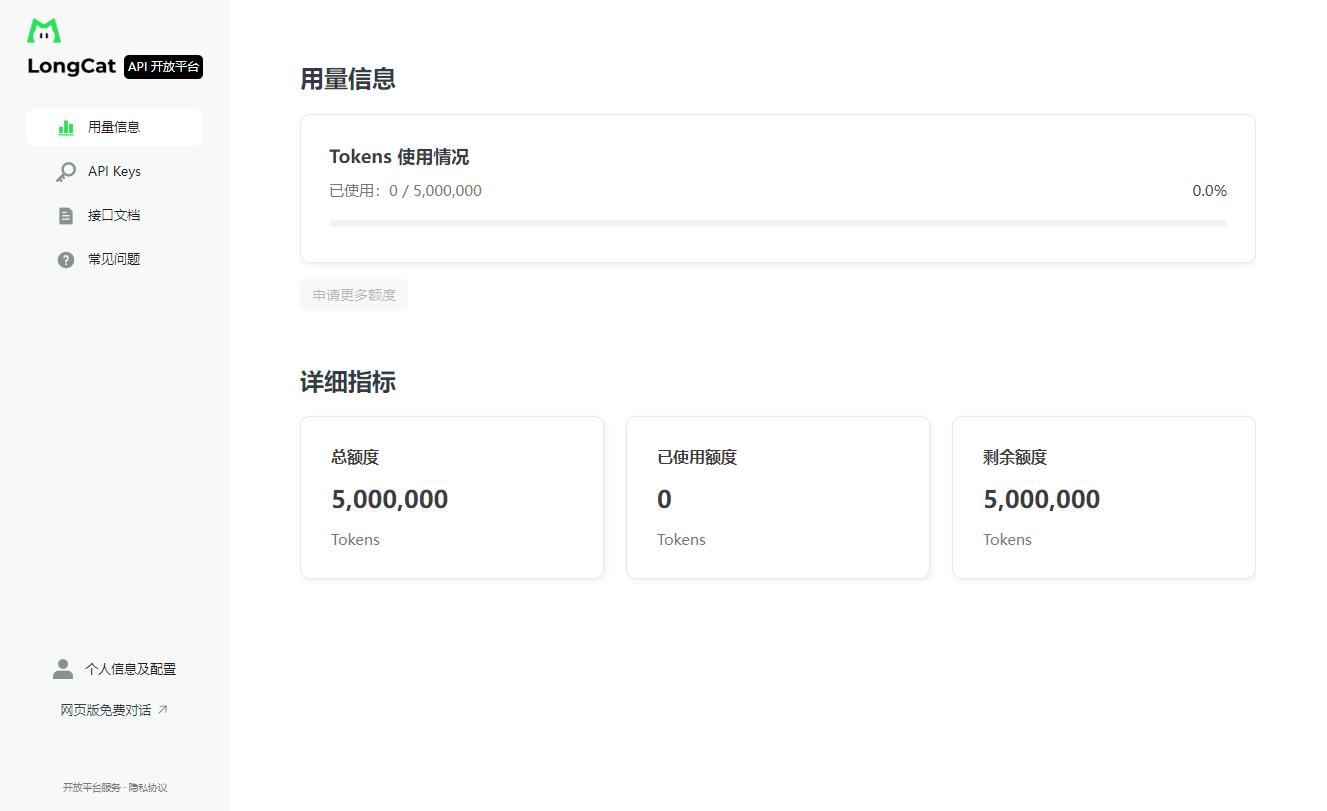

在平台上申请 API Key 很快,通过美团账号就能登录。每天有 10 万 tokens 免费额度,够日常测试用了(不过要注意额度每天清零,不累计)。

根据佬友的分享还可以点申请更多额度写申请提到每天 500 W tokens,苏米测试已经申请成功了,步骤很简单,大家可以趁人还不多抓紧试试~

根据个人的真实使用需求填一下,几分钟就过了,如果没有就等等(公司和职位可以不填)

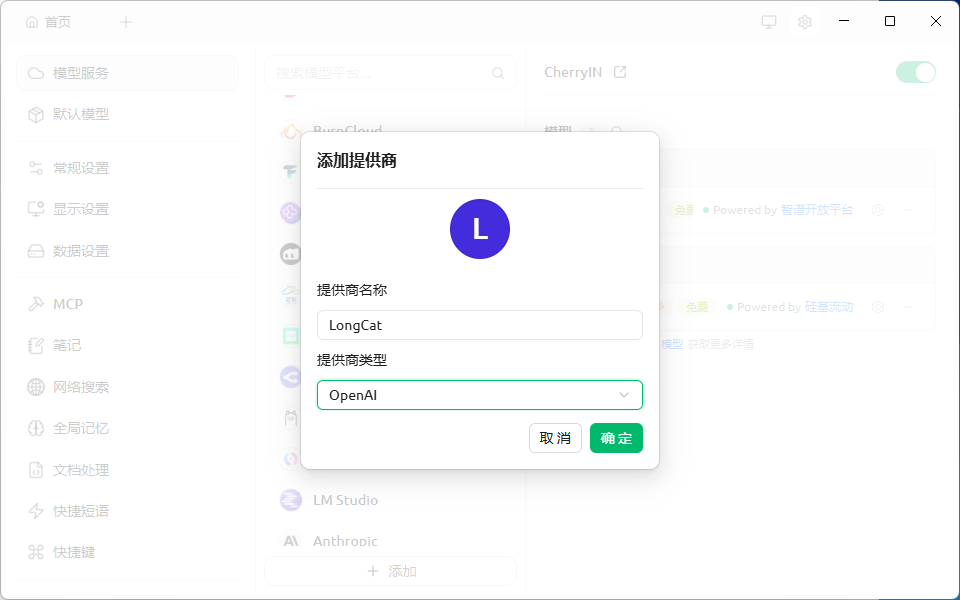

LongCat-Flash-Chat 的 API 支持OpenAI和Anthropic两种API格式,所以常见的需要API的基本都能适配,甚至可以接上Claude Code,不过苏米今天先简单测试一下Cherry Studio对话。

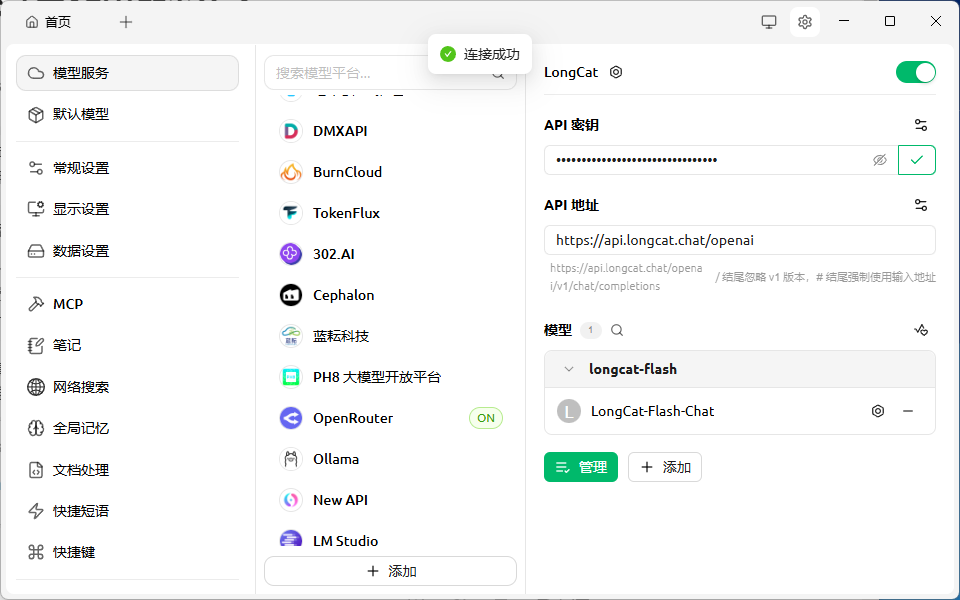

接入Cherry Studio测试

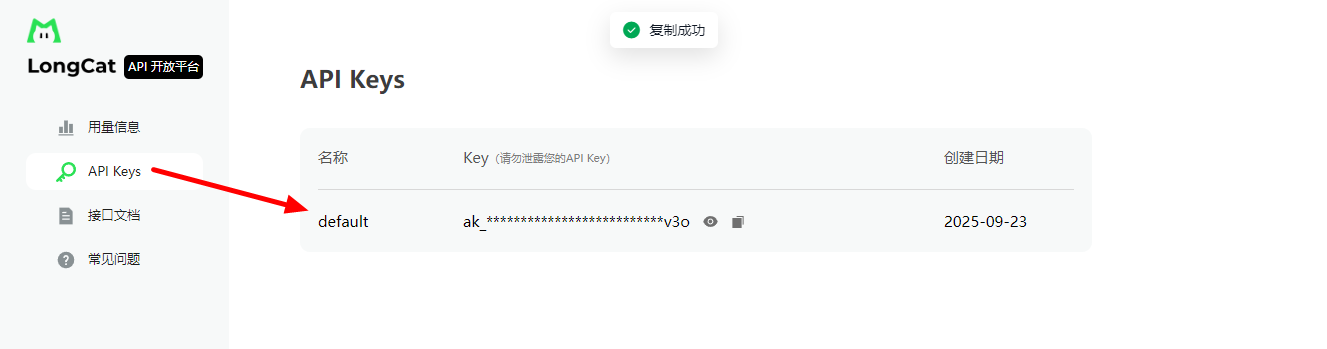

需要在开放平台先申请一下API key,这个登录后就有了

在Cherry Studio上「默认模型」- 「添加提供商」填写名称,提供商就选OpenAi

接着填入API key和API 地址:https://api.longcat.chat/openai

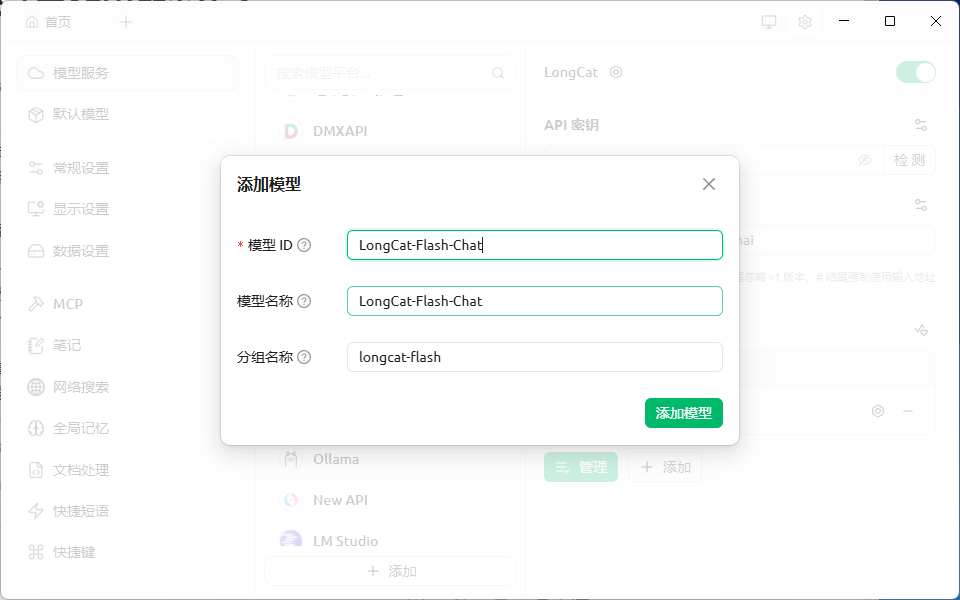

默认没有模型需要添加一下「LongCat-Flash-Chat」模型就可以了

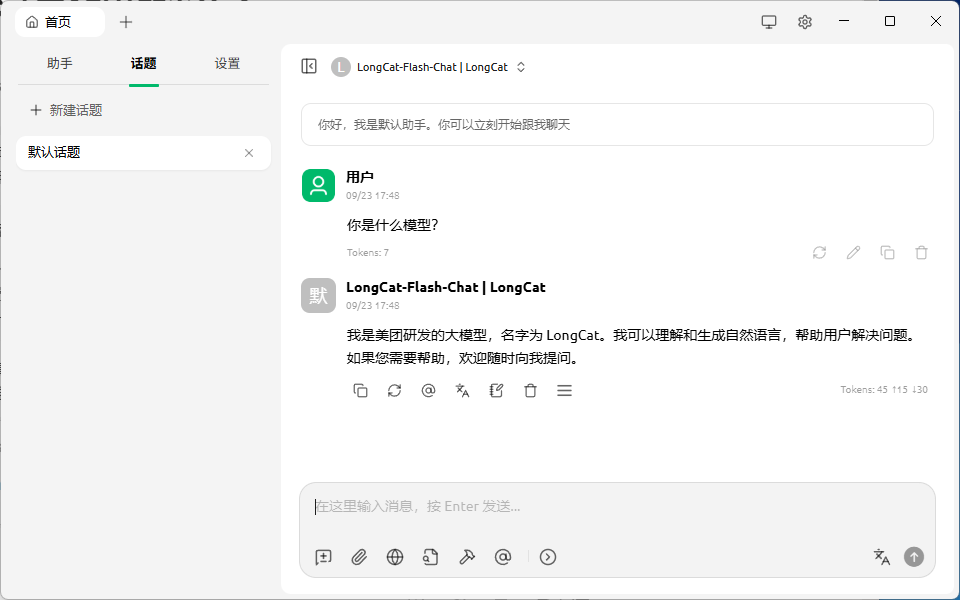

直接问一下,看看结果~

每日免费额度

-

每个账号每天自动获得 100,000 tokens 免费额度

-

免费额度将于每日凌晨(北京时间)自动刷新

-

前一天未使用完的额度将清零,不会累积到下一天

额度使用说明

-

输入和输出tokens均计入消耗

-

流式接口和段式接口消耗相同

额度查询

额度使用情况可访问实时查看

注意:平台目前处于公测阶段,暂不支持付费购买额度。

总结

如果你跟我一样喜欢折腾各种 API,不妨去试试 LongCat 的开放平台,免费额度足够探索一番。

或许不久之后,我们日常点外卖、订电影票时,背后的智能推荐系统,都会跑在 LongCat-Flash-Thinking 上

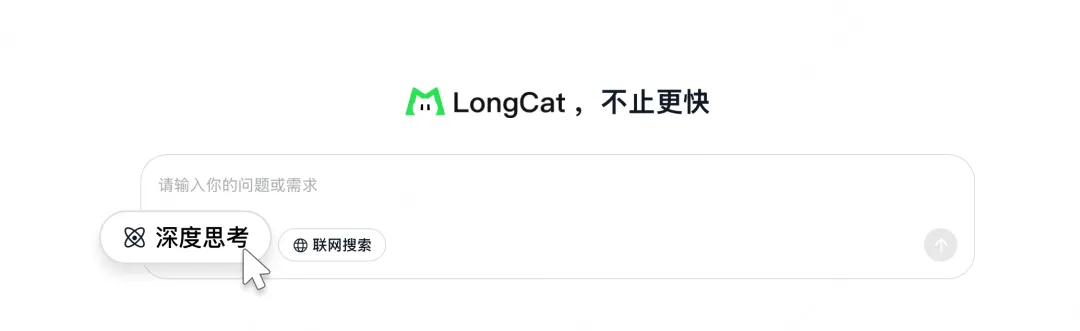

体验地址:https://longcat.ai/

可以在线使用 LongCat-Flash-Thinking 的深度思考功能,也可以接API测试

目前, 该模型也已在HuggingFace、Github全面开源:

Hugging Face:https://huggingface.co/meituan-longcat/LongCat-Flash-Thinking

Github: