作为产品经理,我一直在关注AI大模型的工程化应用能力。

最近MiniMax发布了M2.1版本,核心升级点是在多语言全栈开发领域的表现。

与其他模型不同的是,M2.1不再只专注于前端展示效果,而是在Web、App、后端服务等多个技术栈上都有实质性的能力提升。

这引起了我的注意——因为这意味着从产品原型设计到实际工程交付的全流程,都有可能被这个模型支撑。。

Claude Code+MiniMax M2.1

以下步骤以macOS + Claude Code为例。

Windows/Linux用户可用相同逻辑调整。

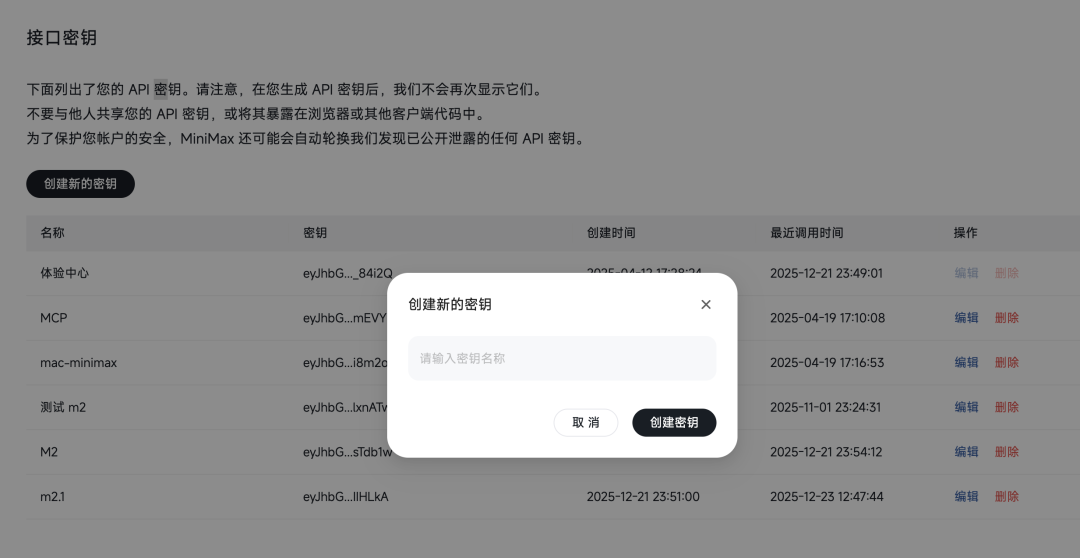

第一步:创建API密钥

创建新密钥,复制并安全保存(该密钥仅显示一次)

第二步:安装Claude Code

在Terminal中执行:

npm install -g @anthropic-ai/claude-code安装完成后输入claude-code验证安装状态。

第三步:环境变量配置

打开Terminal,执行以下命令配置环境变量:

export ANTHROPIC_BASE_URL="https://api.minimaxi.com/anthropic"

export ANTHROPIC_AUTH_TOKEN="your-api-key-here"

export API_TIMEOUT_MS="3000000"

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC="1"

export ANTHROPIC_MODEL="MiniMax-M2.1"

export ANTHROPIC_SMALL_FAST_MODEL="MiniMax-M2.1"

export ANTHROPIC_DEFAULT_SONNET_MODEL="MiniMax-M2.1"

export ANTHROPIC_DEFAULT_OPUS_MODEL="MiniMax-M2.1"

export ANTHROPIC_DEFAULT_HAIKU_MODEL="MiniMax-M2.1"(将your-api-key-here替换为实际密钥)

第四步:启动验证

打开Claude Code,若界面显示"MiniMax-M2.1",说明配置成功。

成本优化建议

如果日常开发量较大,可考虑订阅MiniMax的Coding Plan,该计划已集成M2.1模型,并支持图形识别、联网搜索、MCP等功能。

总结

经过多个场景的实测,我对MiniMax M2.1的能力有了清晰的认知:

1. 全栈覆盖,不再偏科

不同于以往某些模型只在前端Demo上表现突出,M2.1在Web前端、移动端(iOS/Android)、后端服务(Java、Go)、系统编程(C++、Rust)等多个技术栈都有实质性的工程化能力。这对产品和技术团队而言意味着一个统一的AI助手可以支撑从设计原型到生产上线的全过程。

2. 指令遵循与增量开发

在与M2.1的对话式编程中,它能准确理解需求的递进变化,逐步交付代码而不破坏已有部分。这大幅降低了迭代成本。

3. 工程规范意识

它不仅能生成功能代码,还能理解项目结构、资源管理、依赖配置等工程层面的要求。这接近于真实研发工程师的思维方式。

4. 速度与质量的平衡

从我的实测来看,代码生成速度和输出质量与业界顶流模型(Gemini 3 Pro、Claude Opus、ChatGPT-5)相当,且成本更优。

从产品经理的角度,这意味着我们在评估AI编码工具时,不应只看单一维度的表现(如前端展示效果),而应考察其在实际工程流程中的完整适配度。M2.1在这方面给了我不少启发。

如果你也在探索AI工具在团队中的应用,不妨按照上述步骤配置M2.1进行实测。基于实际场景的验证永远比概念描述更有说服力。