前几天Anthropic刚出的禁止中国企业使用Claude的限制,Anthropic又来整活!

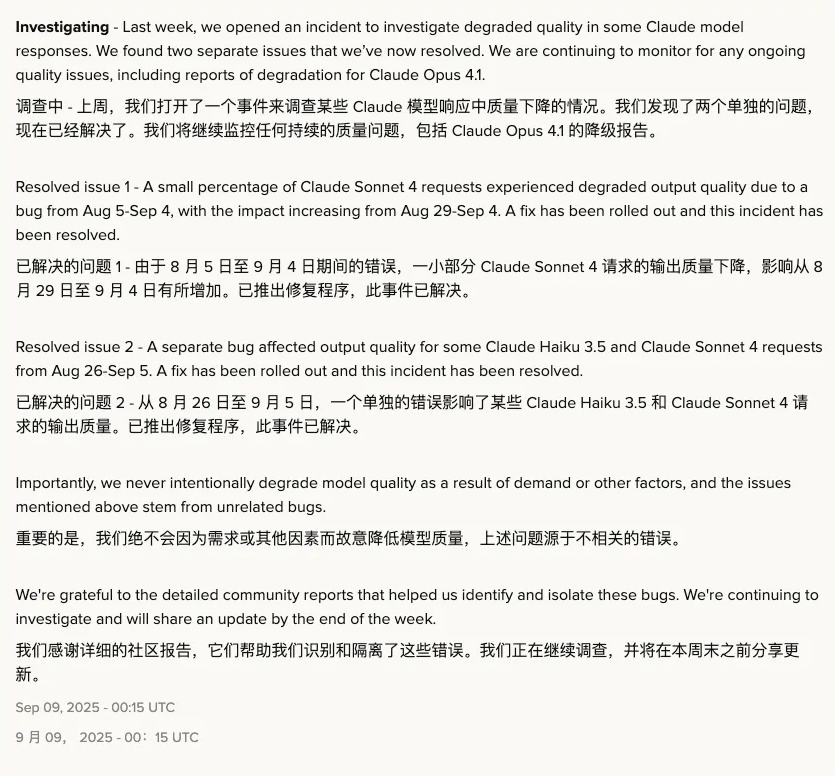

就在昨天,Anthropic 官方发布了一份事件报告,承认 Claude 在过去一个月内确实出现过质量下降的问题。

这让我回想起最近几次写代码时,它的表现:答非所问、逻辑混乱、甚至一些基础代码都写得奇奇怪怪。现在想想,原来问题不在我,而是模型本身。

官方承认了

根据官方报告,这次问题主要来自两个 bug:

第一个 bug:影响了 Claude Sonnet 4 的部分请求,从 8 月 5 日持续到 9 月 4 日,并在 8 月 29 日到 9 月 4 日这段时间影响特别明显。

第二个 bug:同时波及到 Claude Haiku 3.5 和 Claude Sonnet 4,时间范围是 8 月 26 日到 9 月 5 日。

这还不是第一次。早在 8 月 30 日,Claude Opus 4.1 和 Opus 4 也出现过类似问题。

官方解释说是因为“推理堆栈的推出”出了差错,现在已经回滚修复。

听上去像是一场技术事故,但对我们这些重度用户来说,影响可不是小事。

技术问题or信任危机

前几天 Anthropic 才刚刚限制了中国区用户的使用,现在又爆出大规模的“降智事件”,不少朋友已经开始转向别的工具。

身边就有人开始尝试 Codex,最近也越来越多人在聊国产替代方案,比如 Kimi K2、GLM4.5、DeepSeek V3.1 等等。

对我们来说,AI 编程助手已经不是玩具,而是真正的 生产力工具。

当它突然失灵,带来的挫败感就像 IDE 一直报错,或者线上环境突然崩溃。Claude 曾经的优秀体验让人产生了依赖,但这种“不稳定”真的很伤信心。

建议

结合这次经历,我想给大家几个实用的小建议:

不要完全依赖 AI:再好用的工具,也不能替代架构决策和关键代码的 review。

准备备选方案:别只靠一个模型,多试试其他工具。

保持怀疑态度:如果发现回答质量突然下降,别急着怀疑自己,先想想是不是模型出 bug 了。

关注官方动态:Anthropic 这类厂商通常会发事件报告,及时跟进可以少踩坑。

写在最后

说句心里话,Claude Code 真的帮我解决过很多问题,也让我写代码的效率提升不少。但这种“突然降智+迟迟不告知”的体验,让人很难完全信任。

也许 AI 编程助手的赛道还处在快速迭代阶段,问题会反复出现,但我更期待一个能让我放心依赖的工具。毕竟,生产力的核心就是“稳定可靠”。