作为一名产品经理,我经常需要快速验证产品想法、生成原型代码或处理一些重复性的技术工作。

最近我发现了 OpenCode 这个工具,它让我可以免费接入多个企业级 AI 模型(Gemini、Claude 等),大幅降低了我的工作成本。

这篇教程会详细记录我的实践过程,希望能帮助你也建立起这套高效的工作流。

第一部分:OpenCode 基础配置与模型接入

1. 环境准备阶段

在开始之前,你需要准备:

- 已安装 OpenCode 开发环境

- Google 账号(用于接入 Gemini)

- ChatGPT Plus 账号(可选,用于接入 GPT Codex)

- 命令行工具的基本使用能力

2. 通过 Antigravity 接入 Gemini 和 Claude

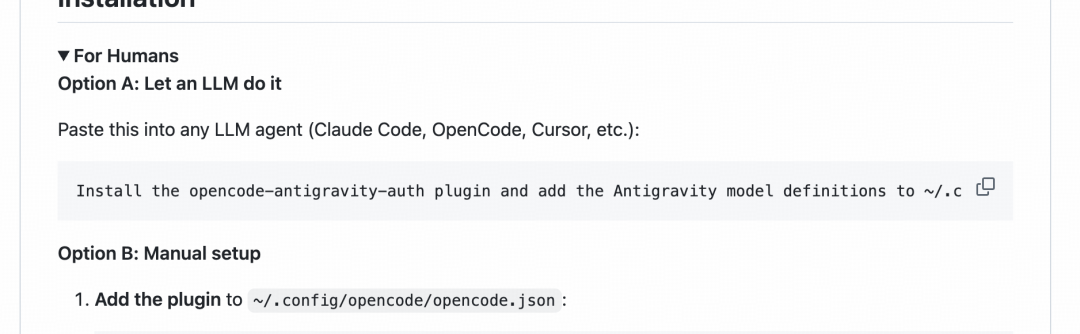

第一步:获取安装代码

访问官方插件地址:https://github.com/NoeFabris/opencode-antigravity-auth

找到 Install 部分的代码内容,将其复制。

这段代码包含了模型初始化的必要参数。

第二步:在 OpenCode 中执行安装

打开 OpenCode 界面,在对话窗口中粘贴复制的代码内容,系统会自动开始安装流程。

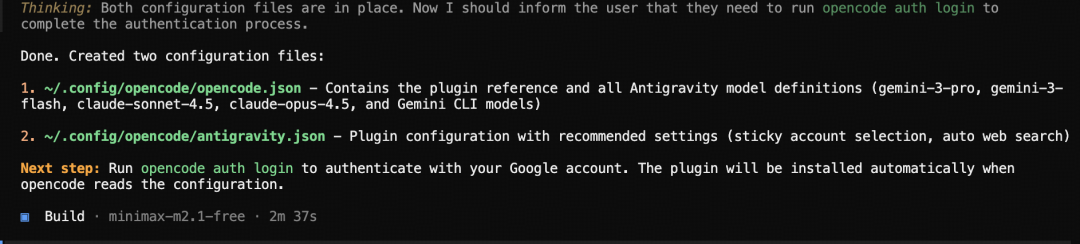

根据网络状况,这个过程通常需要 1-3 分钟。

你会看到终端输出逐步的安装进度。

第三步:模型供应商身份验证

安装完成后,新建一个命令行窗口,执行以下命令:

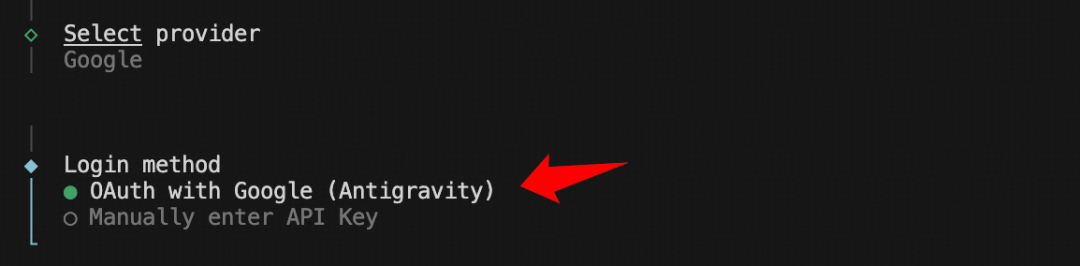

opencode auth login系统会提示你选择模型供应商。

你的选项通常包括:

- Google(Gemini)

- OpenAI(GPT)

- 其他供应商

选择 Google 并回车。

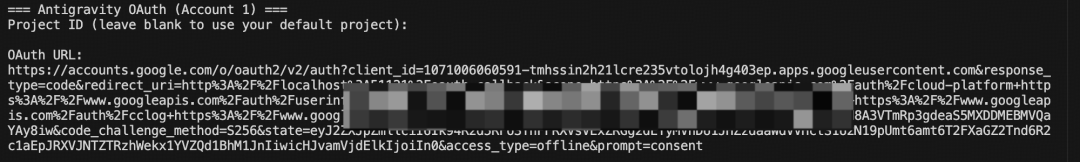

第四步:浏览器登录认证

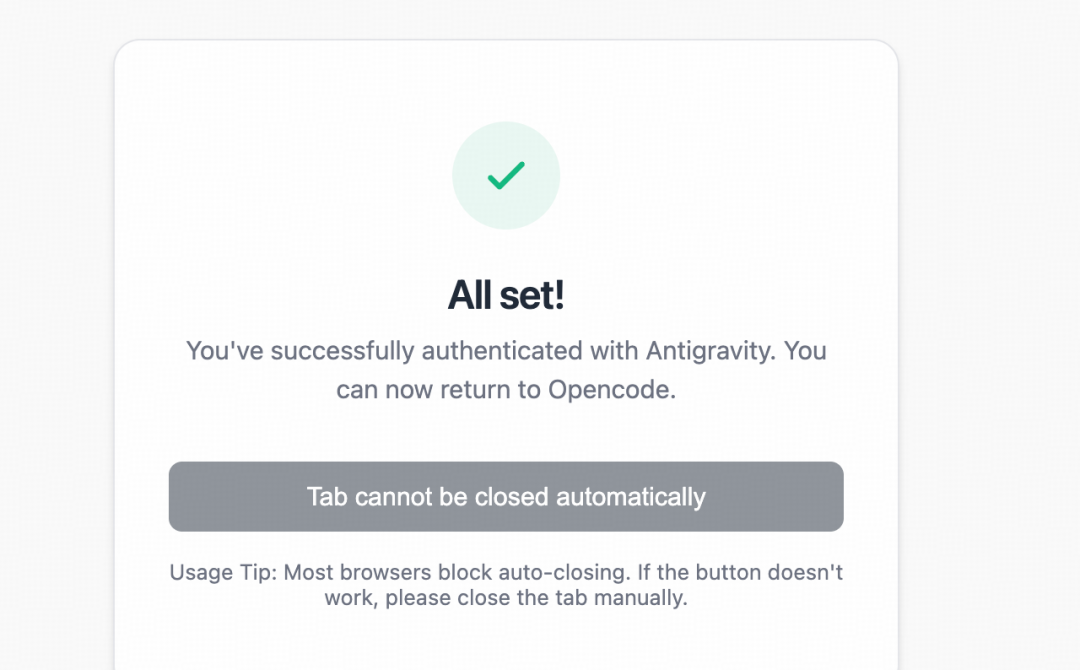

系统会自动打开浏览器窗口,引导你登录 Google 账号。

如果你之前登录过 Google IDE 工具:系统会自动使用已有的登录态,直接返回成功界面

如果这是首次登录:

如果你之前没登录过,打开浏览器之后登录一下谷歌账号,最后复制浏览器地址内容,到命令行粘贴。地址大概长这样

之后我们看到

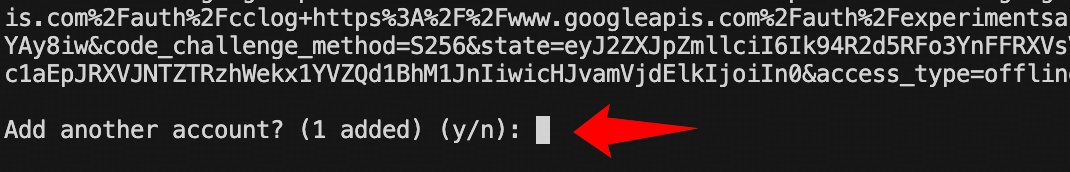

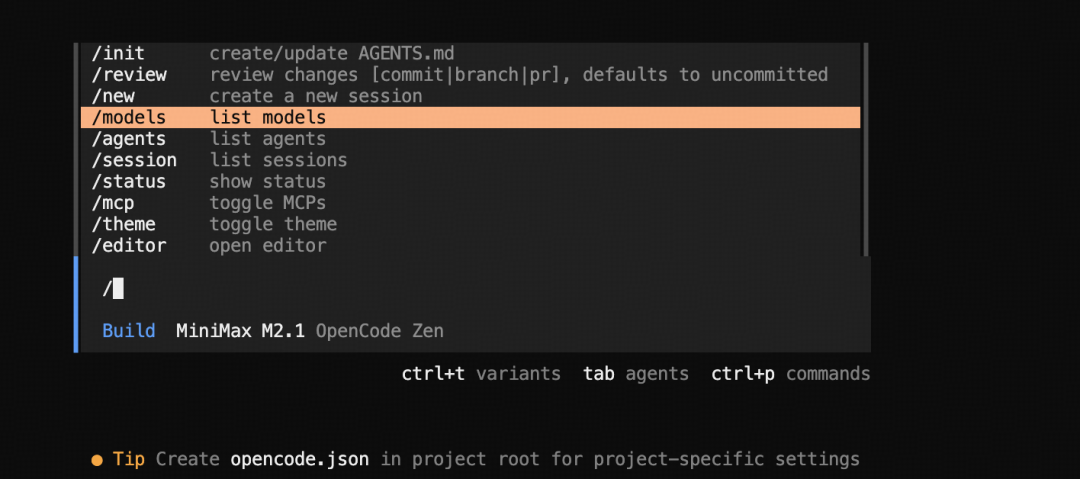

我们输入n,之后回车。之后我们就可以看到配置成功。

第五步:完成配置

当命令行提示"是否继续"时,输入 n 并回车。随后你会看到配置成功的确认信息。

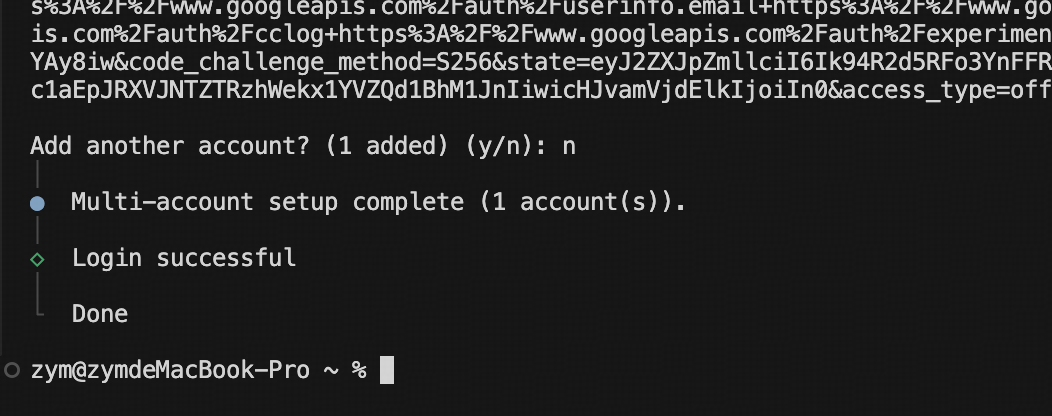

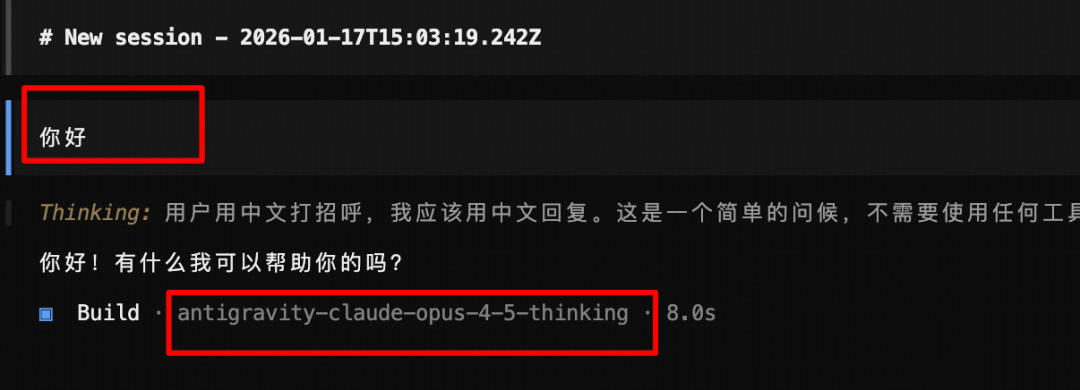

第六步:重启 OpenCode 并验证模型

重启 OpenCode 应用。在对话窗口输入命令:

/model

你应该能看到 Google 的所有可用模型已被成功接入列表中(包括 Gemini-Pro 等)。

随后输入一条测试消息进行验证,确认模型能够正常响应。

3. 接入 GPT Codex(可选)

如果你拥有 ChatGPT Plus 账号,可以通过类似流程将 GPT Codex 模型接入。

认证步骤与上述 Google 流程基本一致,仅供应商选择改为 OpenAI。

第二部分:核心命令与工作流

OpenCode 常用命令详解

| 命令 | 功能定位 | 使用场景 |

|---|---|---|

/session |

创建有状态的临时计算环境 | 保留对话上下文,进行连续的编程任务 |

/share session |

生成可公开访问的会话链接 | 分享完整的对话和开发过程给团队成员或获取代码审查 |

/model |

列表显示所有可用模型 | 选择特定模型或切换模型供应商 |

关于 /share session 的补充说明:

这个命令的本质是将你当前的整个对话过程(包括提示词、代码、执行结果)生成为一个静态网页链接。适用场景包括:

- 向团队展示你的开发思路和代码实现

- 请求技术支持时提供完整的问题复现过程

- 保存重要的编程会话作为文档记录

第三部分:Oh My OpenCode 插件

1. 插件核心定位

Oh My OpenCode 是一个功能集成插件,它将预设工具、MCP(Model Context Protocol)和多个专业智能体打包在一起。

这套组合让你在 AI 编程中获得更多的自动化能力和工具链支持。

插件地址:https://github.com/code-yeongyu/oh-my-opencode/tree/dev

具体教程:手把手教你快速入门OpenCode + GLM-4.7 + Oh-My-Opencode + Skills 安装配置与高效使用指南

2. 内置工具集详解

| 工具名称 | 核心功能 | 使用适用性 |

|---|---|---|

| LSP Advanced | 编程语言语法协调引擎,快速定位和理解代码结构 | 处理复杂代码库时的快速导航和理解 |

| AST | 基于抽象语法树进行代码关联搜索 | 精准查找相关代码片段和依赖关系 |

| Look_at | 支持多模态识别(图片、文件)的视觉分析 | 分析设计稿、截图、文档图像等视觉内容 |

| Websearch | 基于 Exa AI 的实时网络搜索能力 | 获取最新技术文档、API 资源、代码示例 |

| Context7 | 官方代码库文档和最新文档源搜索 | 快速查询框架、库的官方文档和最佳实践 |

| Grep_app | GitHub 代码块全局搜索 | 在开源项目中找到相关的代码实现参考 |

3. 多智能体架构

Oh My OpenCode 的最大差异化特征在于其多智能体协作架构。

插件内置了 7 个专业化的编程智能体,每个智能体都针对不同的编程场景进行了优化。

插件会根据你的任务类型,自动将其分配给最适合的智能体,并为每个智能体配置相应的大模型支持。

这意味着你不需要手动选择工具,系统会自动进行最优的资源分配。

4. 插件安装过程

第一步:获取安装链接

在 GitHub 仓库中找到插件的安装代码或链接,复制完整内容。

第二步:在 OpenCode 中执行安装

在 OpenCode 对话框中粘贴安装代码,系统开始自动安装流程。

第三步:交互式配置问卷

安装过程中,系统会询问你是否拥有特定模型的订阅(如 GPT-4、Claude Pro 等)。根据你的实际情况选择 Yes 或 No 即可。这个步骤的目的是让插件智能体根据你的可用资源进行模型配置。

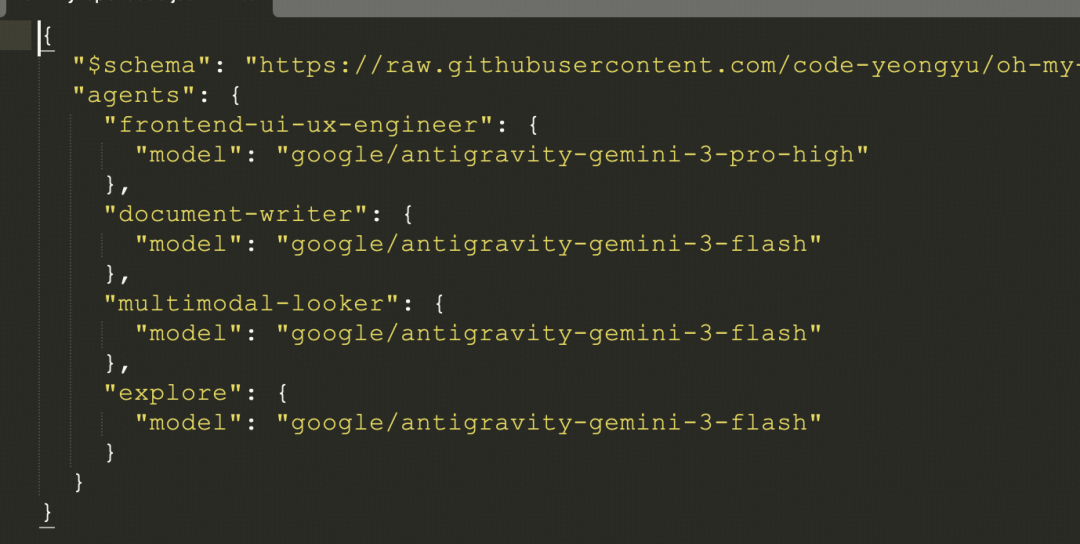

第四步:配置文件验证

安装完成后,打开 OpenCode 的配置目录,你可以看到生成的配置文件。这些文件记录了每个智能体被分配的具体模型。例如,一个智能体可能被配置为使用 Claude-3.5,另一个可能是 Gemini-Pro。

第五步:重启并激活

重启 OpenCode。插件会自动加载配置,你会看到系统状态更新为正常运行。此时,所有 7 个编程智能体都已可用。

第四部分:Ultrawork 魔法提示词

1. Ultrawork 的作用机制

Ultrawork 是一个特殊的提示词前缀,用途是激活整个智能体调度系统。

当你在任何提示中包含这个关键词后,系统会由主智能体统一协调,自动为你的任务分配最合适的子智能体并并行执行。

你可以使用完整词 ultrawork 或其简写 ulw。

2. 实际应用案例

场景:快速开发一个网站原型

第一步:输入需求

在 OpenCode 对话框中输入:

ultrawork: 帮我创建一个电商产品展示网站,包含商品列表、购物车和支付流程第二步:观察智能体调度过程

系统会立即启动多个智能体的并行工作。

你会看到主智能体开始向你提问:

- 网站的技术栈偏好(React、Vue 还是原生 HTML)

- 数据来源(静态数据还是 API 接口)

- 设计风格和色彩方案

- 其他功能需求

简要回答这些问题即可。

第三步:自动开发阶段

主智能体完成需求确认后,会自动分配具体的开发任务:

- 智能体 A 负责前端架构设计

- 智能体 B 负责 UI 组件开发

- 智能体 C 负责业务逻辑和数据流

- 其他智能体负责测试、文档等

这些任务会并行执行,大幅加速开发周期。

第四步:验证和交付

整个项目开发完成后,你可以直接运行生成的代码,检查最终效果。

通常情况下,你会获得一个可直接部署的完整项目。

总结

OpenCode + Oh My OpenCode 这套组合有几个明显的设计特点:

1. 降低技术门槛的同时保留专业控制

通过 Ultrawork 这样的魔法词,即使不熟悉编程的产品经理也能快速生成原型。但同时,如果你需要精细控制,也可以直接与特定智能体交互。这种双层设计很有意思。

2. 多模型接入的成本优化

支持免费接入 Gemini 和 Claude,意味着即便没有 GPT-4 订阅,你也能获得企业级 AI 能力。

这对初创团队或个人开发者特别友好。

3. 多智能体架构的自动分工逻辑

不同的编程智能体针对不同场景优化,系统自动分配而不是要求用户手动选择。

这反映了对用户认知负担的考虑——用户只需描述需求,系统负责工程化的分工。

4. 共享和协作的设计考量

/share session 命令让开发过程变成可传播的内容,这对团队协作和知识沉淀有帮助。

总的来说,这套工具组合正在重新定义"低代码/无代码"的含义——不是简单地拖拽和配置,而是通过自然语言和智能体协作,让非专业开发者也能快速完成复杂的开发任务。

如果你也在探索 AI 工具提升工作效率,我建议从配置基础模型开始(跟随第一部分的步骤),然后逐步引入 Oh My OpenCode 来扩展能力。

整个过程的学习成本不高,但收益会相当可观。