LlamaIndex。如果你也在尝试把 ChatGPT 或 Claude 接入自己的业务数据,可能已经踩过不少坑:

-

ChatGPT 再聪明,它也不了解你公司内部的数据库、Notion 笔记、PDF 文档。

-

自己搭一个 RAG 系统(检索增强生成)要写一堆复杂逻辑:文档切分、向量化、存储、检索、答案拼接……工程量巨大。

-

不同开发者需求差异很大:有人只想 5 行代码跑个 Demo,有人需要高度定制,还要兼容不同 LLM(OpenAI、本地 Llama2 等)。

而 LlamaIndex 的出现,正是把这些“脏活累活”都封装好,让你能更专注在业务逻辑和产品价值上。

项目介绍

LlamaIndex 是一个 开源 RAG 框架,用来帮开发者快速把各种私有数据(文档、数据库、API 等)转化为 LLM 可用的知识库。它既能开箱即用,也能深入定制,覆盖从个人玩具项目到企业级应用的全链路需求。

一句话总结:它是 LLM 与私有数据之间的最佳中间层。

功能亮点

-

数据接入能力 内置 300+ 连接器,几乎你能想到的都支持:PDF、Excel、Notion、Slack、SQL、GraphQL、Google Drive……

-

多种索引策略 不仅是向量索引,还支持关键词、知识图谱、分层摘要,甚至混合检索。

-

一行代码搞定接口层

index.as_query_engine()就能生成一个问答引擎,index.as_chat_engine()就能变成对话助手。 -

插件生态 LlamaHub 社区里已有 300+ 插件,涵盖 OpenAI、HuggingFace、Chroma、Milvus、LLaMA-CPP 等。

-

企业级服务 通过 LlamaCloud,你可以托管解析、索引和检索,用一条命令上线生产环境。

-

多语言支持 提供 Python 和 TypeScript 两个版本,API 设计保持一致。

技术细节

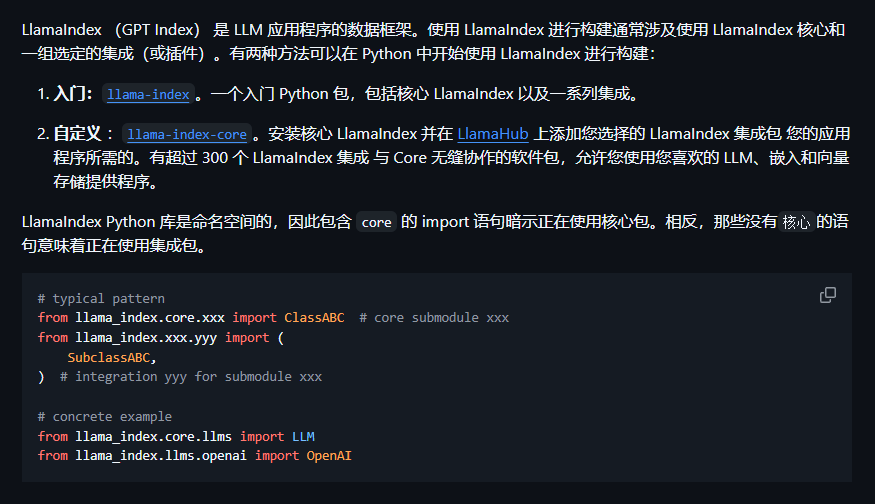

LlamaIndex 的设计思路是模块化、可替换。

模块化架构

-

llama-index-core:最小内核 -

llama-index-xxx:按需安装的扩展包,避免“全家桶”臃肿 -

统一入口,保证开发体验一致

典型数据流

文档 → Data Connector → Node Parser → Index → Retriever → Synthesizer → 答案

每一步都可以替换,比如你可以用本地 Embedding 模型、不同的向量数据库、甚至自定义重排序器。

可观测性 原生对接 Trulens、LangSmith、Arize 等监控工具,一键跟踪检索命中率和答案忠实度。

部署与使用

最吸引我的一点:LlamaIndex 的上手门槛极低,真的可以 5 行代码就跑起来。

1. 极速体验(5 行代码)

pip install llama-index

export OPENAI_API_KEY=sk-xxx

from llama_index.core import VectorStoreIndex, SimpleDirectoryReader

documents = SimpleDirectoryReader("data").load_data()

index = VectorStoreIndex.from_documents(documents)

query_engine = index.as_query_engine()

print(query_engine.query("请总结这份合同的关键条款"))

2. 自定义 LLM & Embedding(本地 Llama2)

pip install llama-index-core llama-index-llms-replicate llama-index-embeddings-huggingface

from llama_index.core import Settings

from llama_index.llms.replicate import Replicate

from llama_index.embeddings.huggingface import HuggingFaceEmbedding

Settings.llm = Replicate(model="meta/llama-2-7b-chat:...")

Settings.embed_model = HuggingFaceEmbedding(model_name="BAAI/bge-small-en-v1.5")

3. 生产持久化

# 保存

index.storage_context.persist(persist_dir="./storage")

# 重启后加载

from llama_index.core import load_index_from_storage, StorageContext

index = load_index_from_storage(StorageContext.from_defaults(persist_dir="./storage"))

使用场景

-

Notion 问答机器人:同步团队笔记,5 分钟内搭建内部知识助手

-

金融研报分析:如 SEC Insights,用 LlamaIndex 自动解析 10-K/10-Q 文件,生成投资要点

-

客服工单助手:结合 SQL 连接器,让 LLM 回答「订单为什么延迟」

-

多模态 Agent:统一接入 PDF 图表、产品图片,支持跨文本与图像分析

适合谁

-

个人开发者:想要快速跑通 RAG Demo,不想自己造轮子。

-

创业团队:需要在私有数据上做 MVP,快速验证产品可行性。

-

企业:追求稳定可扩展的生产级方案,可以用 LlamaCloud 落地。

总结

从产品经理视角看,LlamaIndex 的价值在于:把复杂的 RAG 技术栈抽象成了“即插即用”的工具层。

它既能让新手 5 行代码跑个 Demo,也能让高级用户自由定制每个环节;既能本地轻量部署,也能接入云端企业级服务。

我个人觉得它更像是「AI 时代的数据中间件」,帮我们把零散的私有数据统一封装成 LLM 能理解的知识大脑。

如果你正在思考如何把 ChatGPT、Claude 等大模型真正用到自己业务里,LlamaIndex 是一个绕不过去的起点。

项目地址: