都是大厂,放心用,不用担心效果!

-

即梦AI(字节跳动)

-

星流Star-3(LibLib)

-

Qwen-Image(魔搭社区)

测试代码也给大家打包了,可以直接上手测试!

即梦Ai

这个就不要多说了,字节跳动旗下的即梦Ai和豆包的生图都是一个大模型出来的,如果要使用就要统一去火山引擎申请API,现在文生图API产品已经支持到3.1了(不了解的可以直接去即梦Ai测试),还支持图生图。

目前测试API除了有并发限制,测试是1个,其他没什么限制,挺好用的!

申请流程

需要先注册火山引擎账号并完成个人/企业认证

直接去开通「即梦AI」的产品服务,注册认证完可以直接通过下面链接跳转

自己测试是没有限制的,如果正式调用就要按量付费

接下来就要去申请API key,这个是通用的,只要服务开通了KEY是能通用

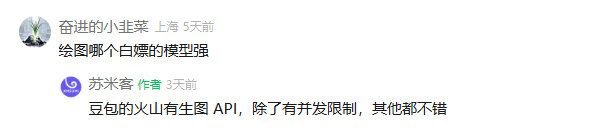

如果想要全站通用,就直接在这里申请,点「用户头像」-「API访问密钥」-「新建密钥」就搞定了

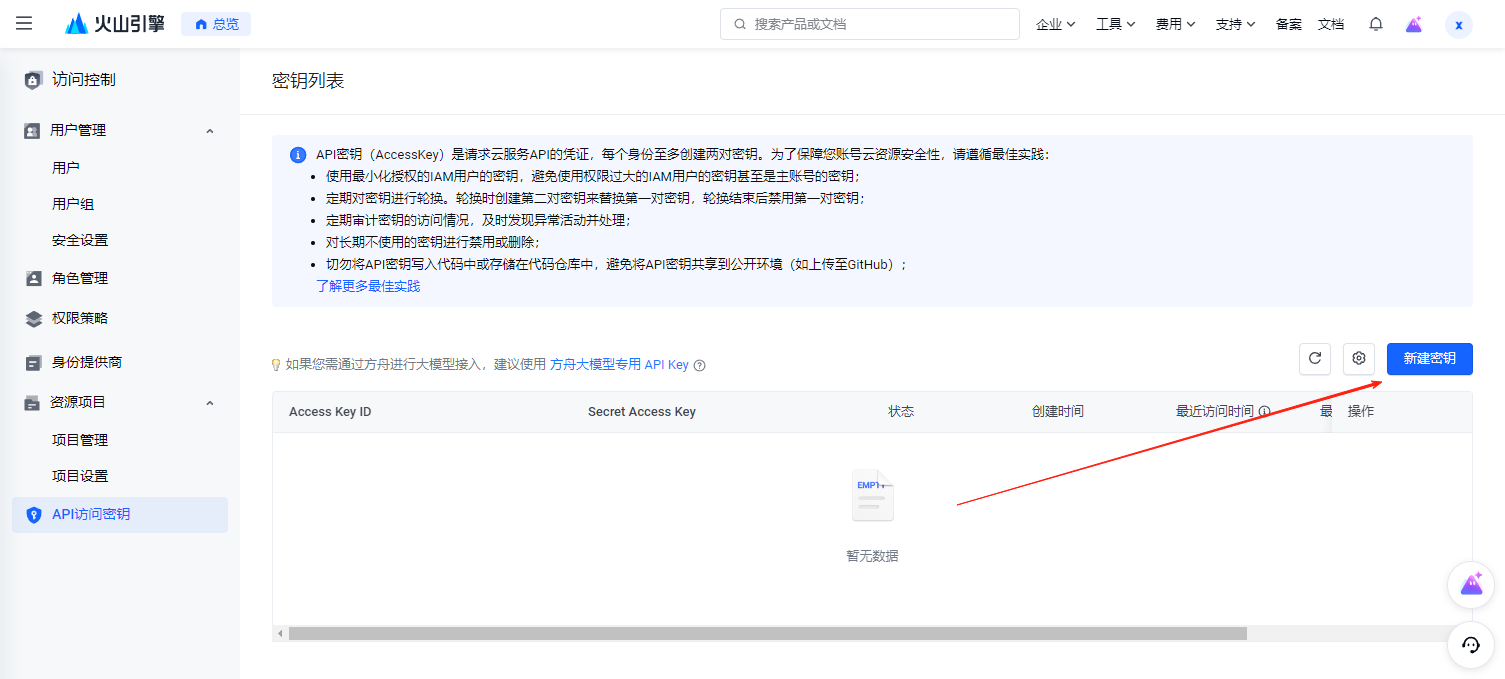

但官方还推荐了一个子账户的方法,便于权限管理,我用的是这个方法(觉得麻烦可以跳过)

通过新建「用户」-给用户添加相应的「权限」,最后「新建密钥」,这样可以控制使用范围

接下来根据即梦文生图3.1-接口文档进行测试

使用教程

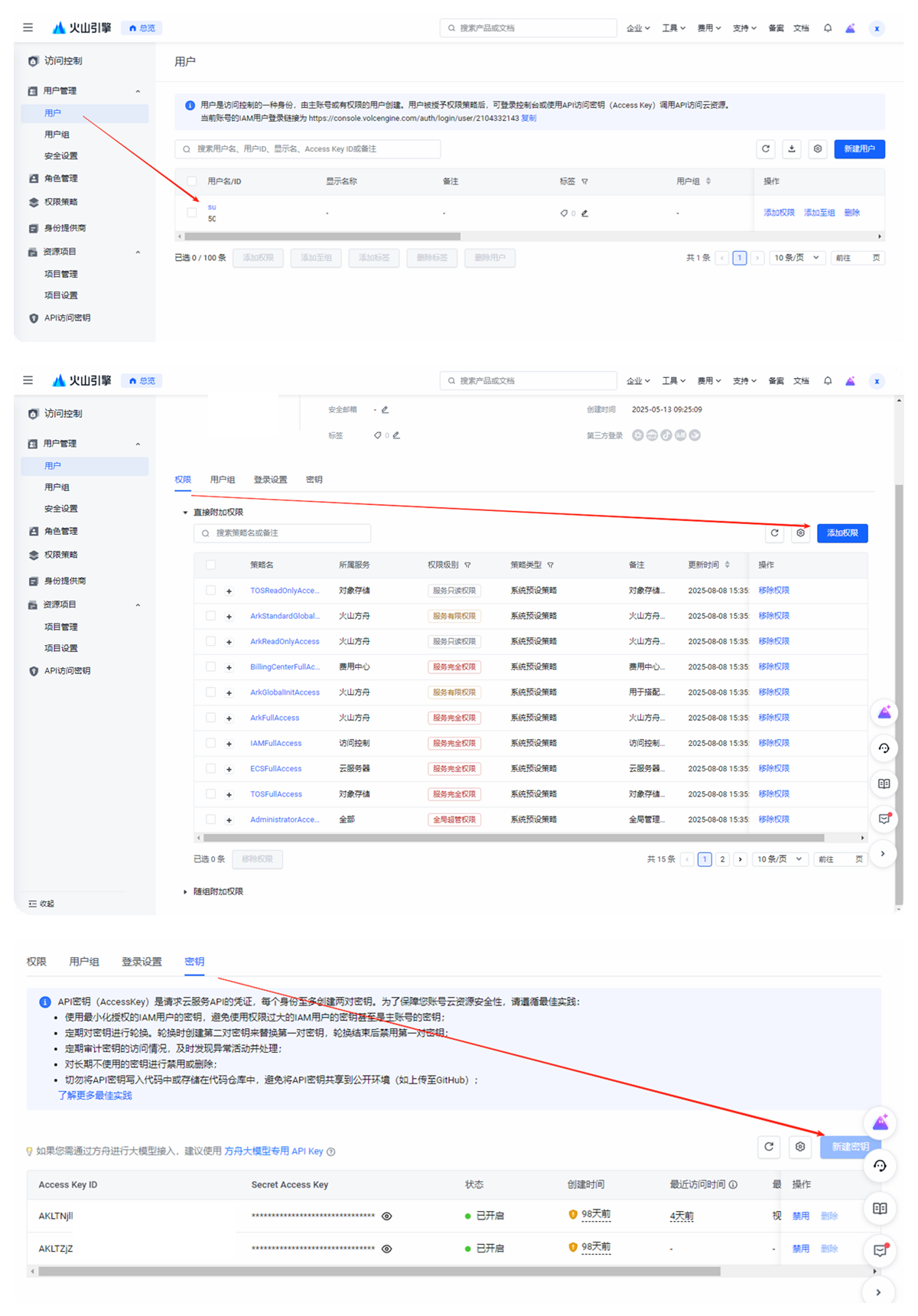

如果看不懂没关系,跟着我的步骤操作,我已经打包好了官方的python接口包在文章最后,也可以自己去git下。

解压出来,使用pip安装SDK for Python:

pip install --user volcengine

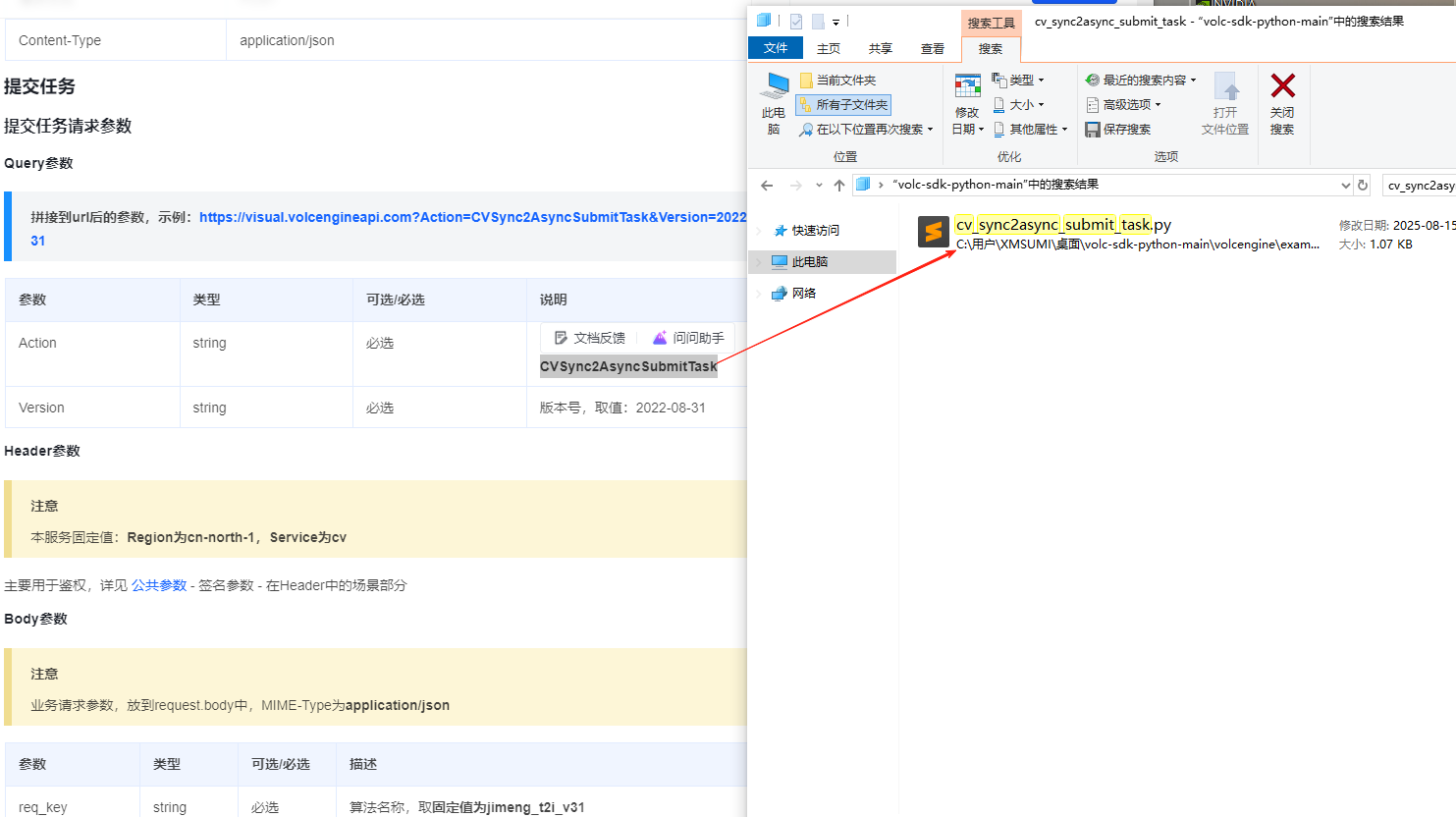

接下来是重点文档中的接口名是:CVSync2AsyncSubmitTask所以需要在接口包里搜索cv_sync2async_submit_task这个接口

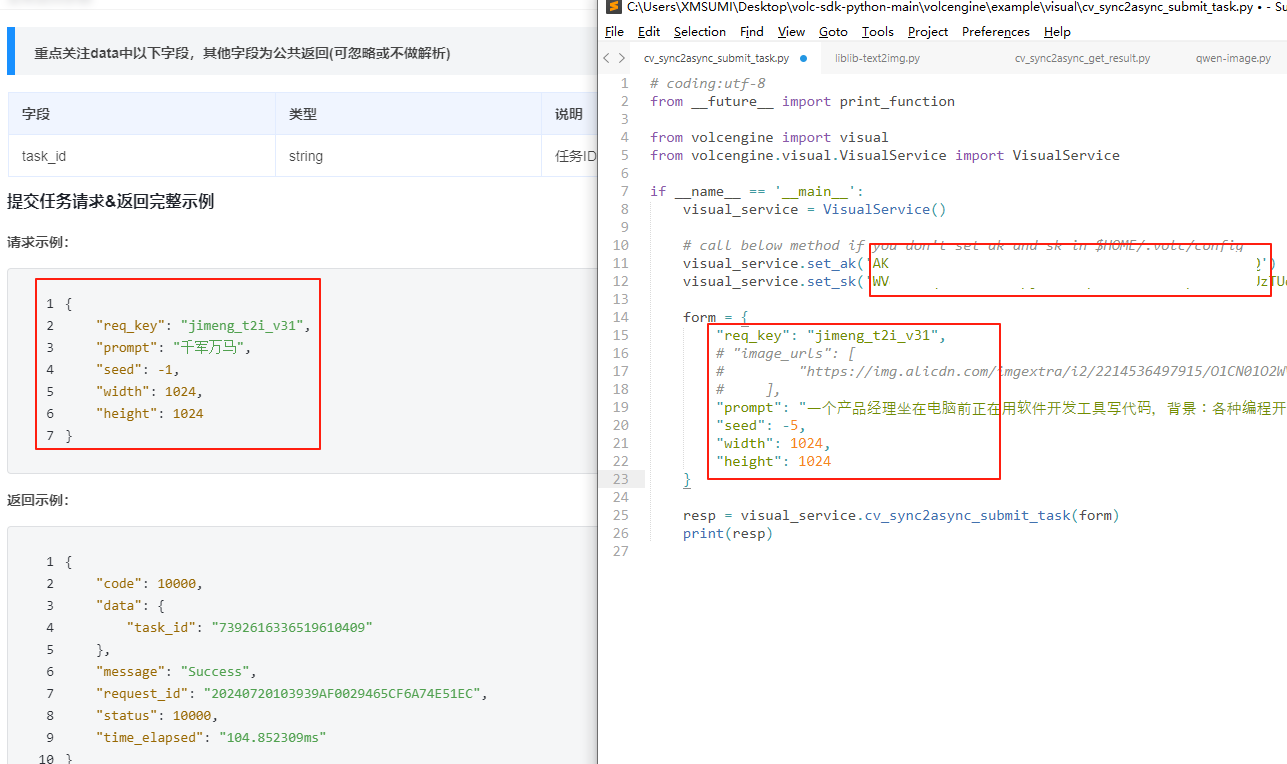

并且把文档中对应的请求,别忘了还有申请的KEY

最后测试一下返回(这里需要注意,返回的task_id要记下来):

刚才的接口是生成图片任务的发送,但不会直接返回图片,所以需要另外一个接口来返回图片

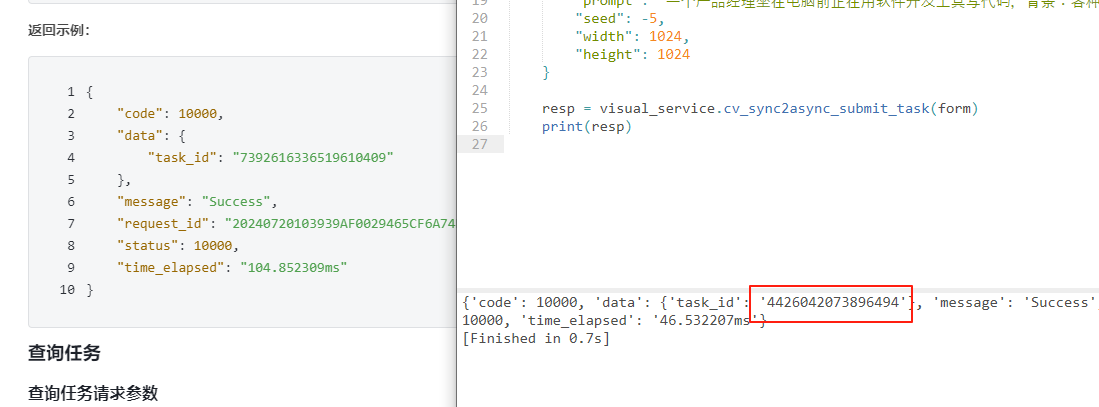

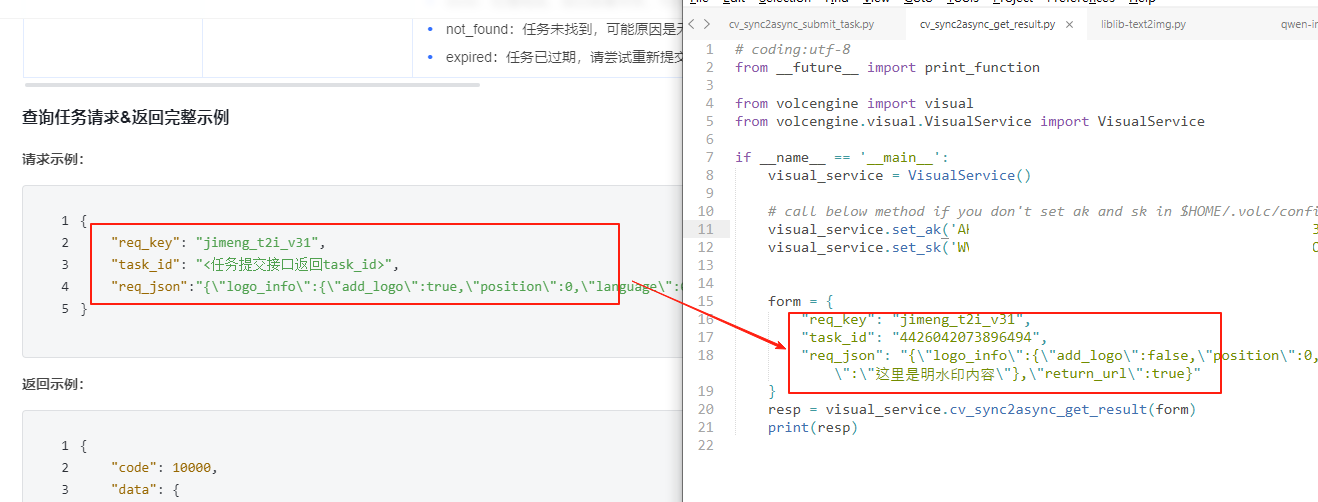

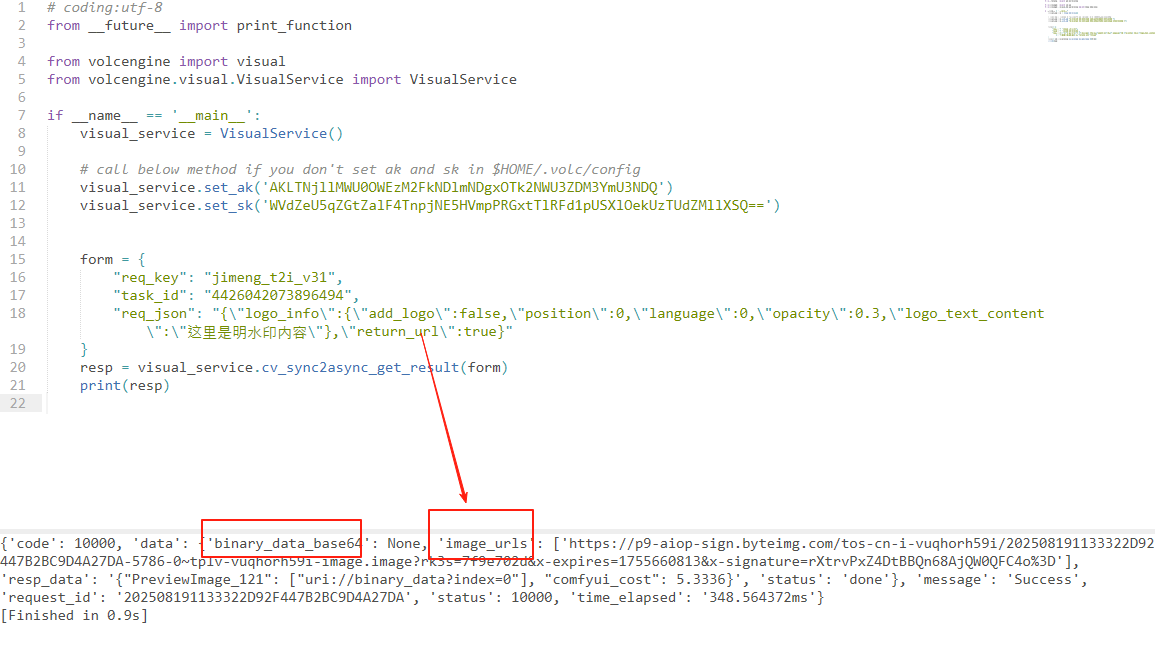

查询任务的接口CVSync2AsyncGetResult在接口包里搜索cv_sync2async_get_result这个接口,完善对应信息并填入task_id:

然后测试一下返回的结果(这里会默认返回base64和url两种,我开启了url所以直接是一个URL)

浏览器打开看看

到这里就搞定了!

星流Star-3

星流是LiblibAI推出的图像大模型API,现在有是有免费计划,注册就送7天免费试用500积分,测试够用了。正式使用的话是¥10/1000积分。支持星流Star-3 Alpha文生图和图生图。

申请流程

直接注册登录就可以了,如果要注册可用一下我的邀请链接哈!

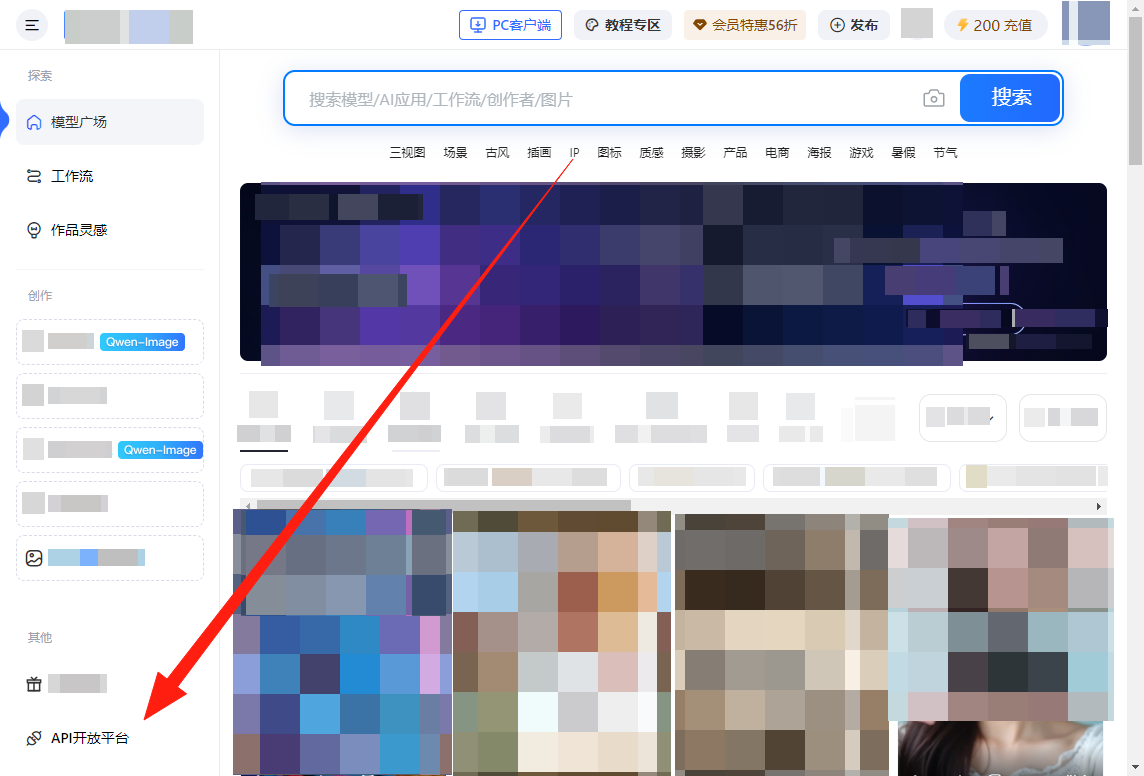

登录成功后直接进API开放平台

看到「AccessKey」和「SecretKey」直接复制备用

使用教程

有官方的文档使用方法比较复杂,要生成签名什么的一大堆,我直接用AI生成了一个测试的python接口包放在文章最后

官方文档:https://liblibai.feishu.cn/wiki/UAMVw67NcifQHukf8fpccgS5n6d

文生图和图生图是两个接口,所以我分别写了两个,直接填「AccessKey」和「SecretKey」的提示词就可以测试了

生成之后的图片效果

还有图生图的,直接测试

看看效果,不知道是不是识别出来的图不对,虽然转换出来了,但图变了

Qwen-Image

最近魔搭社区刚刚上线了Qwen-Image文生图和图生图的模型

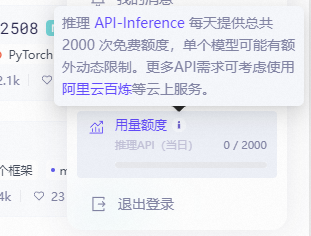

同时现在每天直接白送你 2,000 次免费调用额度,不仅可以用 Qwen3-Code,Qwen-Image也同样可以调用,你说这么个大厂的限量白嫖你不用,你还去花那钱干嘛~

申请流程

直接在魔塔社区注册账号,应该是需要绑定阿里云账号的,因为我之前用Qwen3-Code已经绑过了,所以就没有提示

魔塔社区地址:https://modelscope.cn/home

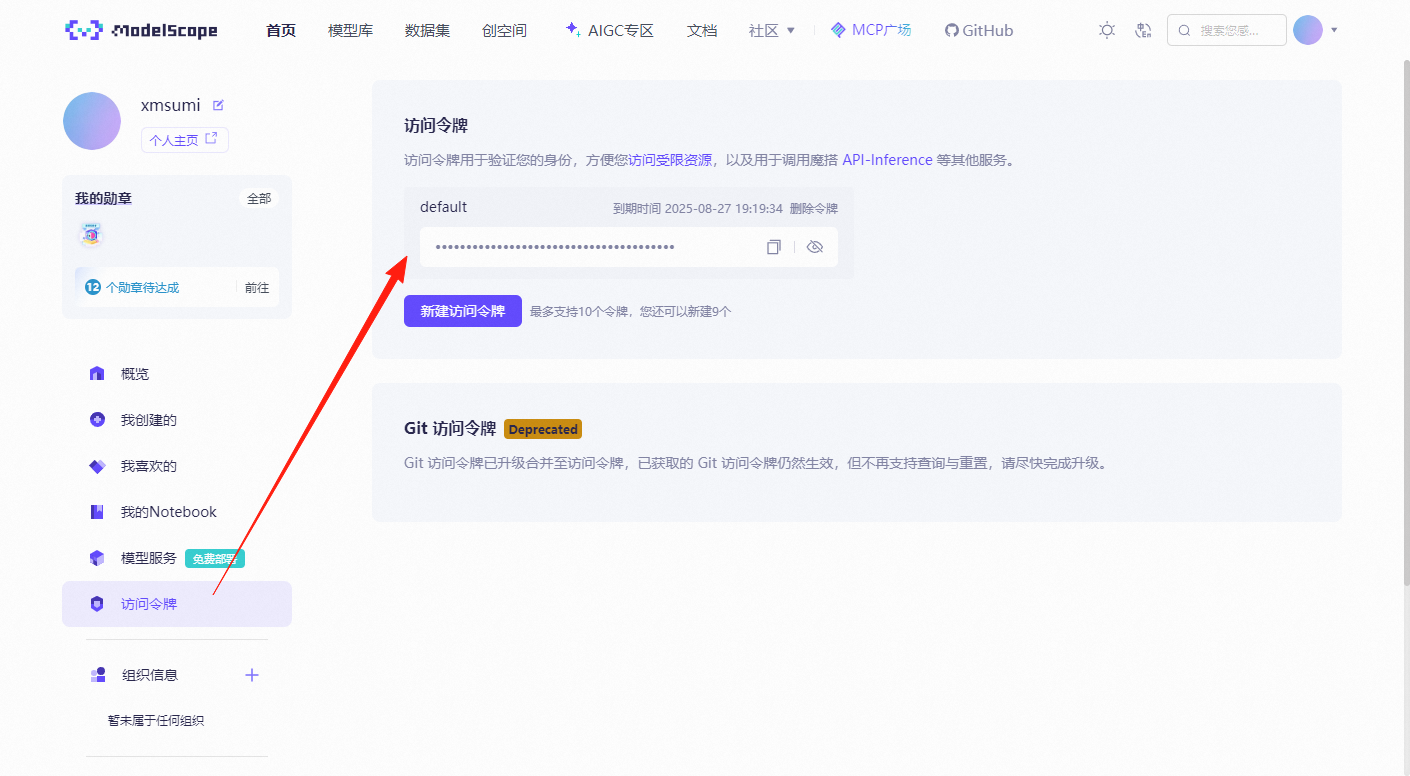

登录后直接在「账号设置」-「访问令牌」-「新建令牌」,复制就可以了

使用教程

官方直接有模型的示例,直接拿来用就可以了,找到模型,点击「查看代码范例」

把python代码复制出来(只有Python),勾选「使用我的Token」可以直接用,或者官方也有「Notebook」测试

我放在本地跑一下看看

是直接生成在运行程序的目录下的图片,打开看看

官方还有最新的图生图,也是刚刚更新的,可以自行去测试

总结

这三个生图的API是目前国内市面上比较主流大模型了,如果喜欢即梦的话可以尝试它最新的3.1,文字效果一流,社区生态的话星流Star-3和Qwen-Image都不错,不过是有额度限制,对于想要测试的话是没什么问题的,如果正式项目建议还是要充钱使用了。

但总体来说上手还是比较简单的,整个教程比较适合新手,如果你有测试成功,欢迎评论区留言分享!

关注「苏米客」公众号关键词回复「ai生图」获取源码SDK