最近在体验Claude Cowork后,我开始思考一个问题:为什么功能完整的AI协作工具,必须与高订阅费用和云端依赖绑定?

直到我发现了GitHub上的Accomplish项目,这个由开发者在2天内完成的开源方案,打破了我的这个疑问。目前已获得3.3K标星,更重要的是,它在多个维度上超越了商业对标产品。

项目概览

Accomplish是一个开源的本地AI协作工作台,采用MIT协议,支持macOS和Windows 11平台。

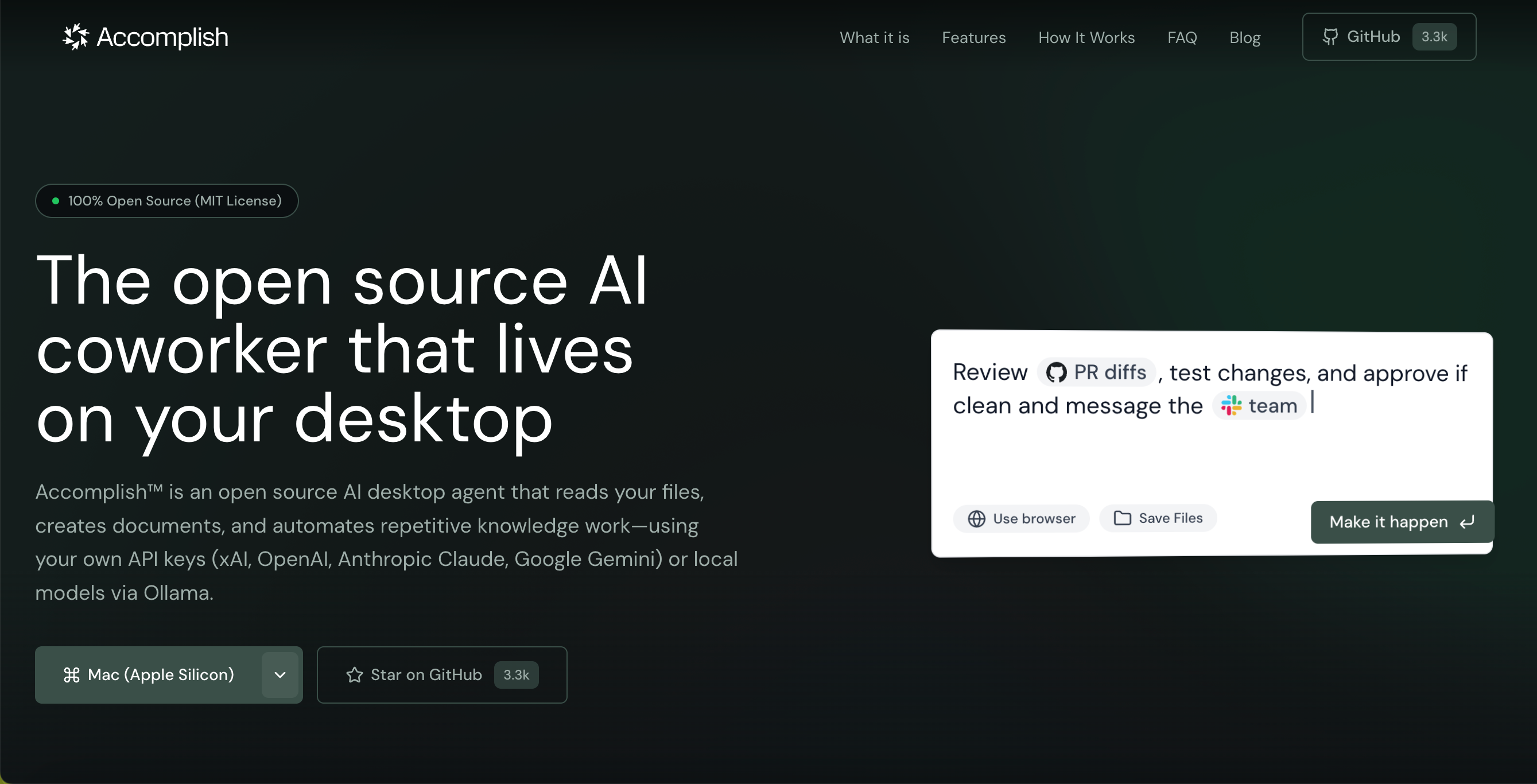

项目的核心定位是:将AI代理能力下沉到本地,让用户拥有完全的数据控制权和模型选择权。

| 维度 | Accomplish | Claude Cowork |

|---|---|---|

| 部署方式 | 本地运行 | 云端服务 |

| 数据隐私 | 本地存储,仅API调用上传必要数据 | 云端存储 |

| 模型支持 | 12+种(Claude、GPT、Gemini、DeepSeek等)+ 本地模型 | Claude专属 |

| 使用成本 | 开源免费 + 按需付费API | $100/月订阅制 |

| 离线能力 | 支持(Ollama/LM Studio) | 不支持 |

核心功能特性

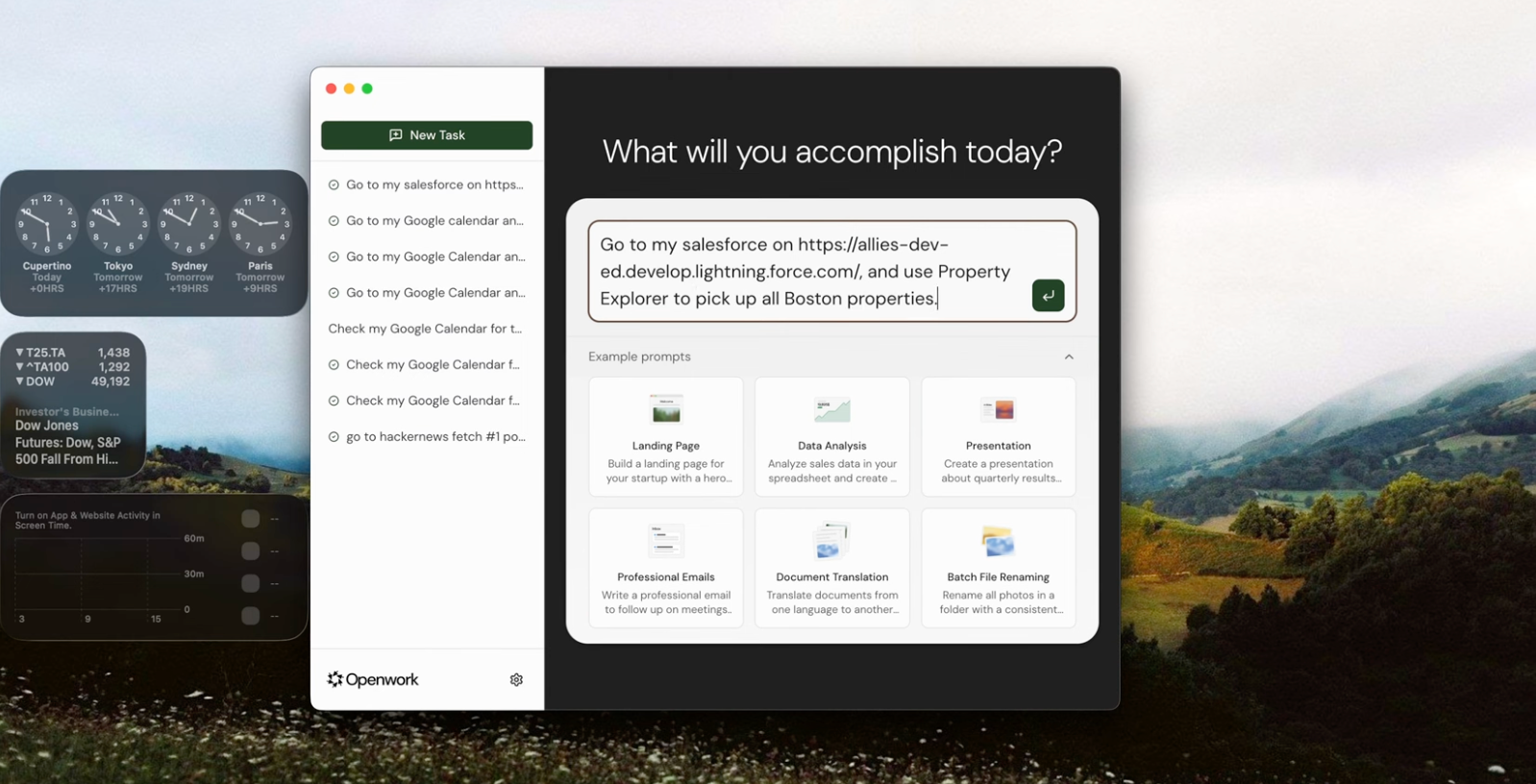

1. 文件与项目管理

- 本地文件系统的浏览、修改和组织

- 完整的代码库索引和理解能力

- 项目级上下文自动构建

2. 文档生成与维护

- AI直接生成项目文档

- 技术文档自动化维护

- 支持多格式输出

3. 浏览器自动化

- 网页内容自动抓取与分析

- 跨网页任务自动执行

- 信息采集流程化处理

关键差异:为什么超越对标产品

隐私优先的本地架构

Accomplish的设计哲学直指当前云端AI工具的核心痛点:

- 全流程本地处理:文件索引、代码分析、文档生成全部在本地完成,不涉及文件系统的云端传输

- 最小化数据上行:仅在调用LLM API时,传输必要的查询和指令,而非原始文件内容

- 零供应商锁定:用户数据对任何云服务厂商都不可见

这对处理敏感代码、商业文档或个人数据的用户而言,具有实际意义。

模型选择的完全自由

支持的LLM生态包括:

- 商业模型:Claude、GPT-4、Gemini、DeepSeek、Moonshot(Kimi)、Grok等

- 本地开源模型:通过Ollama或LM Studio集成Llama 3、DeepSeek-V3、Kimi K2.5等

- 企业方案:Amazon Bedrock、Azure OpenAI Service

用户可以根据成本、隐私、性能需求,灵活切换模型组合,而非被单一厂商绑定。有GPU资源的开发者,甚至可以实现完全离线运行。

安装与配置

快速开始

- macOS / Windows 11:直接下载预编译版本,开箱即用

- 开发者:克隆仓库,支持二次开发和功能扩展

配置管理

用户需配置:

- LLM API密钥(Claude、OpenAI、Google等任选其一或多个)

- 本地模型引擎(可选,需GPU资源)

- 工作目录权限

配置过程围绕简化原则设计,文档完整,上手难度低。

应用场景

- 独立开发者:代码审查、文档自动化、跨项目重构

- 数据敏感团队:保持代码库离线,仅利用AI能力进行分析

- 成本约束场景:按量付费替代高额订阅,或完全离线运行

- 模型实验:快速切换不同LLM,对比效果

- 知识工作者:文档管理、信息采集、自动化流程处理

相关项目推荐

如果你对本地AI协作工具感兴趣,还可关注:

- Aider:CLI导向的代码编辑协作工具

- Continue:IDE集成的代码补全框架

- OpenInterpreter:多模态代码执行引擎

总结

Accomplish的意义不仅在于功能完整性,更在于它呈现了一条与当前商业AI工具相异的路径:

- 隐私优先,而非便利优先

- 开放选择,而非厂商锁定

- 按需投入,而非订阅绑定

这反映了开源社区正在回应的一个问题:AI工具为什么必须以云端、订阅、单一模型的形式存在?

如果你对数据隐私有诉求,或希望在AI选型上保持灵活性,Accomplish是一个值得体验的方案。它也证明了,好的工具设计,往往源于对用户真实需求的理解——而非对商业模式的强硬追求。

声明:本站原创文章文字版权归本站所有,转载务必注明作者和出处;本站转载文章仅仅代表原作者观点,不代表本站立场,图文版权归原作者所有。如有侵权,请联系我们删除。