N8N、Coze、Dify 到 LangFlow,这类工具正在成为独立开发者和企业团队快速构建 AI 应用的常用方式。

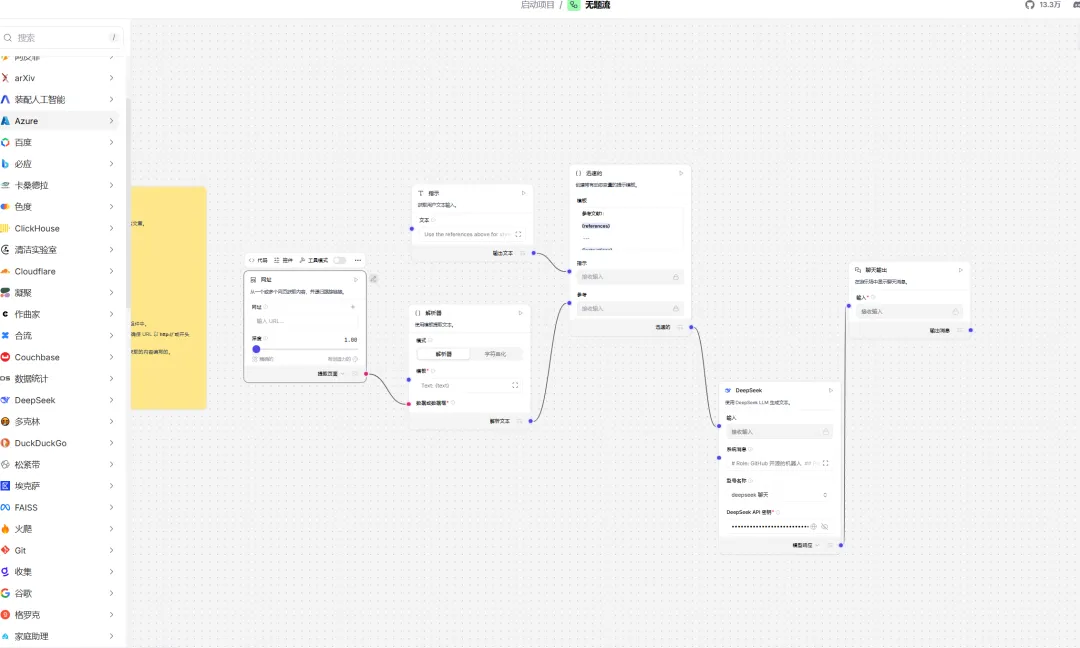

相比于以往需要手写大量 LangChain 代码的方式,LangFlow 以可视化工作流的形式让开发者几乎可以“拖拽式”完成一个 AI 系统的搭建。

出于好奇,我用 AI 编程工具在本地安装了 LangFlow,体验了它的完整工作流创建与部署过程。下面我将从产品角度拆解它的核心能力、使用场景、部署方式以及适合的用户类型。

LangFlow 是什么?

LangFlow 是一个基于 Python 的开源框架,用于快速构建基于大语言模型(LLM)的 AI 应用。

它的核心定位是:让开发者能够通过「可视化编排」方式构建、测试、部署完整的 AI 工作流,而无需绑定特定模型或数据库。

这意味着你既可以使用 OpenAI、Claude、DeepSeek,也可以接入自定义模型和私有向量数据库,极大提升了灵活性。

项目地址:https://github.com/langflow-ai/langflow

技术栈:Python 3.10+

目标用户:AI 开发者、数据工程师、原型设计者、智能体系统构建者

核心功能亮点

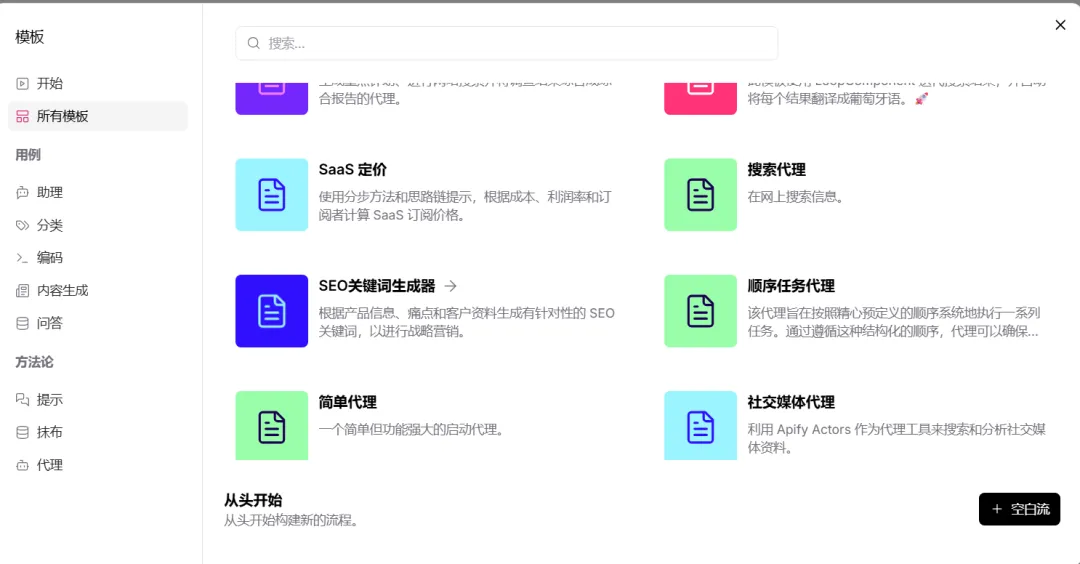

1. 可视化工作流构建

LangFlow 提供了直观的拖拽式界面,每个组件对应工作流中的一个步骤。 开发者可以像搭积木一样快速创建一个 LLM 应用,从输入处理、模型调用到输出展示,一气呵成。

示例:我使用 LangFlow 构建了一个“电商客服聊天机器人”,整合了产品数据库 + LLM,仅用了半小时。

2. 实时测试与调试

LangFlow 内置了 Playground 测试面板,可在不部署完整系统的情况下直接运行工作流。

开发者可以逐步运行每个节点,查看数据流与模型响应,极大地降低了调试难度。

3. 灵活的部署选项

LangFlow 构建的工作流既可作为原型快速验证,也可通过 LangFlow API 嵌入现有项目。

对于企业级使用,还可以:

-

将 LangFlow 作为依赖项集成进主系统;

-

启动 LangFlow 服务器,通过 REST 接口远程调用;

-

或以 MCP(Model Context Protocol) 服务器形式提供智能体服务。

4. 扩展与自定义能力

LangFlow 支持开发者创建自定义组件(Custom Nodes),并提供社区组件库。

这意味着你可以封装自己的模型调用逻辑或数据管道,并分享给他人使用。

生态开放性是它与传统 LangChain 脚本开发的最大区别之一。

应用场景

| 场景类型 | 应用说明 |

|---|---|

| 智能客服系统 | 连接数据库与LLM,构建问答机器人或客户支持流程 |

| 文档处理与分析 | 创建多步骤文档分析与摘要管线 |

| 内容生成平台 | 组合多模型生成、校对、优化模块 |

| AI 智能体(Agent)系统 | 借助 MCP 构建具备工具调用能力的复杂代理系统 |

LangFlow 的可组合性让它在快速原型设计、AI 产品验证阶段表现出色。

安装与部署方式

本地安装(推荐)

LangFlow 对 Python 环境要求较新(3.10–3.13),推荐使用 uv 包管理器。

uv pip install langflow -U

uv run langflow run

启动后访问:http://127.0.0.1:7860

Docker 部署

适合希望在团队或生产环境中使用的场景。

快速启动:

docker run -p 7860:7860 langflowai/langflow:latest

使用 Docker Compose(含 PostgreSQL 持久化存储):

git clone https://github.com/langflow-ai/langflow.git

cd langflow/docker_example

docker compose up

如需自定义数据库、配置环境变量或持久化数据,可通过 .env 文件管理连接参数。

自定义镜像与扩展

LangFlow 允许你通过 Dockerfile 定制版本,常见需求包括:

-

添加自定义 Python 依赖;

-

修改组件逻辑;

-

打包特定 Flow 并生成可分发镜像;

-

集成企业内部工具接口。

这种可扩展性使 LangFlow 既能做实验性原型,也能支撑复杂生产应用。

使用体验与限制

在功能层面,LangFlow 的确降低了 LangChain 复杂度。

但在体验过程中,也有一些现实问题需要注意:

| 体验维度 | 优点 | 限制 |

|---|---|---|

| 安装上手 | 过程简洁,本地运行快速 | 国内环境部分依赖源访问较慢 |

| 工作流编辑 | 可视化界面友好,逻辑直观 | 复杂流程易出现连线混乱 |

| 模型兼容 | 支持多种LLM接口 | 国内仅DeepSeek接口连接稳定 |

| 调试与测试 | 可单步运行、实时测试 | 复杂场景需自定义节点配合脚本 |

从使用角度看,它非常适合快速验证与教学场景,但在企业级或复杂工作流中仍需更多工程化手段来补充。

相似项目

| 项目名称 | 特点 | 适合场景 |

|---|---|---|

| Dify | 支持知识库、API 调用与多模态输入,界面完善 | 企业内部知识问答、应用生成 |

| N8N | 强大的自动化和插件生态 | 通用自动化流程、集成外部服务 |

| FlowiseAI | 轻量可视化LangChain工作流工具 | 快速原型、AI助手 |

| LangFlow | 官方LangChain可视化实现,支持MCP | LangChain开发者与智能体原型设计 |

总结

从产品经理视角来看,LangFlow 的核心价值在于 “降低 AI 应用的可视化构建门槛”。

它让团队中非后端成员也能快速参与工作流设计,特别适合:

-

想验证 AI 应用原型的创业团队

-

需要低门槛教学或展示 LLM 工作机制的场景

-

希望构建自定义 Agent 的开发者

当然,当前版本仍存在网络连接、依赖超时、复杂流程可视化拥挤等问题。

但作为 LangChain 官方推荐的可视化解决方案,它仍是一个值得持续关注的开源项目。

GitHub: