Wan2.2-Animate 在社交平台已经玩疯了,堪称是nano-banana的视频生成版,为什么这么说呢,因为人物角色的一致性!

就是说可以实现统一的角色动画和替换模型,能够完整复制动作和表情。

并且它们发布了模型权重和推理代码。可以自己部署也可以在线体验,大大降低了体验门槛!

话不多说,先来看看官方宣传的6大玩法效果~

项目介绍

Wan2.2-Animate-14B 是 Qwen 团队推出的一款统一角色动画与替换模型。它能够在保证表情和动作完整复制的同时,实现高质量的视频人物替换。

项目开源后,开发者和创作者可以在 上直接体验,也能本地部署运行。

就是Wan儿~

核心功能

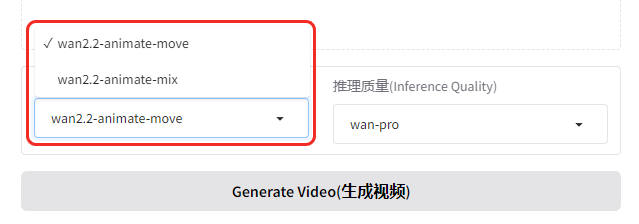

Wan2.2-Animate 提供了两种主要模式,覆盖不同的创作场景:

Move 模式(动作模式)

-

原理:从模板视频中提取动作、姿势和表情信息

-

应用:将动作映射到一张静态角色图像上,生成动作与模板一致的动态视频

-

典型场景:让插画、二次元角色“动起来”

Mix 模式(混合模式)

-

原理:直接用输入图片中的角色替换模板视频中的人物

-

应用:实现精准 AI 换脸(Deepfake)效果

-

典型场景:视频角色替换、短视频特效创作

应用场景

-

短视频创作:让任意角色快速生成舞蹈、表演片段

-

广告营销:用统一形象批量生成宣传素材

-

游戏和二次元动画:低成本做角色动作演示

-

虚拟人领域:驱动数字人,生成表情自然的动作视频

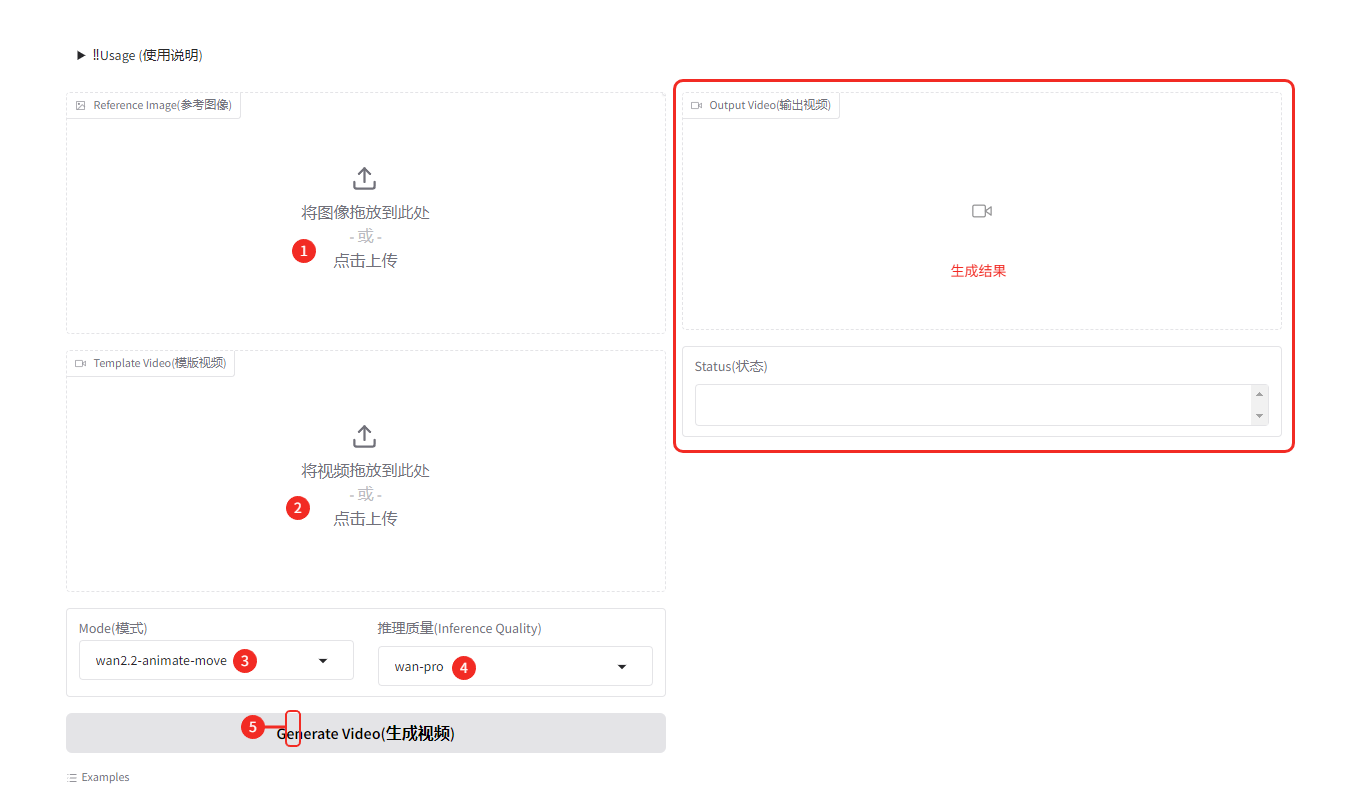

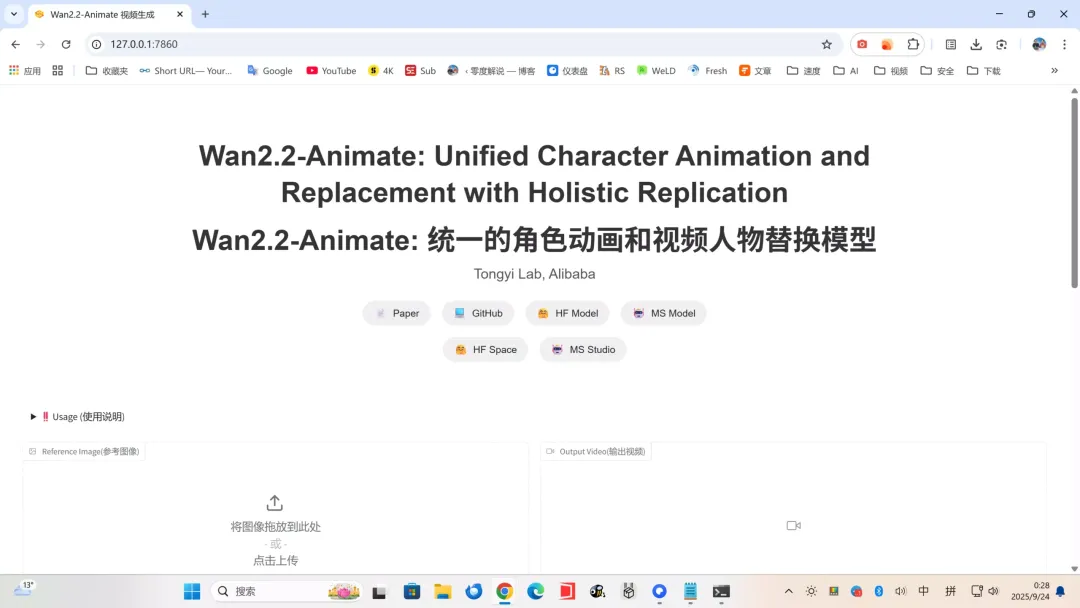

在线体验

没有门槛,直接上传图片和视频,就能Wan

只需 3 步:

上传参考图(最好与视频角度、结构一致)

上传模板视频(2-30s,≤200MB)

点击 Generate Video,等待生成

注意:参考图需小于 5MB,分辨率 200px-4096px。生成时间取决于视频时长。

来来来,看我的成品效果:

本地部署教程

如果你不想受在线排队和限制影响,可以选择本地部署。

安装前置环境

-

Python 3.10+ (64位)

-

Git

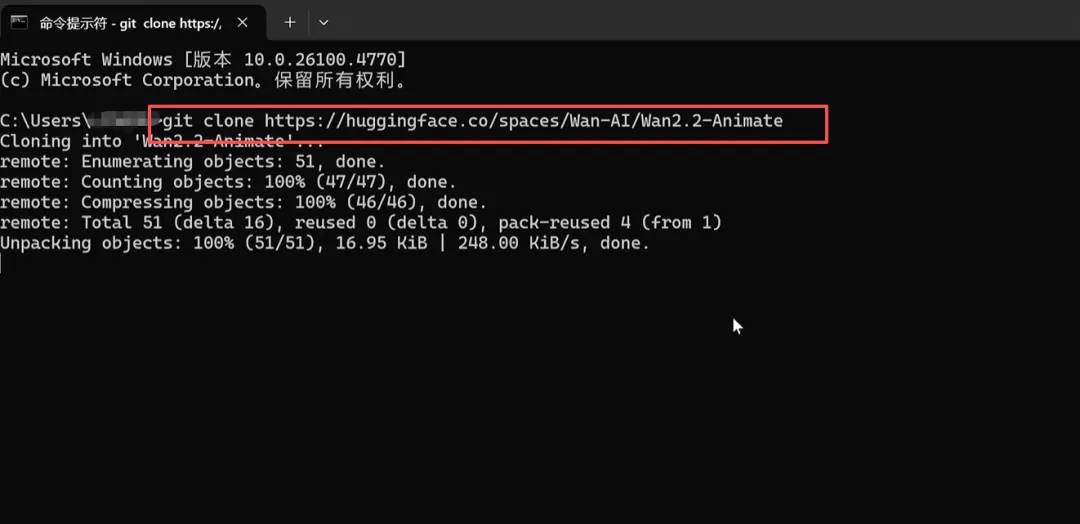

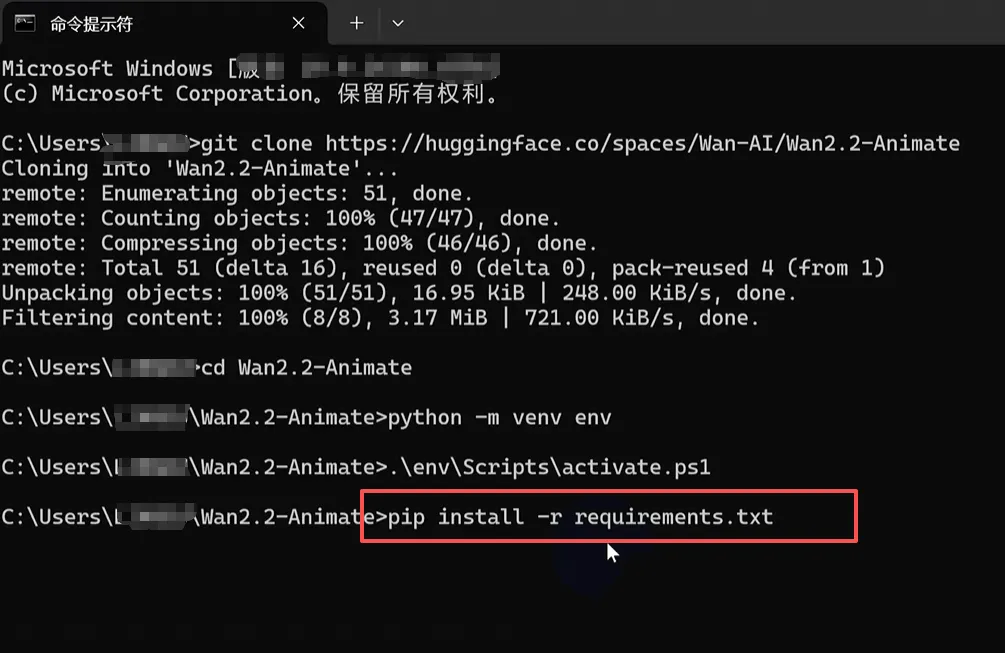

克隆项目代码

git clone https://huggingface.co/Wan-AI/Wan2.2-Animate

cd Wan2.2-Animate

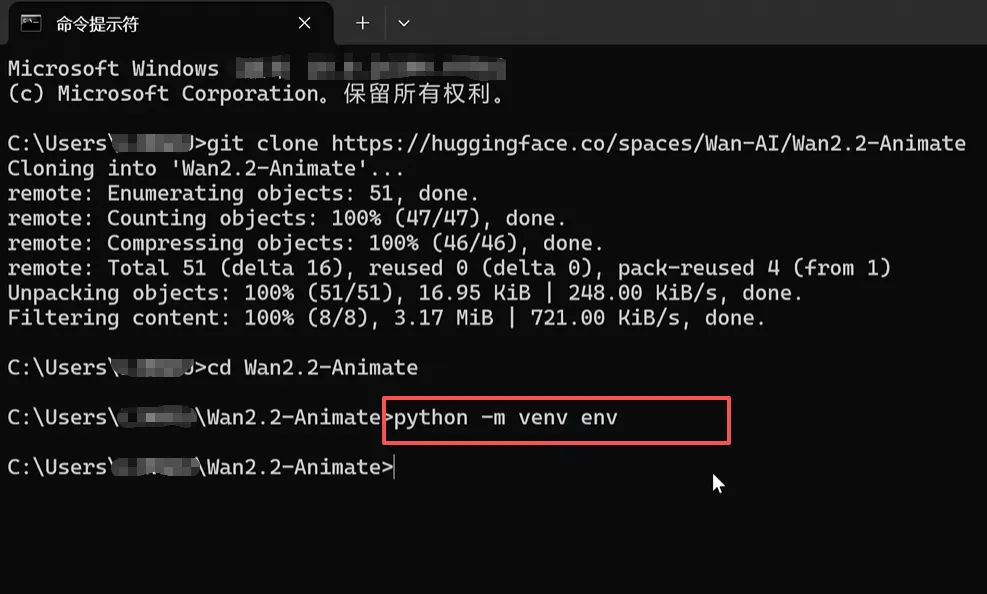

创建虚拟环境并激活

python -m venv env

.\env\Scripts\activate.ps1 # Windows

安装依赖并运行

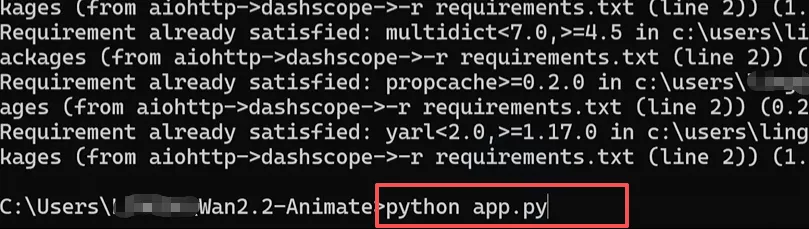

pip install -r requirements.txt

运行项目

python app.py

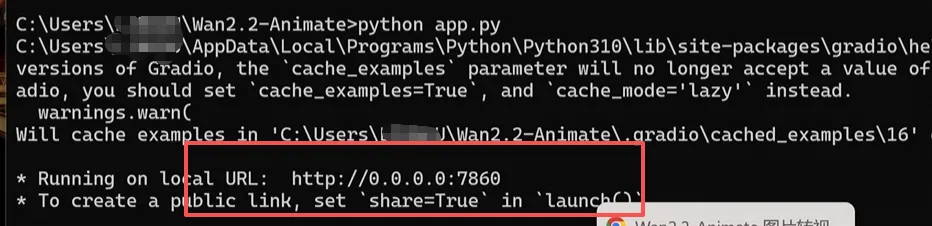

当看到 0.0.0.0:7860 时,就是启动成功了

改成 127.0.0.1:7860 即可在浏览器访问。

总结

如果你想快速测试,可以直接去 HuggingFace Space 玩一玩;

如果追求稳定体验,本地部署是更好的选择。

人物一致性可以让视频生成更精准呈现,无论是做短视频内容、数字人,还是尝试创意动画,它都能极大降低门槛。

开源地址:https://github.com/Wan-Video/Wan2.2

体验地址:https://huggingface.co/spaces/Wan-AI/Wan2.2-Animate

模型介绍: