作为一名长期使用Claude Code的开发者,第一次接触OpenCode,我有一种错觉:

“这不就是又一个AI写代码的工具吗?”

但真正用过之后,才会意识到一件事:OpenCode并不是在“帮你写代码”,而是在“重构你和代码的关系”。

过去我们写代码的流程是线性的:想清楚 → 写代码 → 运行 → 报错 → 查资料 → 改代码。

而OpenCode把这条直线,折叠成了一个可对话、可回溯、可演化的闭环系统

在深入研究OpenCode及其插件生态后,我意识到一个重要转折点正在发生

开源社区正在构建一个与商业AI编程工具相抗衡的完整方案。

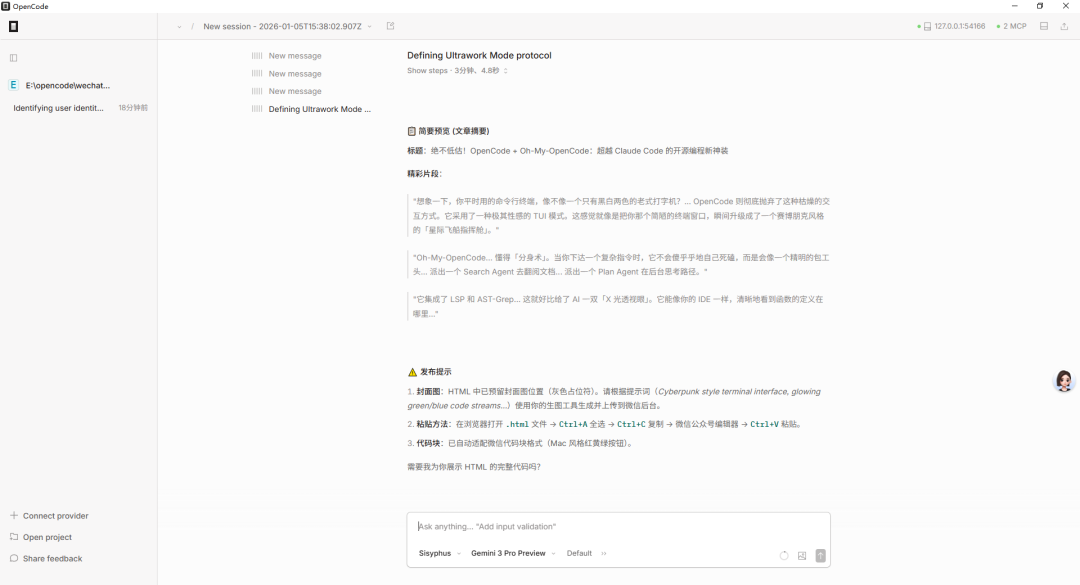

这篇文章的核心观点是:OpenCode+Oh-My-OpenCode的组合,已经在功能完整性、模型选择自由度和成本结构上形成了对Claude Code的有意义的差异化定位。

为什么OpenCode值得关注

Claude Code在过去半年内确实成为了AI编程领域的热点话题,但其限制条件也逐渐显现:

- 仅支持Anthropic官方模型以及有限的第三方模型

- 采用专有架构,不开源且无法自定义扩展

- 订阅成本相对固定,难以降低使用门槛

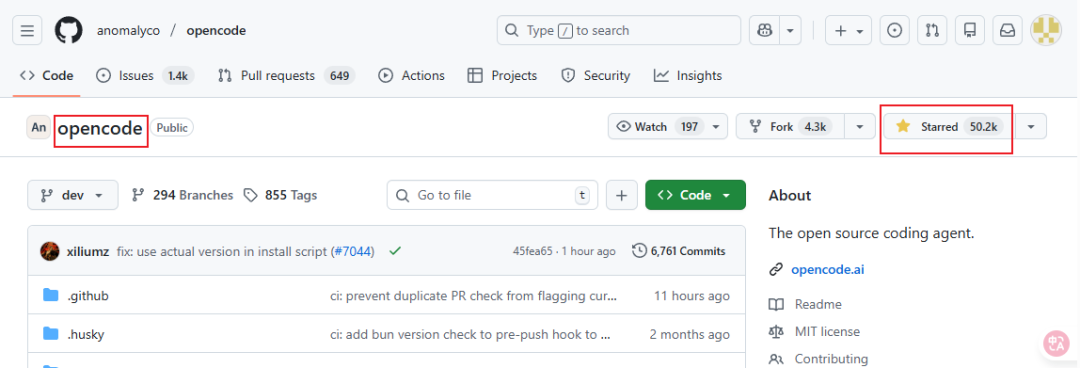

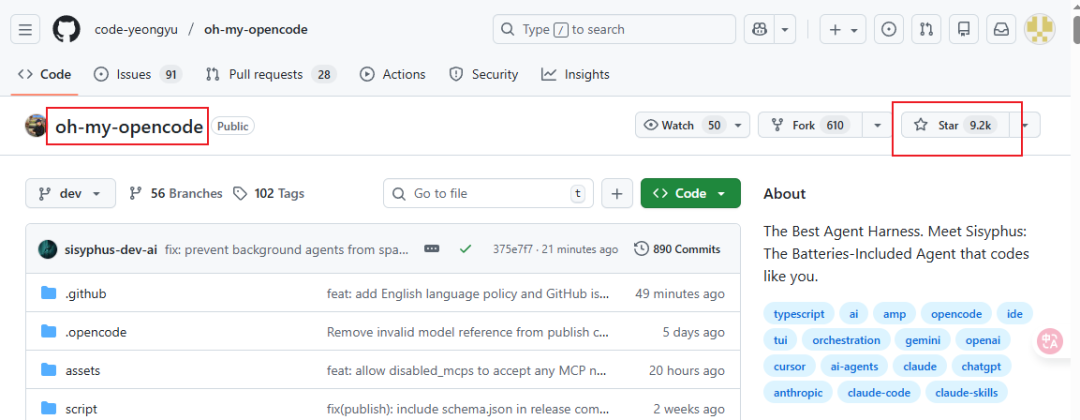

相比之下,GitHub上已获得50.2K Star的OpenCode项目提供了不同的技术路线。

其配套插件Oh-My-OpenCode(9.2K Star)的作者投入了约24000美元的Token成本用于架构打磨,这表明该项目的技术积累已达到可比肩商业产品的水平。

核心能力对比

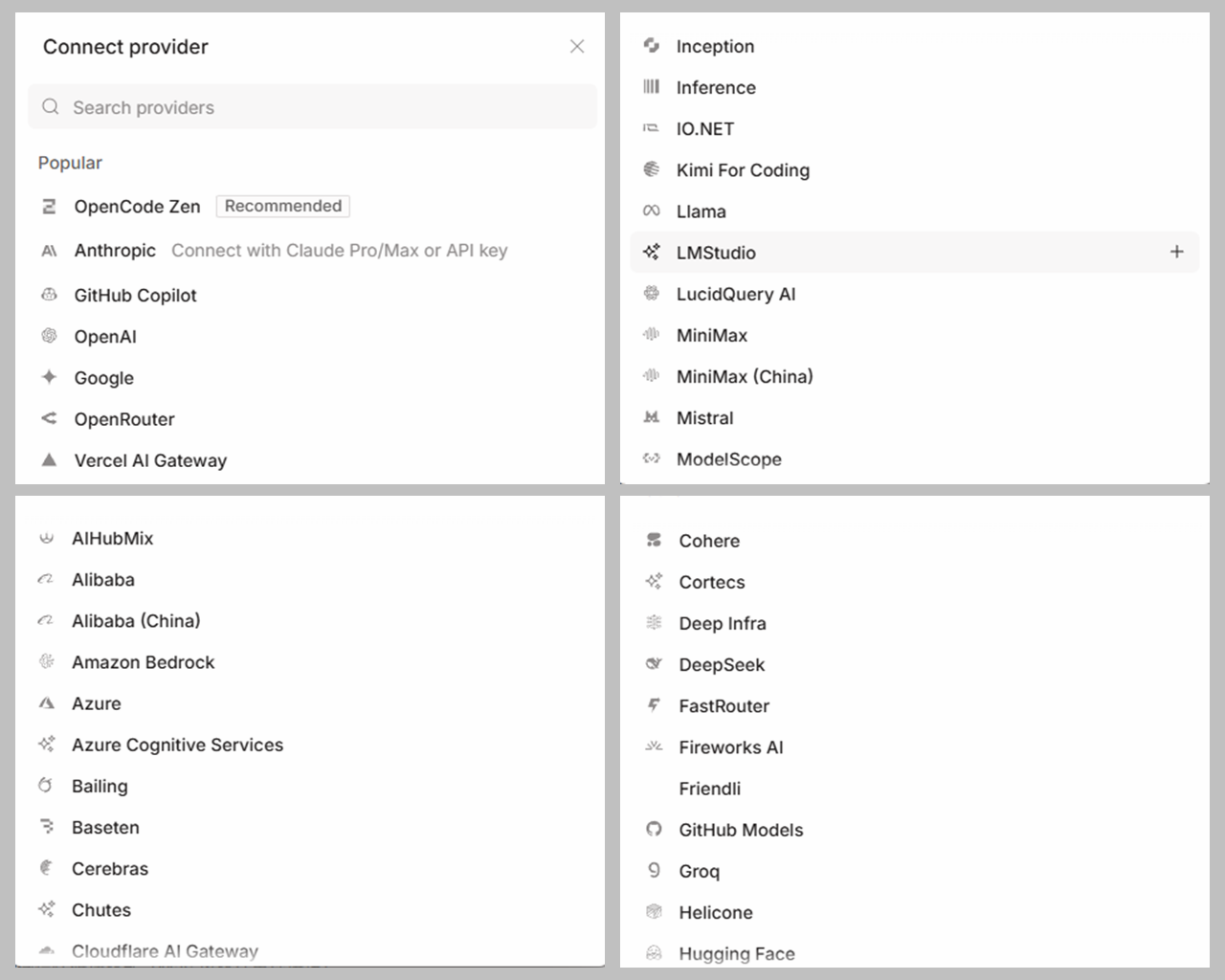

模型支持范围

| 维度 | Claude Code | OpenCode |

|---|---|---|

| 官方模型 | Claude系列 | 支持几乎所有主流模型 |

| 接入方式 | API / 官方订阅 | API / 账户登录 / 免费模型 |

| 免费选项 | 无 | 支持GLM-4.7、MiniMax 2.1等免费模型,无需登录 |

| 成本结构 | 订阅制 | 按使用计费 / 完全免费 |

OpenCode支持的模型清单包括:

- Anthropic系:Claude全系列

- OpenAI系:GPT-4、GPT-4o等

- Google系:Gemini系列

- 中文模型:GLM-4.7、MiniMax 2.1等

- 其他:支持custom endpoint接入

对于已拥有ChatGPT Pro或Claude Pro订阅的用户,通过账户登录方式使用OpenCode在成本上更具优势——无需额外付费即可复用现有订阅。

使用形态

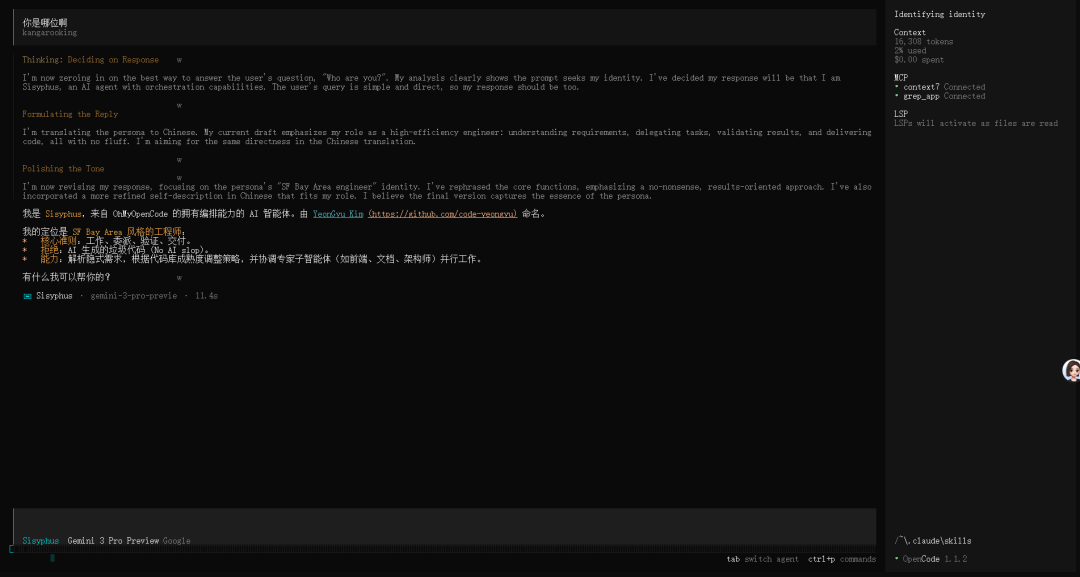

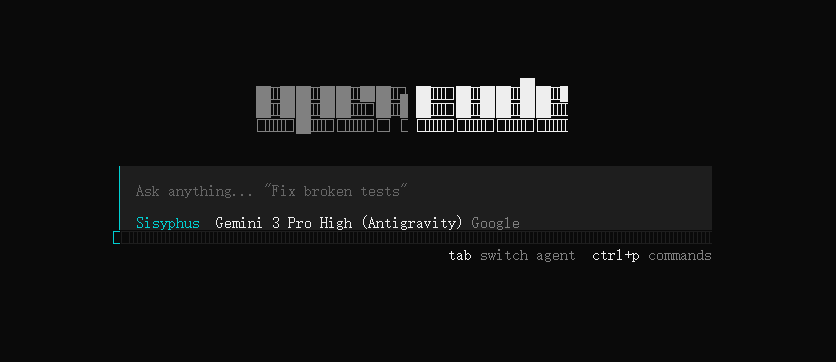

终端模式(TUI):OpenCode采用现代化的终端用户界面设计,将信息流、代码状态、任务进度以可视化方式呈现,相比传统终端的纯文本输出具有显著的可读性优势。

桌面模式:提供图形化界面,对非命令行使用者更加友好。虽然UI设计相对简化,但功能完整性得到保证。

Oh-My-OpenCode插件

异步SubAgent机制(分布式任务处理)

这是相比Claude Code最显著的架构创新。传统AI编程助手采用串行处理模式——一个模型负责所有任务。

Oh-My-OpenCode引入并行的子智能体机制:

- Search Agent:专门负责文档检索和信息查询

- Plan Agent:独立进行任务规划和路径思考

- UI Agent:调用特定模型(如Gemini)处理UI相关任务

这些Agent以异步方式并行执行,主线程保持响应性,用户体验上避免了长时间阻塞。

关键词触发模式

| 模式 | 触发关键词 | 功能描述 |

|---|---|---|

| Ultrawork Mode | ultrawork / ulw | 多Agent并行调度,针对复杂问题的密集计算模式 |

| Think Mode | think deeply / ultrathink | 强制启用长思维链推理,增加模型的深度思考时间 |

| Librarian Mode | search / find / 検索 | 专用于大规模文档和代码库的精准检索 |

| Analyze Mode | analyze / investigate / 調査 | 多阶段专家会诊,执行深度代码分析 |

代码理解的深度集成

OpenCode集成了两项关键技术栈:

- LSP(Language Server Protocol):提供IDE级别的代码符号解析,精确定位函数定义、变量引用、继承关系

- AST-Grep:基于抽象语法树的代码搜索,超越文本匹配的语义级别理解

这意味着OpenCode对代码的理解不是基于文本猜测,而是基于语义结构——这与LSP-aware IDE的实现原理一致。

上下文生命周期管理

长任务中最常见的问题是"AI失忆"——当上下文窗口接近饱和时,模型开始遗忘早期的重要信息。

Oh-My-OpenCode的解决方案是自动压缩机制:

- 在上下文占用达到70%时触发预警

- 在达到85%时自动执行压缩(归纳、打包陈旧对话)

- 防止因上下文溢出导致的任务中断

这项机制的实现类似于长文本处理中的递归总结策略。

代码完整性保障

AI生成代码常见问题——代码生成到一半突然中止(如出现`// ...rest of code`注释)。

插件内置的防截断机制会:

- 自动扫描生成代码中的TODO标记和省略号

- 强制模型补全不完整的代码段

- 确保交付的代码是完整的、可执行的

兼容性与扩展性

Oh-My-OpenCode完全兼容Claude Code的生态标准:

- 命令系统:支持Claude Code的斜杠命令语法

- SubAgent框架:基于相同的分布式Agent模型

- Skills机制:支持自定义功能扩展

- MCP(模型上下文协议):支持标准的工具集成方式

- Hooks系统:支持工作流钩子用于定制化处理

这意味着使用者可以将现有的Claude Code工作流和自定义工具无缝迁移到OpenCode生态。

安装与配置实操

1 OpenCode安装

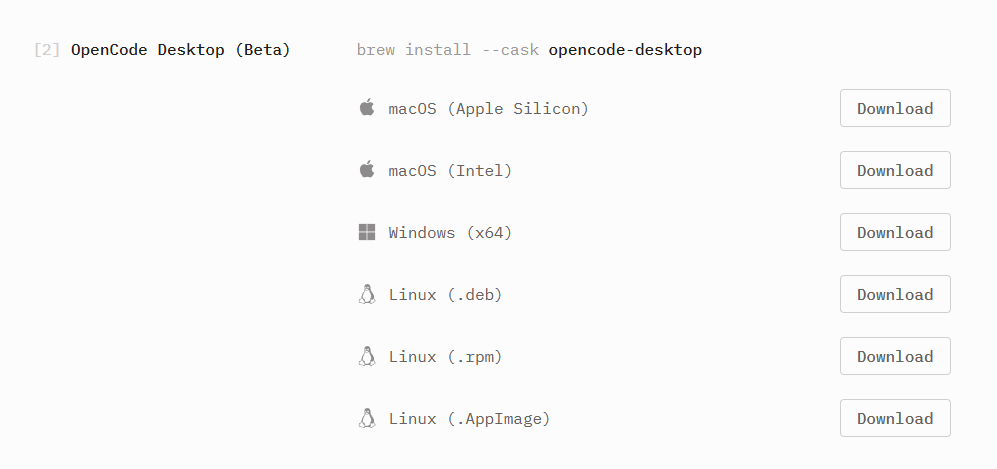

桌面版安装:访问 https://opencode.ai/download,选择对应操作系统下载后进行标准安装。

终端版安装(基于Node.js环境):

npm install -g opencode-ai或使用官方一键脚本:

curl -fsSL https://opencode.ai/install | bash初始化项目:

cd /your/project/path

opencode在TUI界面中输入 `/init` 命令让系统扫描项目结构。

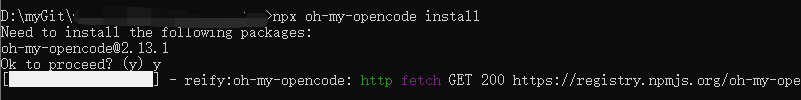

2 Oh-My-OpenCode插件安装

执行安装命令:

npx oh-my-opencode install

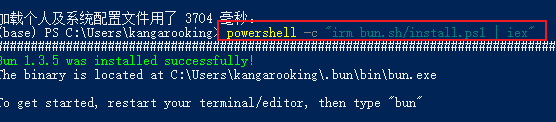

依赖检查:如果提示缺少Bun运行时,在Windows PowerShell中执行:

powershell -c "irm bun.sh/install.ps1 | iex"

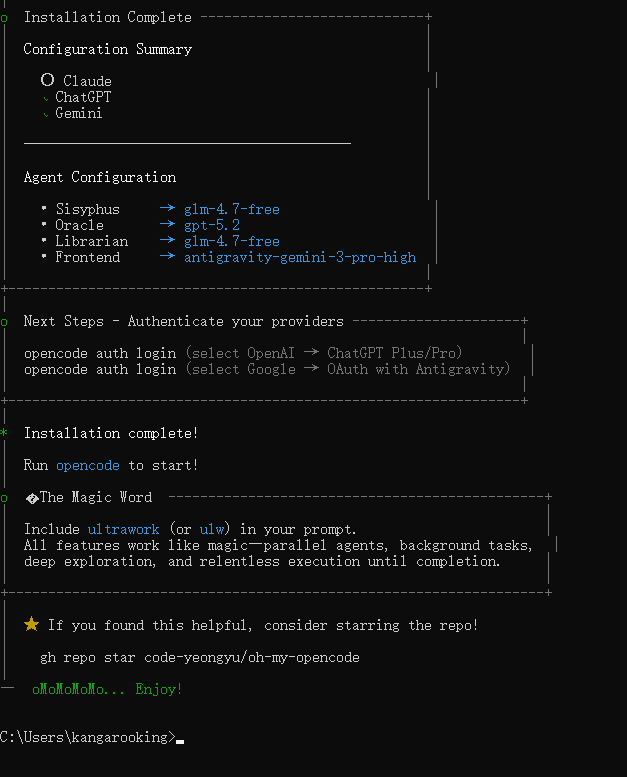

配置流程:安装程序会依次询问以下信息:

- Claude订阅状态(yes / no / max)

- ChatGPT订阅状态(yes / no)

- Gemini订阅状态(yes / no)

配置将自动写入 `%USERPROFILE%\.config\opencode\opencode.json`。

安装完成后,OpenCode会自动加载这些插件能力。

应用场景分析

多模型协同场景

某些任务对模型选择有特定需求

例如UI设计倾向于选择Gemini的视觉能力,而复杂逻辑可能优先选用GPT-4或Claude。OpenCode的灵活模型切换能力允许在同一个任务中动态选择最适配的模型。

长期项目的增量开发

在大型项目的迭代中,上下文管理和代码完整性保障变得关键。Oh-My-OpenCode的自动压缩和防截断机制特别适合以周为单位的持续开发。

成本敏感场景

对于中小型团队或个人开发者,通过复用现有的ChatGPT Pro订阅来使用OpenCode,可以在不增加额外订阅成本的前提下获得企业级的AI编程能力。

OpenCode vs Claude Code

| 维度 | Claude Code | OpenCode + Oh-My-OpenCode |

|---|---|---|

| 开源性 | 专有 | 完全开源 |

| 模型自由度 | 受限 | 极高(支持几乎所有主流模型) |

| 成本结构 | 订阅制(固定月费) | 按需付费 / 免费模型 / 账户登录复用 |

| 架构可定制性 | 不可定制 | 支持自定义Skills、Hooks、MCP集成 |

| 任务处理机制 | 串行处理 | 异步并行SubAgent |

| 代码理解深度 | 文本级别 | 语义级别(LSP + AST) |

| 学习曲线 | 较平缓 | 中等(因功能更丰富) |

结语

在我持续钻研Claude Code的过程中,我逐渐认识到一个现象:最强大的工具往往不是来自单一厂商的完美设计,而是由开源社区通过持续迭代、接纳用户反馈而逐步完善的生态。

OpenCode+Oh-My-OpenCode的组合恰好代表了这一趋势。

这个方案的价值不在于"打败"Claude Code,而在于提供了一条真正的替代路线——它以开源、模型自由、成本透明为核心,为那些追求技术控制权和长期成本优化的开发者提供了选择。

我已在数字人短视频项目中集成了这套工具链,实际体验表明,操作习惯的迁移成本几乎为零(命令系统保持一致),而收获的是更灵活的模型选择和更强大的任务处理能力。

正如所有有意义的技术选择一样,这不是一个"更好或更差"的问题,而是一个"是否匹配你的需求"的问题。如果你对模型自由度有需求、对长期成本敏感、或者希望在AI编程工具上获得更多的定制化空间,花10分钟尝试OpenCode是完全值得的。

技术的最高境界是在充分理解的基础上做出知情决策。我鼓励每一位读者去实际操作一遍——唯有亲身体验,才能真正感知差异所在。