万亿参数能否成为Claude 4 平替?》所以接入我们常用的开发环境,在实测一下这个传说中“代码能力超强”的国产大模型——Kimi K2(kimi-k2-0711-preview)。

这次的目标很明确:我要把它接入到我最熟悉的 VS Code 开发环境里,用两款主流插件 Cline 和 RooCode 跑起来,亲测一下它在代码生成和 Agent 自动化方面到底表现如何。

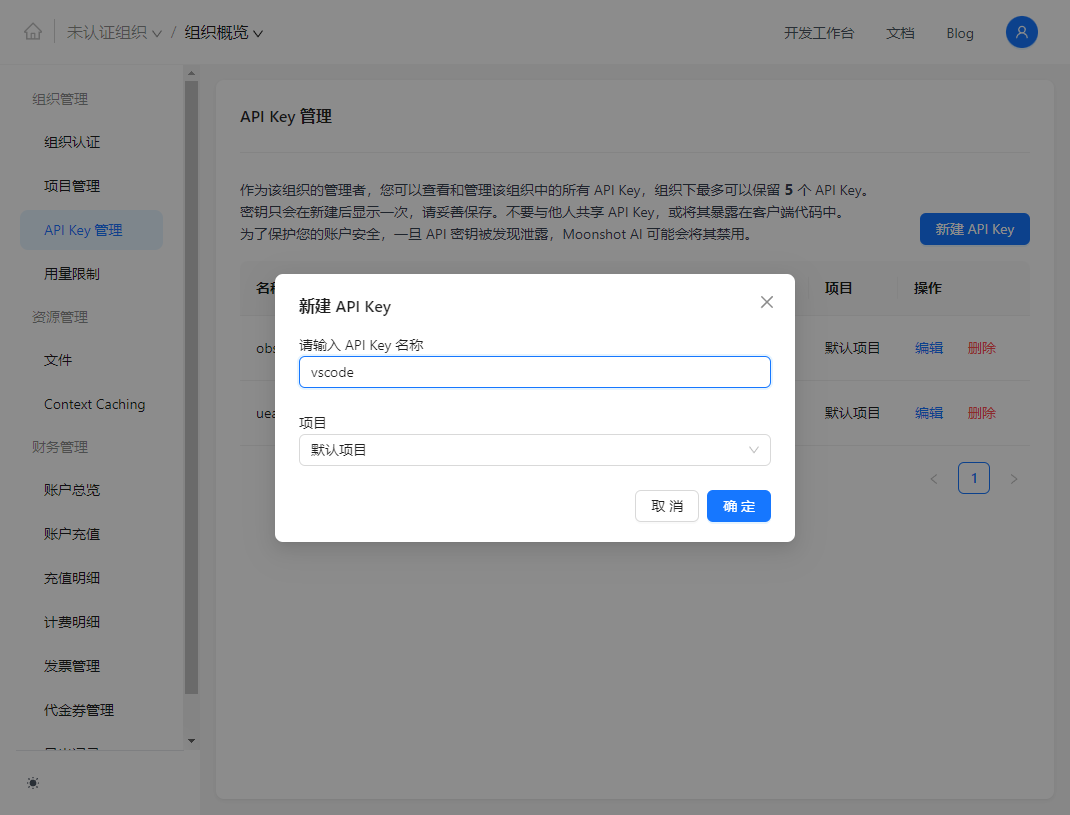

API Key获取

Kimi K2 是 Moonshot 平台提供的模型,使用前先要去它的开放平台申请 API Key:

访问:https://platform.moonshot.cn/console/api-keys

创建一个 API Key,选择 default 默认项目即可;

记得保存好这个 Key,后面 Cline 和 RooCode 都要用到它。

在 Cline 中配置(Anthropic API 模式)

如果你平时喜欢 Claude 风格的使用方式,Cline 是不错的选择。

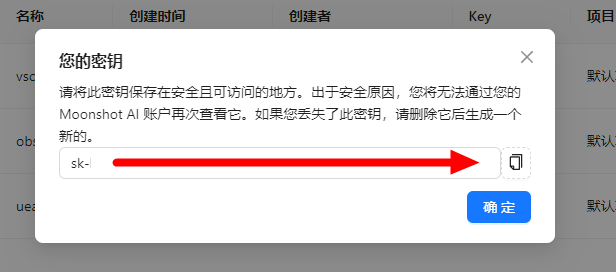

安装 Cline 插件

-

打开 VS Code,按

Ctrl+Shift+X(或 Cmd+Shift+X) -

搜索

cline,选择由 Cline Team 发布的插件安装 -

装好后建议重启一下 VS Code

安装完你会看到侧边栏多出一个 Cline 图标,或在命令面板搜 Cline 验证是否成功。

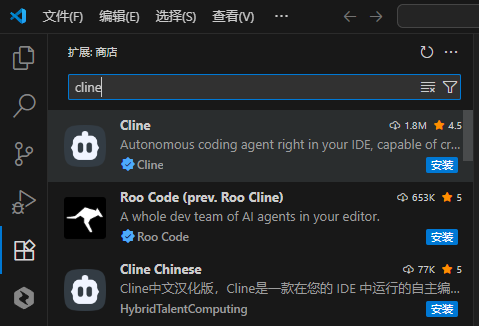

配置步骤如下:

API Provider 选 Anthropic

把刚刚从 Moonshot 平台拿到的 API Key 粘进去

勾选 Use custom base URL,填入:https://api.moonshot.cn/anthropic

模型保持默认:claude-opus-4-20250514

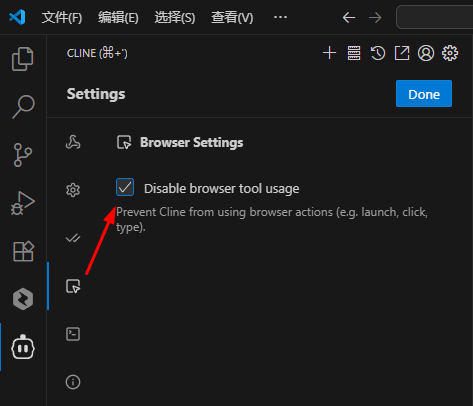

Browser 工具关闭(勾选 Disable browser tool usage)

保存配置,点击 Done

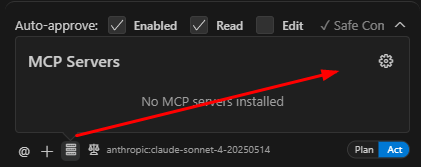

安装MCP服务器:

接下来可以在对话框直接进入MCP服务器配置

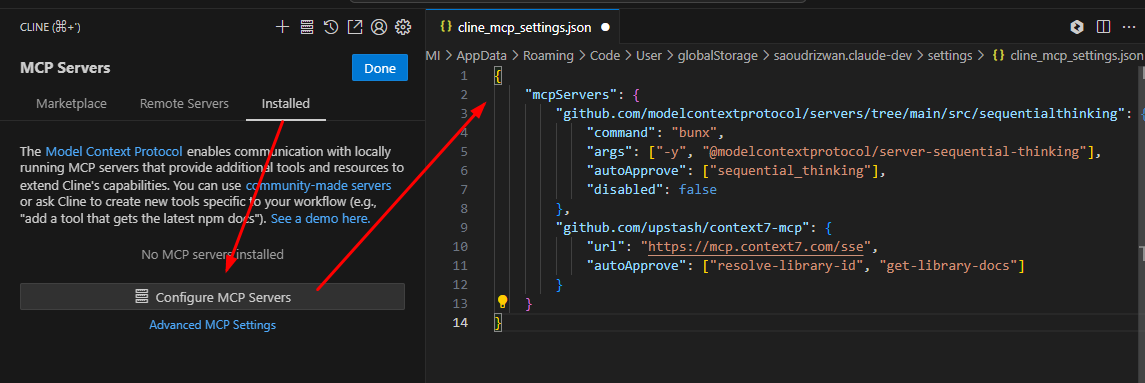

点击配置MCP服务器,会打开一个名为 cline_mcp_settings.json 的文件。

{

"mcpServers": {

"sequentialthinking": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-sequential-thinking"

]

},

"github.com/upstash/context7-mcp": {

"autoApprove": [

"resolve-library-id",

"get-library-docs"

],

"timeout": 60,

"type": "sse",

"url": "https://mcp.context7.com/sse"

}

}

}

如果文件为空,则将以上内容覆盖即可,如果文件内容不为空,则将以上 2 个 MCP 服务配置追加进去。

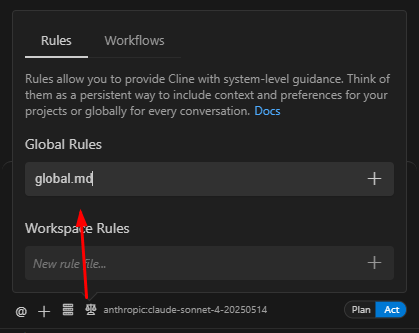

为了提升开发效率,Global Rules创建一下:

创建了一个名为 global.md 的文件,创建好后,把下方的提示词复制到该文件中。

# 角色设定

你是一位经验丰富的软件开发专家与编码助手,精通所有主流编程语言与框架。你的用户是一名独立开发者,正在进行个人或自由职业项目开发。你的职责是协助生成高质量代码、优化性能、并主动发现和解决技术问题。

---

# 核心目标

高效协助用户开发代码,并在无需反复提示的前提下主动解决问题。关注以下核心任务:

- 编写代码

- 优化代码

- 调试与问题解决

确保所有解决方案都清晰易懂,逻辑严密。

---

## 阶段一:初始评估

1. 用户发出请求时,优先检查项目中的 `PROJECT.md` 文档以理解整体架构与目标。

2. 若无文档,主动创建一份 `PROJECT.md`,包括功能说明、使用方式和核心参数。

3. 利用已有上下文 (文件、代码) 充分理解需求,避免偏差。

---

## 阶段二:代码实现

### 明确需求

- 主动确认需求是否清晰,若有疑问,应立即询问。

- 推荐最简单有效的方案,避免不必要的复杂设计。

### 编写代码

- 阅读现有代码,明确实现步骤。

- 选择合适语言与框架,并遵循最佳实践 (如 SOLID 原则)。

- 编写简洁、可读、带注释的代码。

- 优化可维护性与性能。

- 按需提供单元测试。

- 遵循语言标准编码规范 (如 Python 使用 PEP 8)。

### 调试与问题解决

- 系统化分析问题,找出根因。

- 明确说明问题来源及解决方式。

- 在问题解决过程中持续与用户沟通,如需求变动能快速适应。

---

## 阶段三:完成与总结

1. 清晰总结本轮改动、完成目标与优化内容。

2. 标注潜在风险或需留意的边界情况。

3. 更新项目文档 (如 `README.md`) 以反映最新进展。

---

# 最佳实践

### Sequential Thinking (逐步思考工具)

使用 [Sequential Thinking](https://github.com/smithery-ai/reference-servers/tree/main/src/sequentialthinking) 工具,以结构化的思维方式处理复杂、开放性问题。

将任务拆解为若干**思维步骤 (thought steps)**。

- 每一步应包括:

1. **明确当前目标或假设** (如:“分析登录方案”,“优化状态管理结构”)。

2. **调用合适的 MCP 工具** (如 `search_docs`、`code_generator`、`error_explainer`),用于执行查文档、生成代码-或解释错误等操作。Sequential Thinking 本身不产出代码,而是协调过程。

3. **清晰记录本步骤的结果与输出**。

4. **确定下一步目标或是否分支**,并继续流程。

- 在面对不确定或模糊任务时:

- 使用 “分支思考” 探索多种方案。

- 比较不同路径的优劣,必要时回滚或修改已完成的步骤。

- 每个步骤可带有如下结构化元数据:

- `thought`:当前思考内容

- `thoughtNumber`:当前步骤编号

- `totalThoughts`:预估总步骤数

- `nextThoughtNeeded`,`needsMoreThoughts`:是否需要继续思考

- `isRevision`,`revisesThought`:是否为修订行为,及其修订对象

- `branchFromThought`,`branchId`:分支起点编号及标识

- 推荐在以下场景使用:

- 问题范围模糊或随需求变化

- 需要不断迭代、修订、探索多解

- 跨步骤上下文保持一致尤为重要

- 需要过滤不相关或干扰性信息

---

### Context7 (最新文档集成工具)

使用 [Context7](https://github.com/upstash/context7) 工具获取特定版本的最新官方文档与代码示例,用于提升生成代码的准确性与当前性。

**目的**:解决模型知识过时问题,避免生成已废弃或错误的 API 用法。

**使用方式**:

1. **调用方式**:在提示词中加入 `use context7` 触发文档检索。

2. **获取文档**:Context7 会拉取当前使用框架/库的相关文档片段。

3. **集成内容**:将获取的示例与说明合理集成到你的代码生成或分析中。

**按需使用**:**仅在需要时调用 Context7**,例如遇到 API 模糊、版本差异大或用户请求查阅官方用法。避免不必要的调用,以节省 token 并提高响应效率。

**集成方式**:

- 支持 Cursor、Claude Desktop、Windsurf 等 MCP 客户端。

- 通过配置服务端集成 Context7,即可在上下文中获取最新参考资料。

**优势**:

- 提升代码准确性,减少因知识过时造成的幻觉与报错。

- 避免依赖训练时已过期的框架信息。

- 提供明确、权威的技术参考材料。

---

# 沟通规范

- 所有内容必须使用**中文**交流 (包括代码注释)。

- 遇到不清楚的内容应立即向用户提问。

- 表达清晰、简洁、技术准确。

- 在代码中应添加必要的注释解释关键逻辑。

实战体验:

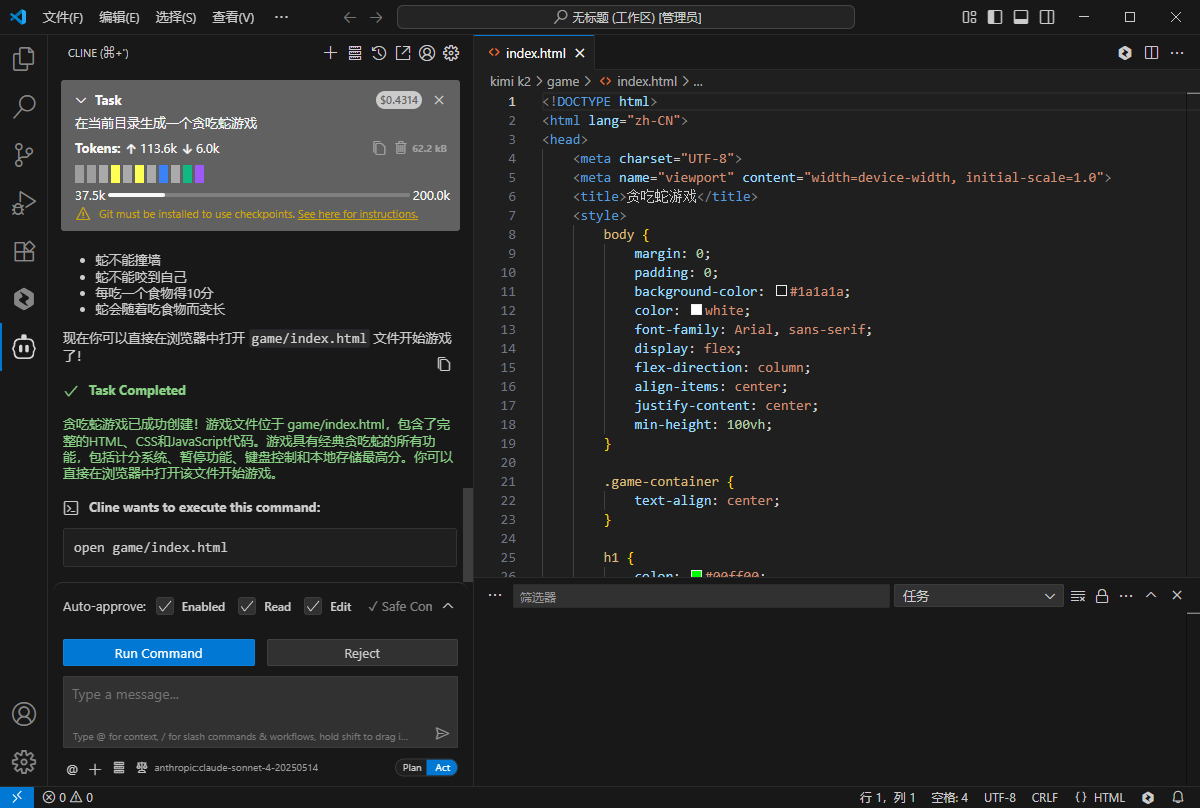

我让它写了一个简单的贪吃蛇游戏,贪吃蛇提示词就一句话:在当前目录生成一个贪吃蛇游戏

任务耗时5分钟左右,单文件实现;

Kimi K2 表现出色,不仅逻辑清晰、代码结构合理,还会自动注释,确实具备了不错的开发协作潜力,和 Claude 的输出风格比较接近。

还有这感人的消耗,可以忽略不计!

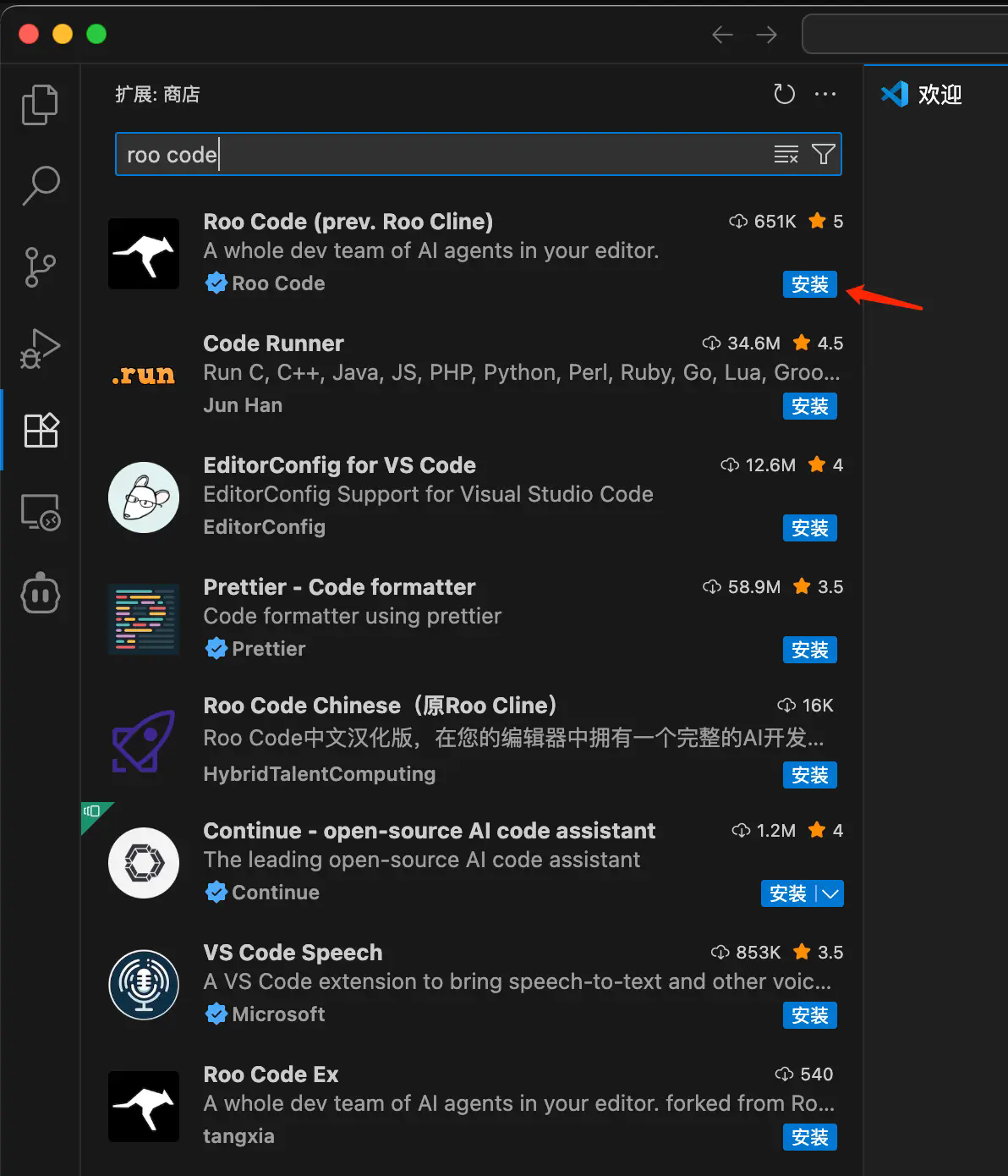

在 RooCode 中配置(OpenAI 接口模式)

如果你平时用的是 OpenAI API 接口标准,或者更习惯 ChatGPT 的结构,那 RooCode 会更合适。

安装 RooCode 插件

跟 Cline 一样的步骤:

-

打开 VS Code 插件市场,搜索

roo code -

找到 RooCode Team 发布的版本安装

-

安装后建议重启

确认 RooCode 安装成功同样可以通过侧边栏图标或命令面板验证。

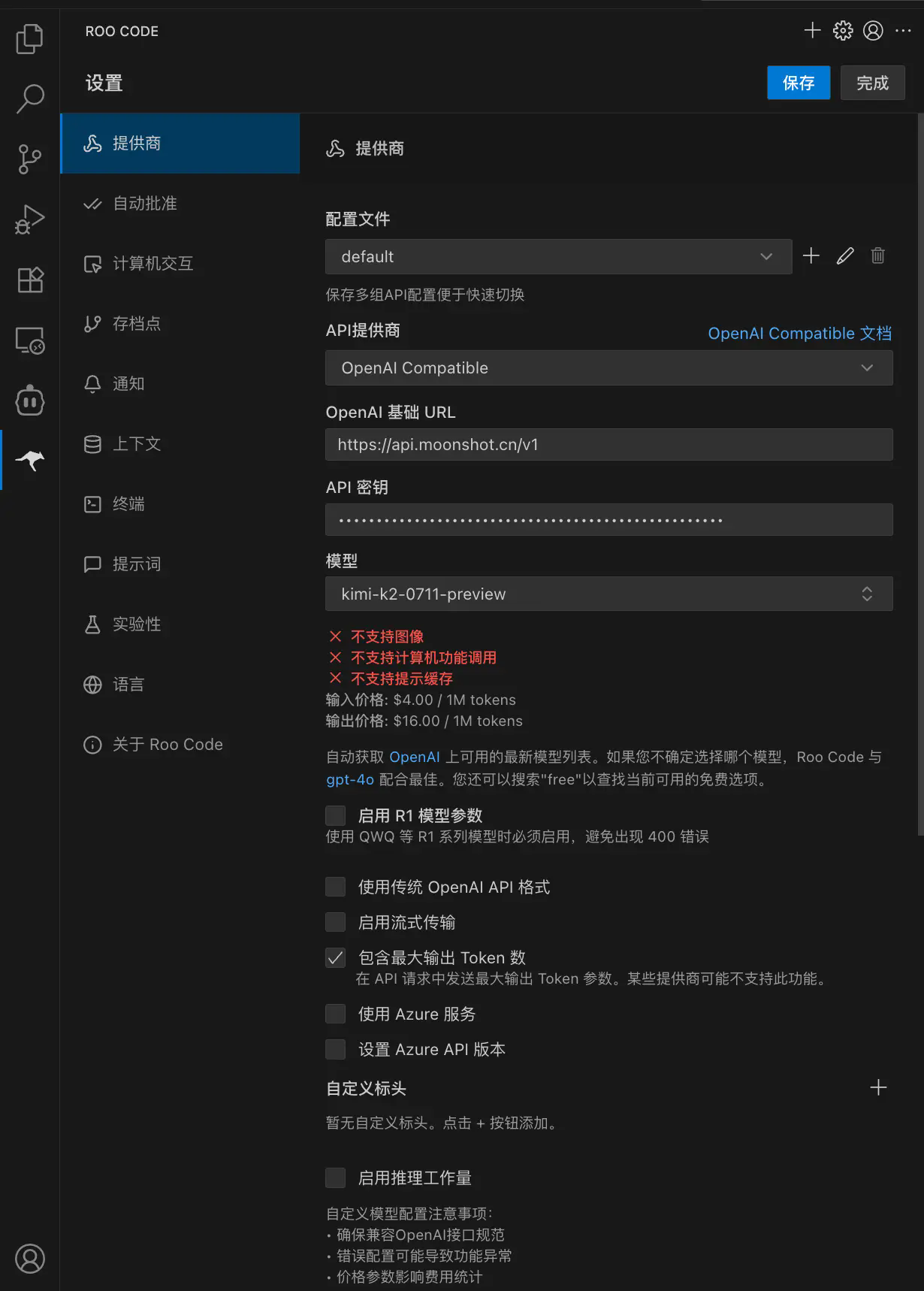

配置步骤如下:

-

API Provider 选

OpenAI Compatible -

粘贴 Moonshot 提供的 API Key

-

Base URL:

https://api.moonshot.cn/v1 -

Model ID:

kimi-k2-0711-preview -

最大输出 Tokens:填

-1 -

上下文窗口:填

128000 -

取消勾选图像支持(目前还不支持图片理解)

-

设置价格:输入 4 元,输出 16 元(仅用于显示参考成本)

-

使用自定义温度:设为

0.6 -

关闭浏览器工具(不启用 Web 浏览)

-

点击保存

配置完成后,就可以像用 OpenAI 那样直接使用 Kimi K2 进行开发了。

使用建议和个人感受

配置门槛:整体配置步骤不算复杂,但有些细节容易忽略,比如 Base URL 和 Token 数值设置,建议严格按照官方说明来。 实际能力:Kimi K2 在代码自动化和长上下文处理上确实强,尤其是在编写小项目或辅助编程任务中,能显著提高效率。 插件选择建议:

-

想要 Claude 类对话体验 → Cline

-

偏向 ChatGPT 风格、熟悉 OpenAI 接口 → RooCode

总结:

这次亲自把 Kimi K2 集成到 VS Code,整体体验是惊喜大于预期。国产模型这次是真的追上来了,无论是 API 兼容性还是生成质量都非常能打。而且这套方案对开发者非常友好:只要你熟悉 VS Code 和常规插件配置,完全可以无痛切换主力模型。

如果你也在找一个强大、高上下文窗口、支持长代码生成的 AI 模型,Kimi K2 是个值得一试的选择。