提示词的设计。写得好,它能像灵魂共鸣一样理解你;写得差,输出的内容就像答非所问的机器人。

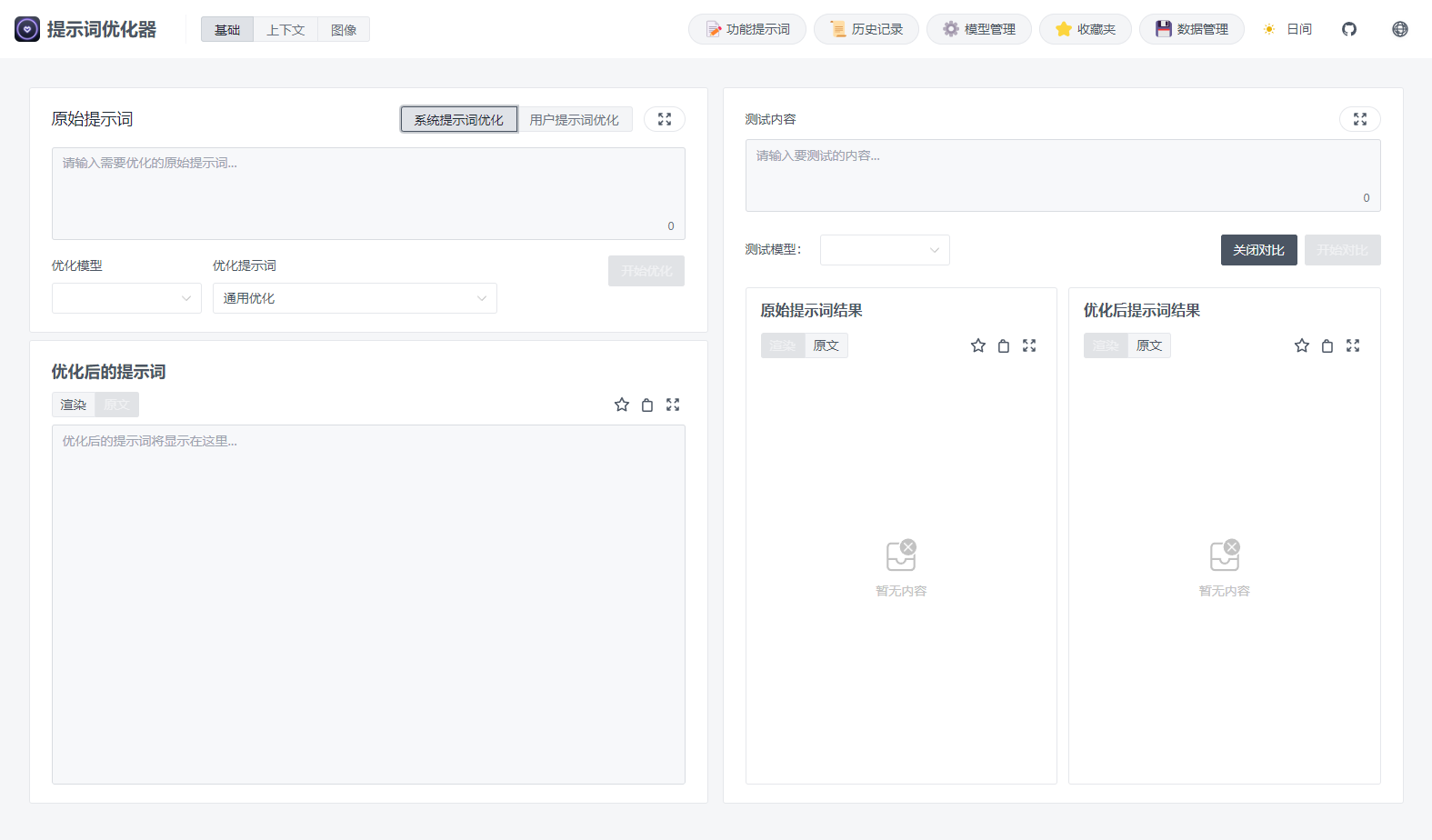

最近我体验了一个开源项目——Prompt Optimizer,它正是为了解决这个问题而生的:

一个可以一键优化提示词的工具,让任何AI模型都能输出更精准、更稳定的结果。

项目支持 Web、桌面端、Chrome 插件和 Docker 部署等多种使用方式,几乎覆盖了所有开发和创作场景。

核心特性

-

智能优化:一键生成改进后的提示词,支持多轮迭代。

-

双模式优化:分别针对系统提示词与用户提示词,适配不同用途。

-

对比测试:原始与优化后的AI输出实时对比,一眼看出提升。

-

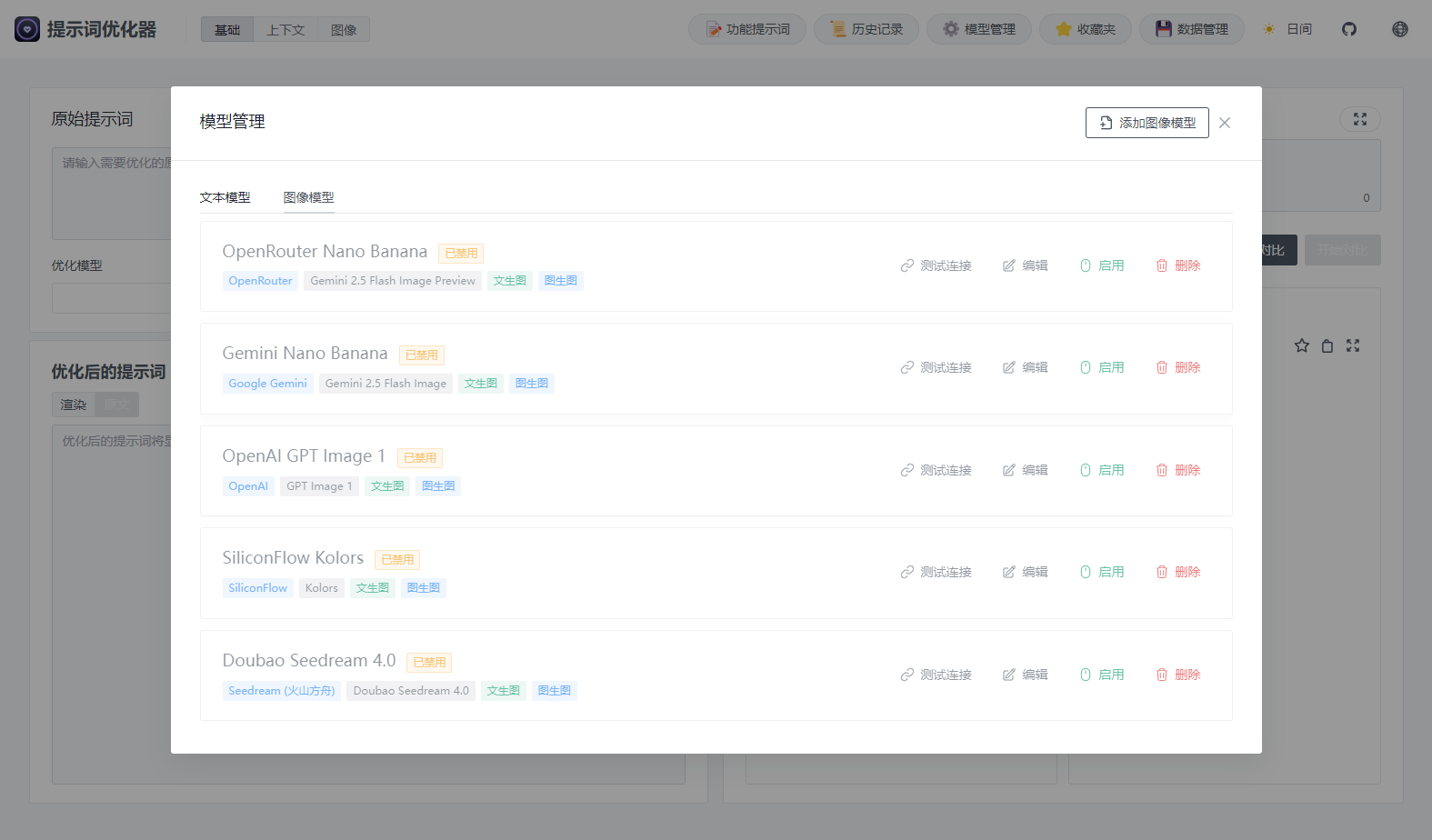

多模型集成:支持 OpenAI、Gemini、DeepSeek、智谱AI、SiliconFlow 等主流模型。

-

图像生成:内置 T2I 与 I2I 模式,集成 Gemini、Seedream 等图像模型。

-

高级测试模式:支持上下文变量管理、多轮会话测试与 Function Calling。

-

安全架构:纯前端运行,数据不上传服务器。

-

多端支持:Web、桌面、Chrome 插件、Docker 全覆盖。

-

访问控制:密码保护可选,方便私有部署。

-

MCP 协议支持:可无缝集成 Claude Desktop 等 MCP 应用。

高级功能详解

图像生成模式

-

文生图 (T2I):输入文字直接生成图像。

-

图生图 (I2I):基于本地图片进行风格或结构变换。

-

多模型支持:兼容 Gemini、Seedream 等主流图像模型。

-

参数可调:自定义尺寸、风格、提示强度等关键参数。

-

实时预览与下载:快速查看并保存结果。

高级测试模式

-

上下文变量管理:批量替换变量,方便测试。

-

多轮对话测试:模拟真实用户交互。

-

工具调用支持:集成 Function Calling,支持 OpenAI / Gemini 工具调用。

-

灵活调试:多参数迭代测试,快速找到最佳提示方案。

快速上手指南

在线版(推荐)

访问:https://prompt.always200.com纯前端运行,数据只存储在浏览器本地,安全又方便。

Vercel 部署

两种方式:

-

一键部署(简单但不自动更新)

-

Fork项目后导入(推荐,可追踪上游更新)

需要配置:

ACCESS_PASSWORD # 访问密码

VITE_OPENAI_API_KEY # 各模型API密钥

桌面应用

从 下载对应平台版本:

-

安装包(推荐):支持自动更新。

-

压缩包:解压即用。

桌面端优势:

-

无跨域限制,适合连接本地模型(如 Ollama)。

-

自动更新机制。

-

原生运行,更快更稳。

Chrome 插件

可在 Chrome 商店安装。点击浏览器图标即可打开优化器。

Docker 部署

面向开发者的可定制部署方式,支持自定义 API 密钥与访问控制。

为什么值得一试?

-

提升AI输出质量:结构化提示词 = 高质量结果。

-

支持多模型切换:一次配置,多模型共用。

-

可视化对比:效果提升肉眼可见。

-

隐私安全:所有数据本地运行,无云端存储。

应用场景示例

-

角色扮演:打造高一致性的AI人格体验。

-

知识提取:企业/生产环境中的结构化输出。

-

创意写作:把模糊灵感变成明确创意。

常见问题

Q:为什么API密钥配置后仍无法连接? A:可能是跨域问题。对于本地Ollama,请设置 OLLAMA_ORIGINS=*;商业API建议使用Vercel代理或自建中转。

Q:在线版与桌面版的区别? 在线版便捷轻量,适合快速测试;桌面版无CORS限制,可直连本地模型,并支持自动更新。

总结

作为一个经常与AI工具打交道的独立开发者,我越来越相信——提示词是AI时代的编程语言。

Prompt Optimizer 并不是又一个花哨的“AI辅助工具”,而更像是一个提示词工坊:

它能帮你从模糊的想法到精准的表达,跨过那道“AI理解偏差”的鸿沟。

如果你每天都在用AI写作、开发、生成图片或做实验,那么这个工具绝对能帮你省下大量时间。

项目地址

在线使用:https://prompt.always200.com/

源代码: