VoxCPM:一款 无需分词器的端到端语音生成(Tokenizer-Free TTS)模型,主打两个能力:

上下文感知的自然语音生成和逼真的零样本声音克隆

VoxCPM 不仅拥有高质量和丰富表现力的声线,而且只需上传几秒的参考声音,就能实现克隆。

VoxCPM 模型参数尺寸仅有 0.5 B,非常轻量,但语音合成的效果一点儿不逊。

在自然度、音色复刻程度、韵律等方面都达到了最优的水平,极其高效、实用。

项目简介

清华大学联合面壁智能推出了一款新的语音生成模型:VoxCPM,目前已经在 GitHub 和 Hugging Face 上开源了。

VoxCPM 基于 MiniCPM-4 语言模型骨干,采用 扩散-自回归架构(Diffusion Autoregressive),直接从文字生成连续语音表示,避免了主流TTS常见的“离散分词器限制”。

性能表现

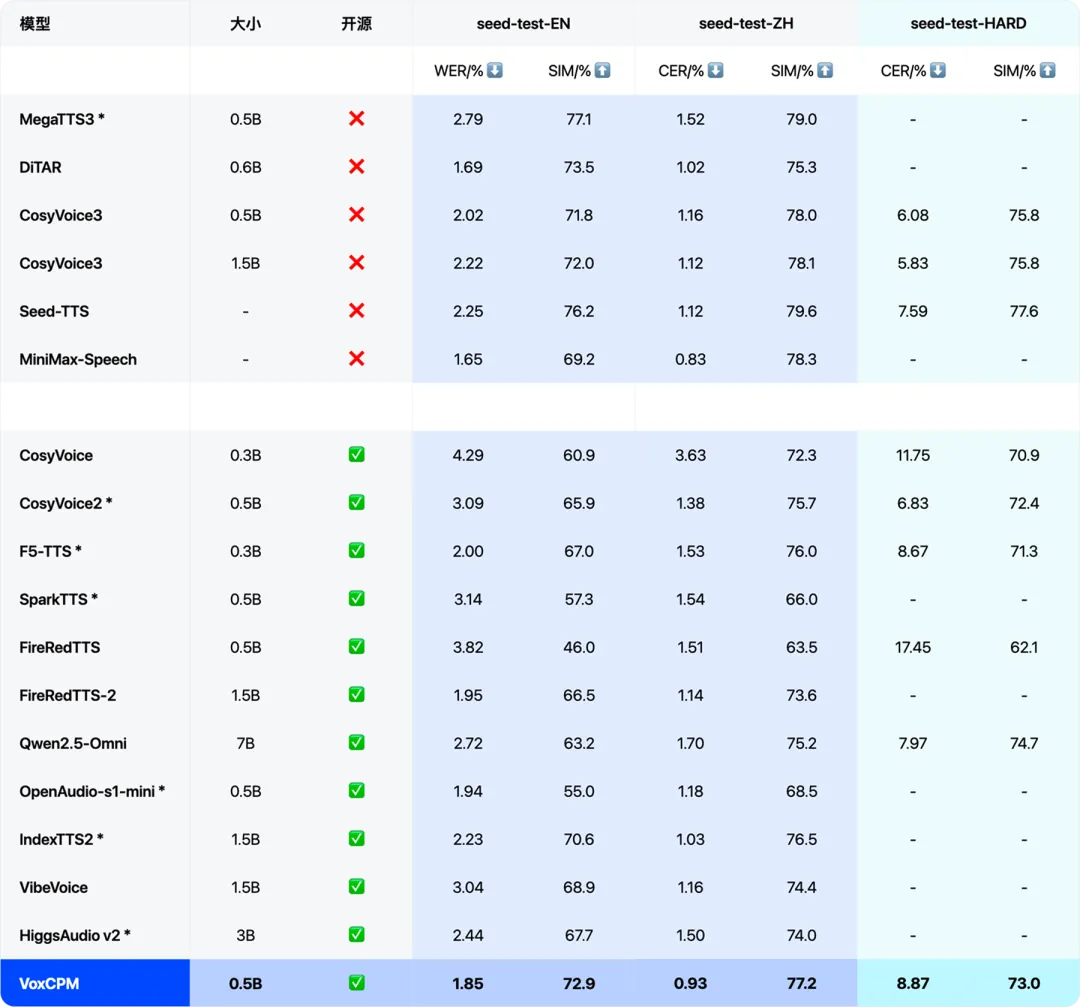

下面这个表梳理了目前主流的语音合成模型的表现,开源的和不开源的都列进去了。

基于 Seed-TTS-EVAL 权威评测榜单,可以看到 VoxCPM 在 WER% (词错误率) 、 CER% (字错误率)、SIM% (相似度) 等维度上,不管是英文还是中文都达到了最优。

也就是说这个 0.5B 的小家伙,合成语音的准确性、克隆音色的相似程度、效率三个方面取得了惊人平衡的模型。

这让它在表达力、自然度和稳定性上有了明显优势。

它的训练数据规模也很惊人:180万小时的双语语音语料。

这意味着无论是中文还是英文,都能生成自然、流畅、带有情感的语音。

核心功能

上下文感知的语音生成

VoxCPM 会根据文本内容自动调整语调、停顿和情绪。例如读新闻时是平稳的,读诗歌时带有抑扬顿挫。

零样本声音克隆

只需一小段参考音频,就能克隆出高度逼真的声音,连口音、语速和情绪细节都能复刻。

高效推理

在消费级显卡(RTX 4090)上,实时因子(RTF)能低到 0.17,支持实时合成,适合对接应用场景。

模型原理

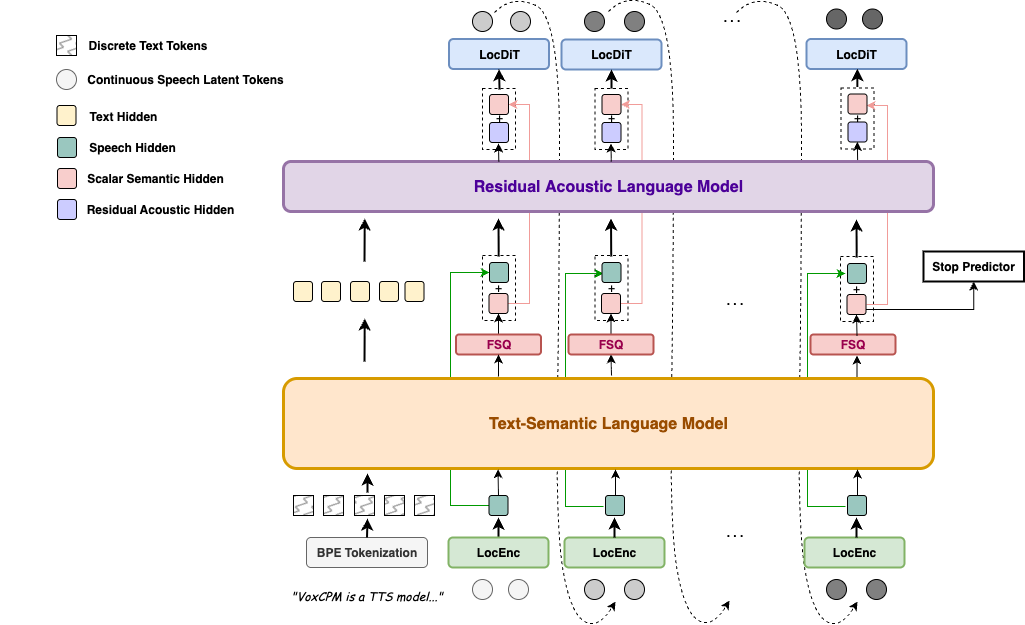

下面是 VoxCPM 模型的架构图。

它利用一个 MiniCPM-4 作为大脑来理解文本上下文,摒弃传统的语音离散化步骤,直接在连续空间中,采用扩散自回归的生成方式。

并辅以 FSQ 等约束来实现特征解耦,从而同时实现高度表现力的语音合成和极其逼真的零样本语音克隆。

应用场景

内容创作:播客、短视频配音、自媒体解说

教育领域:个性化教学助手、语言学习语音反馈

虚拟人/游戏:角色语音生成、剧情对话动态演绎

辅助功能:帮助语言障碍者发声,提升可及性

安装与使用

VoxCPM 已经发布到 PyPI,一行命令即可安装:

pip install voxcpm

首次运行时会自动下载模型,也可以提前从 Hugging Face 拉取:

# 下载 VoxCPM-0.5B

from huggingface_hub import snapshot_download

snapshot_download("openbmb/VoxCPM-0.5B",local_files_only=local_files_only)

# 下载 ZipEnhancer 和 SenseVoice-Small。

from modelscope import snapshot_download

snapshot_download('iic/speech_zipenhancer_ans_multiloss_16k_base')

snapshot_download('iic/SenseVoiceSmall')

Python 调用示例

import soundfile as sf

from voxcpm import VoxCPM

model = VoxCPM.from_pretrained("openbmb/VoxCPM-0.5B")

wav = model.generate(

text="VoxCPM is an innovative end-to-end TTS model from ModelBest, designed to generate highly expressive speech.",

prompt_wav_path=None, # optional: path to a prompt speech for voice cloning

prompt_text=None, # optional: reference text

cfg_value=2.0, # LM guidance on LocDiT, higher for better adherence to the prompt, but maybe worse

inference_timesteps=10, # LocDiT inference timesteps, higher for better result, lower for fast speed

normalize=True, # enable external TN tool

denoise=True, # enable external Denoise tool

retry_badcase=True, # enable retrying mode for some bad cases (unstoppable)

retry_badcase_max_times=3, # maximum retrying times

retry_badcase_ratio_threshold=6.0, # maximum length restriction for bad case detection (simple but effective), it could be adjusted for slow pace speech

)

sf.write("output.wav", wav, 16000)

print("saved: output.wav")

CLI 快速调用

# 直接生成语音

voxcpm --text "Hello world!" --output out.wav

# 声音克隆

voxcpm --text "This is cloned voice." \

--prompt-audio sample.wav \

--prompt-text "reference transcript" \

--output cloned.wav

在线体验

如果你不想本地折腾,可以直接在官方提供的 Demo 里试用:

Demo体验:https://huggingface.co/spaces/OpenBMB/VoxCPM-Demo

Hugging Face: https://huggingface.co/openbmb/VoxCPM-0.5B

上传一段语音或直接录音,使用 VoxCPM 参考合成一段新的音频

原声:

生成效果:

相似项目推荐

如果你对语音合成和声音克隆感兴趣,还可以关注:

-

VALL-E(微软):同样主打零样本语音克隆

-

StyleTTS 2:在表达力和音色控制方面更强

-

OpenVoice(MyShell):社区应用较广,适合快速尝试

相比之下,VoxCPM 的优势是开源、轻量、中文支持更好。

总结

作为一个经常体验AI工具的产品经理,我觉得 VoxCPM 给我的最大惊喜是 自然度和易用性。 过去很多TTS听起来“像机器人”,但 VoxCPM 的输出已经接近真人;再加上零样本声音克隆,它不仅能“说话”,还能“说出你自己的声音”。

如果你想探索 AI 语音生成在内容创作、教育、甚至虚拟人领域的可能性,VoxCPM 值得一试