无论是工作应用,还是学习娱乐,大家都想拥有一个自己能为自己所有的大模型对话机器人,但又不知道从何入手。

苏米告诉大家有的一个好消息是,不需要从头造轮子,GitHub上已经有一批成熟的开源项目,可以让你低成本甚至零成本地搭建出属于自己的AI助手。

今天我挑了 5 个最具代表性的开源项目,覆盖从框架到模型、从微调到前端壳子,基本能满足不同层级的需求。

1. LangChain

有人说现在谁在用LangChain了,都快淘汰了,我想说的是入门用它准没错。它的定位更像是一个开发框架,帮你把不同的语言模型(GPT、LLaMA、文心一言等)和外部工具(数据库、文档搜索、API调用)组合起来,构建更复杂的对话应用,非常经典也非常适合入门。

核心功能:

-

模型集成:支持各种大模型自由切换。

-

对话管理:让机器人记住上下文,保持连贯交流。

-

工具调用:查天气、跑代码、算数据都行。

-

文档解析:能读懂长文档并提炼关键信息。

应用场景: 企业知识库问答、带代码执行能力的AI助手、PDF报告分析工具。

安装体验:

pip install langchain openai

几行代码就能跑起来,但要做复杂应用,需要自己“拼搭”。

对比优势: 灵活度远超直接调用API,支持模型和工具最多,新手入门首选。

2. LLaMA

再来说说LLaMA,这个Meta 开源的 LLaMA 被认为是开源大模型中的天花板,参数规模从 7B 到 288B 不等,虽然对话能力不及 ChatGPT,但胜在开源免费(非商用)且能本地化部署。

核心功能:

-

多语言支持(中文表现不错)。

-

聊天、写文案、翻译、简单推理。

-

参数规模可选,小模型适合PC,大模型更接近商用效果。

应用场景: 企业内网客服机器人、本地专属领域AI助手(医疗、法律等)。

部署方式:

借助 ,可以在CPU甚至普通显卡上跑。

对比优势: 相比商业模型,数据更安全;相比其他开源大模型,中文支持和微调生态更好。

3. Rasa

如果说LangChain更适合入门,那么Rasa则更像是给高配团队进行深度定制开发的大模型框架。它具有开源免费、高度可定制、支持复杂对话管理和多渠道集成等优点,尤其适用于注重数据隐私和安全的场景。

核心功能:

-

意图识别:理解用户需求,比如“查订单”。

-

实体提取:识别出订单号、日期等关键信息。

-

流程管理:支持多轮对话逻辑(如先验证身份再查询)。

-

全渠道集成:可接入微信、网站、APP。

应用场景: 电商售后机器人、政务服务机器人、企业客服问答。

安装体验:

pip install rasa

rasa init

几乎不用写太多代码,配置即可。

对比优势: 开源可本地部署,比LLM更可控,尤其适合有明确流程的企业场景。

4. Alpaca-LoRA

上学习强度了,这是由斯坦福大学基于 LLaMA 微调而来,使用 LoRA 技术,效果接近 GPT-3.5,但只需 7B 参数,普通显卡也能运行。

核心功能:

-

聊天、写代码、翻译、总结文章。

-

训练成本低,支持轻量化微调。

-

响应速度快,适合实时对话。

应用场景: 本地轻量化聊天机器人、快速验证AI应用想法、低成本专属模型微调。

安装体验:

基于 PyTorch 部署,学生和独立开发者也能轻松上手。

对比优势: 比原版LLaMA更自然,比商业GPT更便宜。

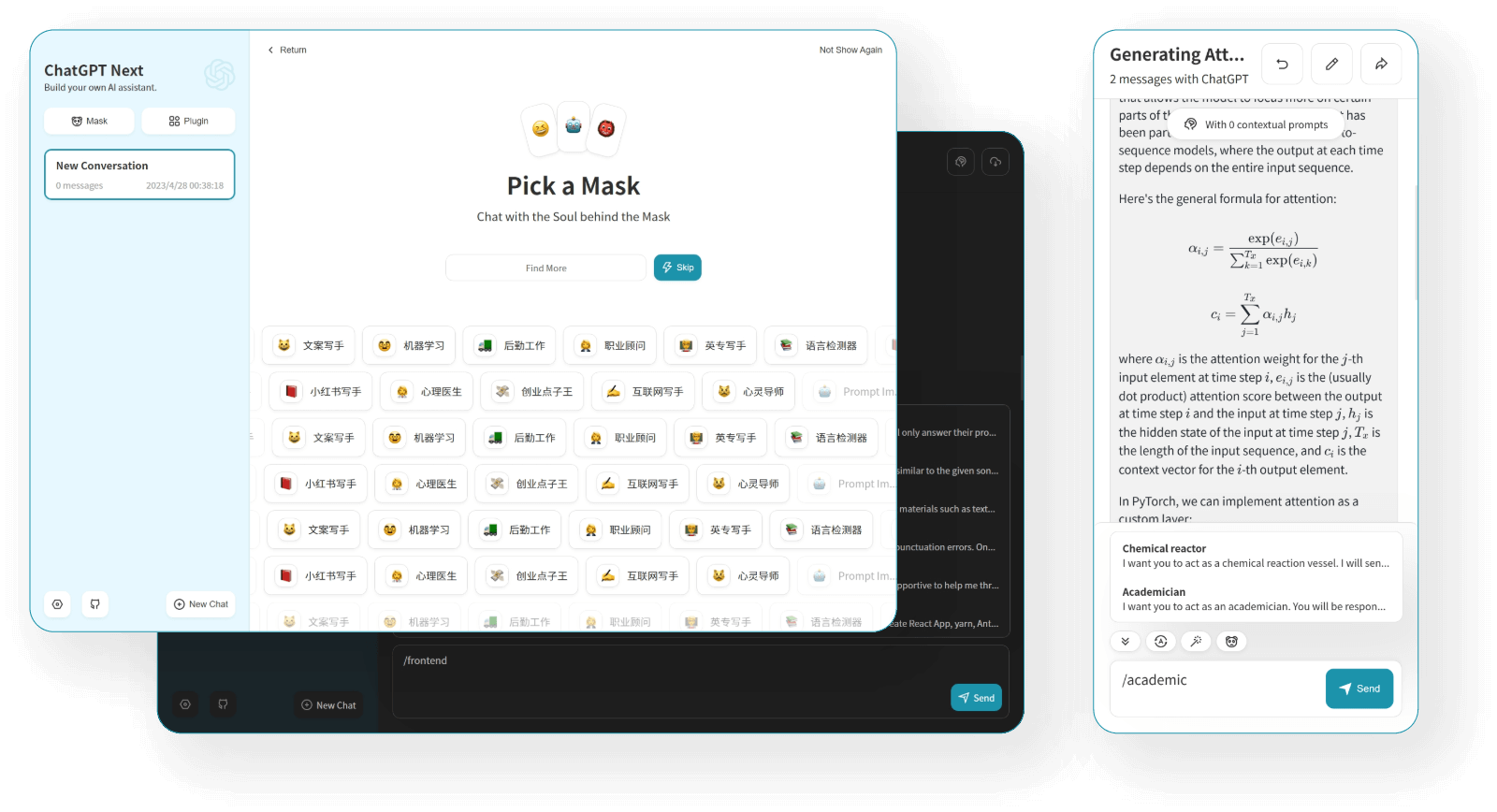

5. ChatGPT-Next-Web

有了本地模型,那么搭一个本地的ChatGPT就变得更有必要了,这是个开箱即用的ChatGPT网页壳子,本质是调用OpenAI API,但提供了一个自带界面的开源前端,支持部署在自己服务器上,虽然说现在也有很多可替代的,但苏米觉得还是这个最经典。

核心功能:

-

类似官网的聊天界面,支持上下文对话。

-

模型切换(GPT-3.5/GPT-4)。

-

聊天记录导出(Markdown/PDF)。

-

自定义访问密码,防止滥用。

应用场景: 团队内部共享AI助手、个人ChatGPT网页版、小型二次开发。

安装体验:

支持 Docker 一键部署,非常小白友好。

对比优势: 相比直接用官网,更可控、更自由,二次开发成本低。

总结

如果你把这 5 个开源项目玩明白了,那么AI大模型就算是入门了,后面可做的事就非常多了!

是开发者,建议先从 ChatGPT-Next-Web 入手快速体验;如果想做更复杂的企业级应用,可以结合 LangChain + LLaMA/Alpaca-LoRA;而需要业务流程控制的企业客服,Rasa 才是最佳选择。