最近在浏览Google的AI开源项目时,发现了一个值得关注的动向:Google将其多年积累的翻译能力整合进了一个开源大模型,取名TranslateGemma。

这不是通用模型顺带的翻译功能,而是从架构设计到训练目标都围绕翻译任务专门优化的模型。

作为产品经理,我认为这个项目展现了一个重要的技术趋势——专用模型正在取代通用模型去解决特定领域的问题,值得开发者和企业重点关注。

项目概述

TranslateGemma是基于Gemma 3架构的开源翻译专用模型。

Google提供了3个规模版本供不同场景选择:

- 4B版本:最轻量,适合移动端和边缘设备部署

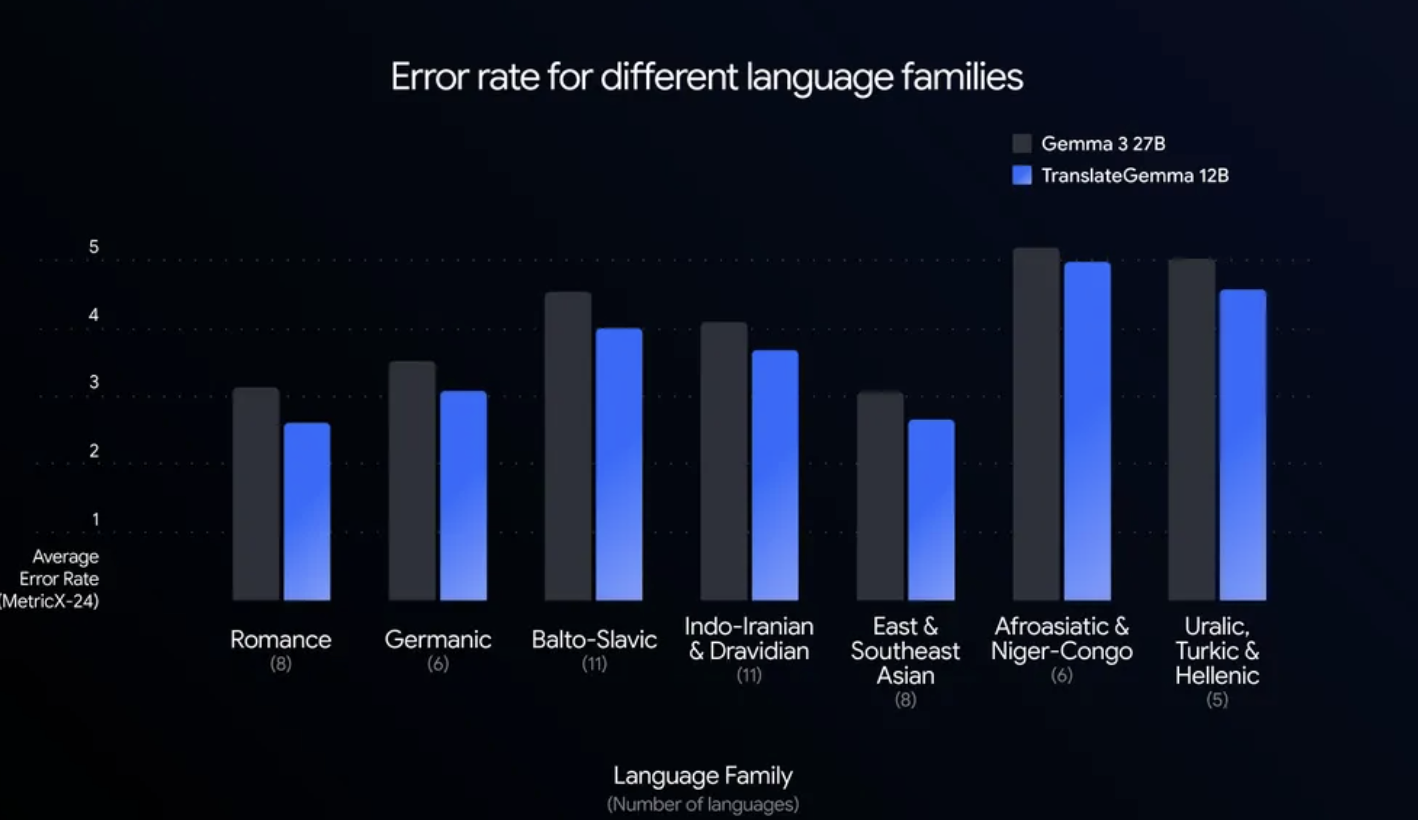

- 12B版本:性能与效率的最优平衡点,官方数据表明其性能实际超越27B版本

- 27B版本:最大规模,适合对翻译质量要求极高的场景

从部署门槛来看,4B和12B两个版本可直接在消费级显卡上运行,这大幅降低了企业部署专业翻译系统的硬件成本。

核心功能特性

1. 语言覆盖范围

支持55种语言的翻译,涵盖了主流语言(英语、中文、日语等)到低资源语言的全面优化。这个覆盖面对于需要处理多语言内容的企业来说,意味着可以用一个统一的模型替代多套翻译方案。

2. 多模态翻译能力

TranslateGemma支持图文识别翻译,可直接处理图像中的文字内容,无需先进行OCR后再翻译。这对于处理截图、扫描件、UI界面本地化等场景有直接价值。

3. 翻译质量优化

采用了两阶段微调策略:

- SFT阶段(监督微调):使用Gemini生成的高质量合成数据进行训练,确保模型在多语言场景下的基础表现

- RL阶段(强化学习):通过奖励模型针对翻译的准确性、流畅度进行专门优化,使输出结果更符合语境、更自然

这个做法相比简单的微调,更能针对翻译任务的特殊性进行优化。

应用场景与适配性

基于上述特性,TranslateGemma适合以下几类使用场景:

| 场景类型 | 具体应用 |

| 本地化和国际化 | SaaS产品的多语言UI翻译、文档本地化、应用商店描述翻译等 |

| 内容处理 | 跨境电商商品描述翻译、多语言内容审核、字幕生成等 |

| 隐私敏感场景 | 医疗、法律、金融等需要数据本地化处理的垂直领域 |

| 边缘计算 | 移动应用内嵌翻译、离线翻译功能等 |

| 成本优化 | 替代商业翻译API,降低长期翻译服务成本 |

技术原理分析

TranslateGemma的竞争力主要源于以下几点:

1. 强大的基座模型

基于Gemma 3,本身就具备较强的推理能力和多模态理解能力,这为翻译专业化提供了好的起点。

2. 数据护城河

Google几十年积累的翻译数据(Web语料挖掘、平行语料库等)是其他开源项目难以复制的优势。高质量的数据直接影响翻译的准确度和自然度。

3. 系统化的优化策略

两阶段微调不是简单的叠加,而是有明确分工的:SFT保证广覆盖,RL针对专业性。这个设计思路值得其他专用模型参考。

安装与部署

Google官方提供了多种快速开始方式:

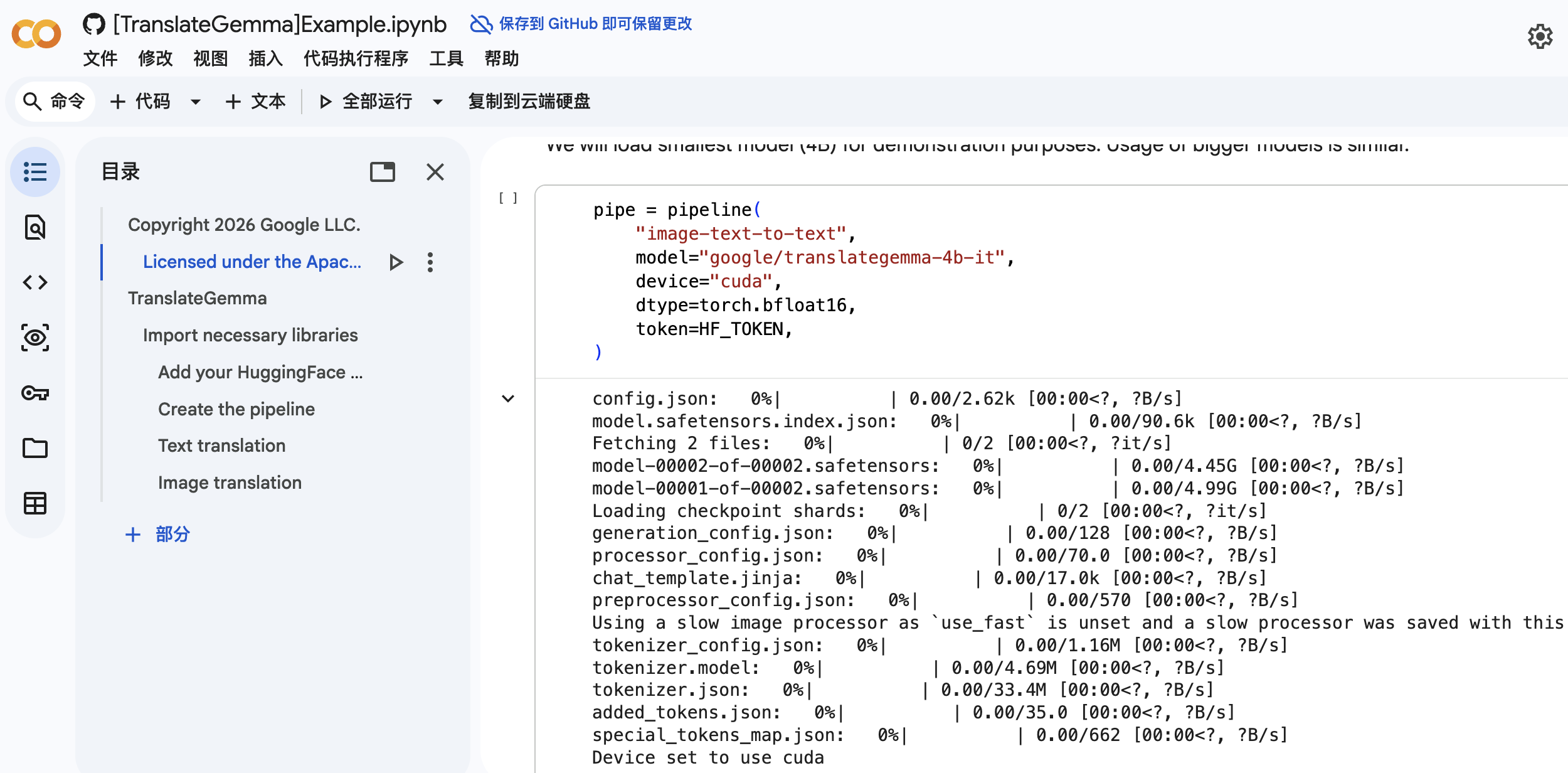

快速体验(无需本地部署)

可以直接在Google Colab中运行官方提供的示例notebook:

https://colab.research.google.com/github/google-gemini/gemma-cookbook/blob/main/Research/[TranslateGemma]Example.ipynb

这种方式适合快速评估模型效果,无需任何本地配置。

本地部署

对于需要集成到生产环境的使用者,可以从Hugging Face获取模型文件:

https://huggingface.co/collections/google/translategemma

12B版本在单张消费级GPU(如RTX 3080)上即可完整运行,推理速度满足实时应用需求。4B版本甚至可以在一些高端手机上部署。

相关项目对比

考虑到开发者可能在多个翻译模型间进行选择,这里做一个基本的对比参考:

| 模型/方案 | 语言覆盖 | 部署复杂度 | 多模态支持 | 定位 |

| TranslateGemma | 55种 | 低 | 有 | 专用翻译模型 |

| Google翻译API | 100+种 | 无(云服务) | 有 | 商业服务 |

| Meta M2M100 | 100种 | 中等 | 无 | 开源翻译模型 |

| 通用大模型(GPT/Claude) | 理论无限 | 需付费API | 有 | 通用模型附带功能 |

从表格可以看出,TranslateGemma的优势在于:相比商业API具有隐私和成本优势,相比其他开源模型具有质量和多模态能力优势。

配置与使用建议

模型版本选择

- 如果机器配置有限或需要边缘部署:选择4B版本

- 如果追求性价比:选择12B版本(官方推荐,性能超越27B)

- 如果对翻译质量有极高要求且硬件充足:选择27B版本

集成方式

可通过Hugging Face Transformers库进行标准集成,或使用Ollama、LM Studio等本地大模型管理工具进行部署,降低集成难度。

性能优化

12B版本的推理速度足以支持实时应用,如需进一步优化可考虑量化处理(INT8、FP16等),在保证质量的前提下进一步降低显存占用。

总结

TranslateGemma代表了开源翻译模型的一个新方向:从通用能力到专用优化。Google在这个项目上的做法——将核心能力以开源形式开放给开发者——打破了高质量翻译服务长期被商业API垄断的局面。

从产品角度看,这个项目的价值在于:

- 降低门槛:让中小企业也能部署媲美商业服务的翻译能力

- 增强隐私:敏感内容可以完全本地处理,无需上传到第三方服务

- 提供灵活性:支持定制化微调和集成,适应不同业务需求

如果你的业务涉及多语言处理、本地化需求、或者对翻译成本敏感,TranslateGemma 12B值得作为技术选型的重点评估对象。建议先在Colab上快速验证效果,再决定是否投入本地部署。

参考资源

- 官方博客:https://blog.google/innovation-and-ai/technology/developers-tools/translategemma/

- 模型仓库:https://huggingface.co/collections/google/translategemma

- Colab示例:https://colab.research.google.com/github/google-gemini/gemma-cookbook/blob/main/Research/[TranslateGemma]Example.ipynb

```