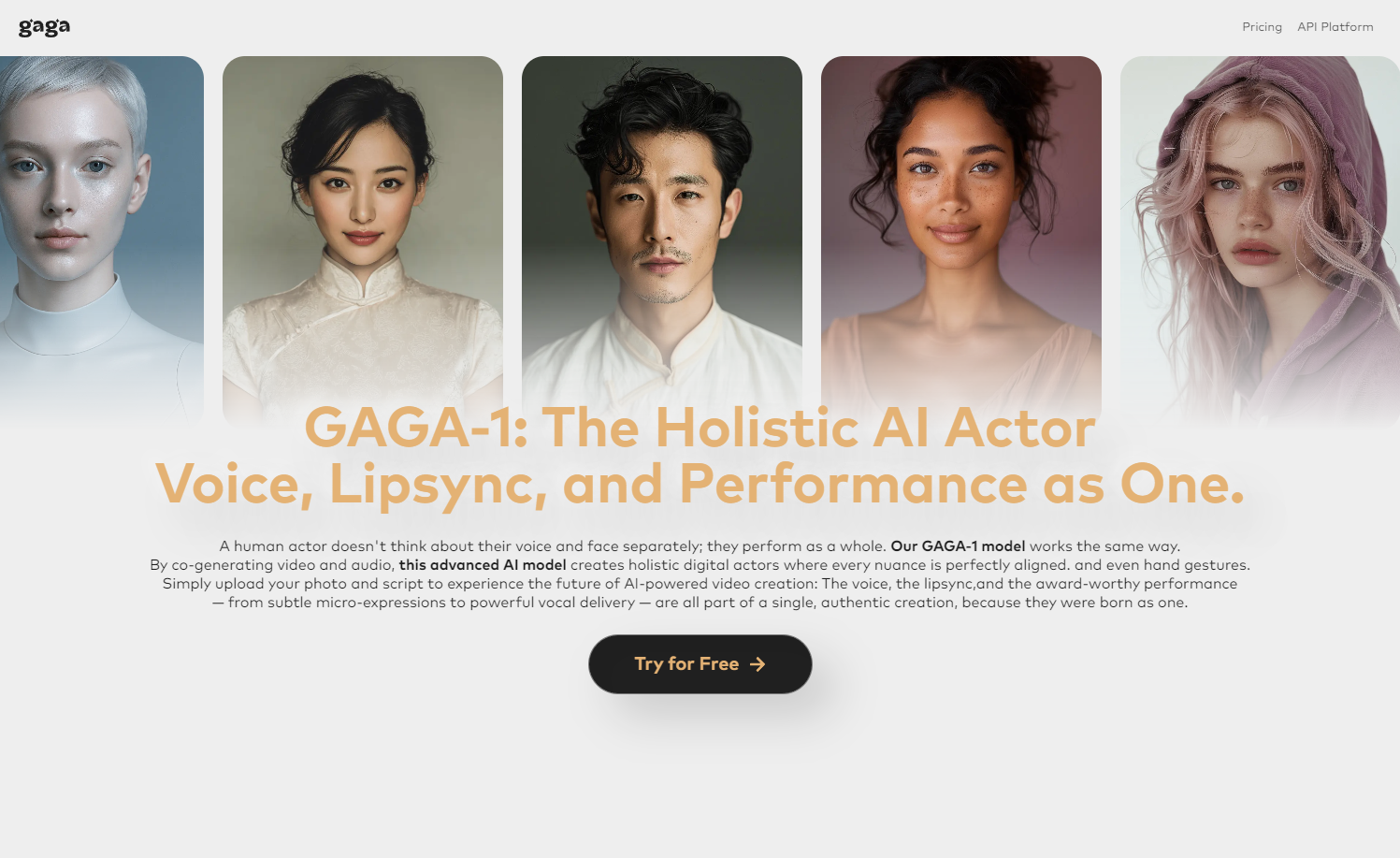

凌晨刷到一个国产新项目——Gaga AI,一句话总结:

一张照片 + 一段台词 = 3分钟后出片,效果像电影片段。

听起来像Sora的平替,但重点是——它已经免费全量开放,无需邀请码,上线地址:。

我第一时间冲了进去体验,结果可以说是:惊喜大于预期。

实测体验

Gaga AI 背后的 GAGA-1 视频模型 是 Sand.ai 团队打造的,他们不是做“AI说话”,而是死磕一个方向——让AI学会“演”。 不只是嘴动得对,而是表情、语气、情绪都能对上,连背景音都自动生成。

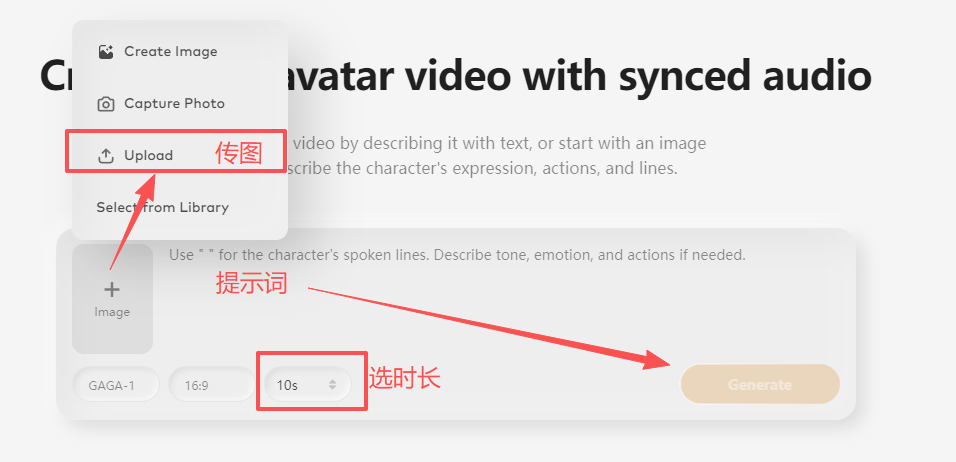

实际操作极其简单:

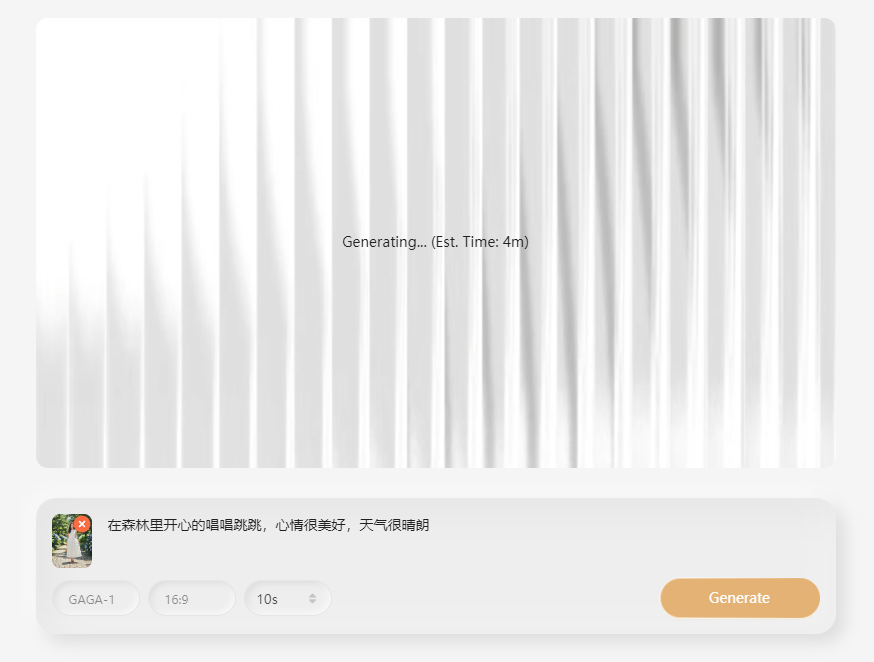

上传一张图片(或者用AI直接生成首帧图),输入台词/提示词,选择参数

等待几分钟,自动生成视频

目前支持:

-

视频长度:最长 10 秒

-

分辨率:最高 720p

-

比例:16:9

-

实测生成速度:10秒视频 < 5分钟 建议在电脑端体验,网页操作更顺畅。

我第一次上传的还是剧照截图,结果AI把那种「微妙的嘴角上扬」和「眼神转折」都学了个八九不离十,看得我有点惊。

AI“演员”的专业素养

1. 音画同出,才有灵魂

Gaga AI 的最大突破是声音和画面同步生成。

传统方法是“先画后配”,但这样人物表情和语气往往脱节。

Gaga直接把声画融合生成,这种“一体感”是AI视频自然流畅的关键。

2. 表情与口型的「演技细节」

我试着上传了几张不同演员的剧照,它在嘴型、情绪、甚至眼神细节上都能对应生成,整体逼真度远超同类产品。

3. 支持双人“对手戏”

更惊喜的是,它能在单画面中生成两个人物对话。

我随手找了两张图测试,只要原图清晰,双人互动的表情也能保持稳定,场面竟然有点戏剧感。

4. 多语种也能演

Gaga AI 自带的语音合成(TTS)效果出奇地好,我测试了中文、英文、西语都挺自然。

这让我突然想到,如果品牌有一张静态海报,现在是不是可以直接“变成”多语言的广告视频了?

提示词的关键技巧

玩了一圈后,我发现提示词在生成质量上真的很重要。

Gaga的格式和影视剧本思维很像:

-

台词用引号“”括住,是角色要说的话。

-

情绪、动作、停顿等导演指令用括号()括住。

-

语言要一致,比如想生成日语对白,文字和括号内说明都用日语。

-

视频时长要和台词字数匹配:

-

短句 ≈ 5秒

-

长句 ≈ 10秒 这样不会出现“卡顿”或“掉字”问题。

-

我总结的结构是:

情绪 + 台词 + 环境 + 摄影参数 + 音效/氛围

一个实用示例

(语气轻柔,音色温暖)“现在,跟着我的声音,一起慢慢放松。”

(停顿两秒)

“闭上眼睛,感受每一次呼吸都带走疲惫……”

生成出来的效果,真有那种ASMR治愈感。

使用感受

体验完后我觉得,GAGA-1 模型确实在“表演”层面领先了一步。

但它也有明显的边界:

-

远景镜头下细节模糊

-

多角色场景稳定性不足

-

镜头切换和动态视角受限

不过这并非缺点。对需要“单角色高质量演绎”的视频创作者来说,这种稳定单镜头反而是优点。

更重要的是,Gaga AI 展示了一个方向:

在AI视频赛道里,“不什么都做”,而是“把一个点做到极致”。

Sand.ai 没去卷生成速度、分辨率这些指标,而是专注在让AI演得像人。

这种聚焦策略,反而让他们在最难啃的领域拿到了突破。

结语

Gaga AI 给我最大的启发是——AI不只是生成画面,而是在学习人类的“情绪表达”。

这点,才是真正让AI视频走向电影质感的关键。

最值得点赞的是,它完全开放,没有搞限量、内测、邀请码那一套。

想体验的朋友现在就能直接上去试,趁还没加额度限制,建议猛猛冲。

官网: