最近在浏览新开源项目时,发现了字节火山引擎开源的 OpenViking,这个项目在 GitHub 已收获 2.9K+ Star。

让我感兴趣的不是它来自大厂,而是它解决问题的思路——用文件系统范式来管理 AI Agent 的上下文。

这个视角很有启发性,因为它反映出一个长期困扰 Agent 开发者的核心问题:上下文管理的碎片化与成本失控。今天就来深入聊聊这个项目。

一、问题背景

要理解 OpenViking 的价值,先需要看清传统 AI Agent 上下文管理面临的具体问题:

- 碎片化存储:记忆分散在代码里,资源存放在向量数据库中,技能模块各自为政,没有统一的组织方式

- 成本压力:Agent 长期运行后,上下文信息不断积累。全量塞进 Prompt 会导致 Token 成本线性增长;简单截断又会丢失关键信息

- 检索精度有限:传统 RAG 依赖扁平的语义匹配,缺少层级结构和路径定位能力,精准度较低

- 可观测性缺失:整个检索链路完全黑盒,出现问题时难以定位根源

- 记忆积累不足:现有系统只记录对话历史,缺少 Agent 任务执行过程中的知识沉淀和经验复用机制

这些问题叠加在一起,使得 Agent 的上下文管理成为了开发效率的瓶颈。

二、项目核心定位

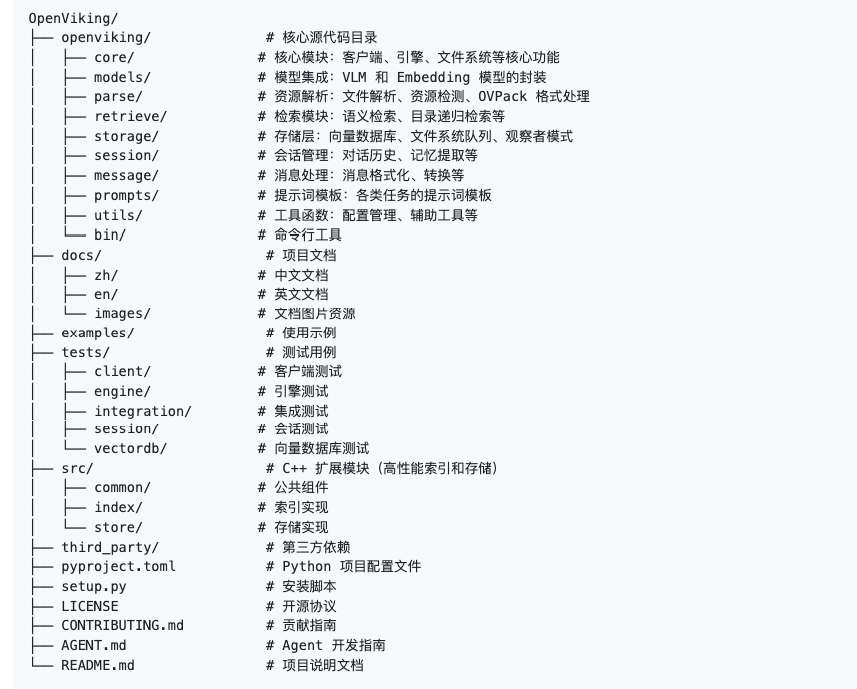

OpenViking 是一个专为 AI Agent 设计的上下文数据库,其核心创新在于采用文件系统范式来组织管理上下文。

具体来说,它将 Agent 的记忆(Memory)、资源(Resources)和技能(Skills)统一映射到一个虚拟文件系统中——开发者可以像管理本地文件一样来管理 Agent 上下文,通过目录结构、路径导航、文件搜索等熟悉的操作完成所有工作。

这个设计的妙处在于降低了学习成本,同时引入了层级组织的优势。

三、核心功能拆解

1. 文件系统化的上下文组织

将所有上下文数据统一存储在虚拟文件系统中:

- 记忆可以组织在不同的文件夹(如"用户偏好"、"历史任务"等)

- 资源文件直接对应具体的文档、数据或配置

- 技能模块映射为可执行的程序对象

- 支持多层级目录结构,自定义组织方式

2. 分层上下文按需加载机制

采用 L0/L1/L2 三层架构设计:

- L0 层:核心高频信息,常驻内存,包括当前任务的关键上下文

- L1 层:次重要信息,根据任务需求动态加载

- L2 层:历史存档数据,按需读取

这种设计直接解决了 Token 成本问题——只有必要的信息才会被纳入 Prompt,而不是盲目全量加载。

3. 目录递归检索 + 语义搜索融合

检索能力结合了文件系统的精准定位和语义理解:

- 支持按目录路径定位

- 支持递归深度搜索

- 融合语义相似度匹配

- 精准召回相关上下文

相比传统 RAG 的单一语义匹配,这种方式既有结构化的准确性,又有语义的灵活性。

4. 可视化检索轨迹

支持可视化展示整个检索过程:

- 查看 Agent 从哪个目录开始检索

- 追踪递归进入的子路径

- 了解资源加载的决策过程

- 完整展现检索链路

这一特性弥补了大多数 RAG 系统的黑盒问题,便于问题排查和性能优化。

5. 自动会话管理与长期记忆沉淀

系统会自动处理:

- 对话历史的智能压缩(去除冗余信息)

- 工具调用历史的整理

- 资源引用的追踪

- 长期记忆的自动提取和沉淀

这意味着 Agent 会逐步积累经验,下次遇到类似场景时能直接调用之前的解决方案。

四、安装与配置

1. 环境安装

最直接的方式是通过 pip:

pip install openviking

若需要 CLI 工具,也可安装 Rust 版本:

curl -fsSL https://raw.githubusercontent.com/volcengine/OpenViking/main/crates/ov_cli/install.sh | bash

2. 模型配置

OpenViking 需要两类模型:

- VLM(视觉语言模型):用于内容理解和多模态处理

- Embedding 模型:用于文本向量化和语义检索

项目支持多个模型提供商,包括火山引擎、OpenAI、Anthropic、DeepSeek、Google、Moonshot、智谱、通义、MiniMax 和本地 vLLM。系统会根据模型名称自动检测提供商类型,切换极其便利。

3. 配置文件设置

需要创建 ~/.openviking/ov.conf 文件,配置格式如下:

{ "embedding": { "dense": { "api_base": "", "api_key": "", "provider": "", "dimension": 1024, "model": "" } }, "vlm": { "api_base": "", "api_key": "", "provider": "", "model": "" } }

以火山引擎豆包为例的完整配置:

{ "embedding": { "dense": { "api_base": "https://ark.cn-beijing.volces.com/api/v3", "api_key": "your-api-key", "provider": "volcengine", "dimension": 1024, "model": "doubao-embedding-vision-250615" } }, "vlm": { "api_base": "https://ark.cn-beijing.volces.com/api/v3", "api_key": "your-api-key", "provider": "volcengine", "model": "doubao-seed-1-8-251228" } }

如果倾向于本地部署,也可通过 vLLM 运行:

vllm serve meta-llama/Llama-3.1-8B-Instruct --port 8000

然后配置:

{ "vlm": { "provider": "vllm", "model": "meta-llama/Llama-3.1-8B-Instruct", "api_base": "http://localhost:8000/v1" } }

五、快速上手示例

创建一个基础脚本体验核心功能:

import openviking as ov

client = ov.SyncOpenViking(path="./data")

try:

client.initialize()

# 添加资源(支持 URL、文件或目录)

add_result = client.add_resource(path="https://raw.githubusercontent.com/volcengine/OpenViking/main/README.md")

root_uri = add_result['root_uri']

# 浏览目录结构

ls_result = client.ls(root_uri)

print(f"Directory: {ls_result}")

# 模糊匹配查找文件

glob_result = client.glob(pattern="**/*.md", uri=root_uri)

if glob_result['matches']:

content = client.read(glob_result['matches'][0])

print(f"Content: {content[:200]}")

# 等待语义处理完成

client.wait_processed()

# 获取摘要和概览

abstract = client.abstract(root_uri)

overview = client.overview(root_uri)

print(f"Abstract: {abstract}")

# 语义搜索

results = client.find("what is openviking", target_uri=root_uri)

for r in results.resources:

print(f"{r.uri} (score: {r.score:.4f})")

client.close()

except Exception as e:

print(f"Error: {e}")

运行结果会展示资源目录结构、内容预览、摘要概览和语义搜索的相关度评分。

六、部署选择

OpenViking 支持两种部署模式:

- 本地模式:适合开发和测试阶段,数据存储在本地目录

- 服务模式:火山引擎提供托管的 HTTP 服务版本,支持更高的并发和持久化需求,适合生产环境

服务部署的详细配置可参考官方文档:OpenViking 服务部署指南

七、相关项目对比参考

当前 AI Agent 领域还有其他上下文管理方案,如 RAG 框架(LangChain、LlamaIndex)和记忆系统(MemGPT 等),但它们多聚焦于特定维度的问题。OpenViking 的差异化在于:

- 采用文件系统范式而非数据库范式,降低认知负荷

- 内置分层加载机制,直接优化 Token 成本

- 融合路径定位和语义搜索,检索精度更高

- 提供完整的可观测性,支持链路可视化

- 自动处理会话压缩和长期记忆沉淀

总结

从产品设计的角度看,OpenViking 的价值在于用一个简洁的范式(文件系统)统一解决了 AI Agent 上下文管理的多个痛点。这个思路很有借鉴意义——有时候最好的解决方案不是更复杂的技术,而是更贴切的抽象。

如果你正在开发 AI Agent 相关产品,特别是需要处理长期运行、复杂任务、上下文管理困难的场景,OpenViking 值得深入体验。它既可以作为独立的上下文管理层集成到现有系统中,也可以作为 Agent 框架的基础组件使用。

项目地址:https://github.com/volcengine/OpenViking

官方文档:OpenViking 中文文档